Quando si parla di evoluzione nel campo dei modelli linguistici IA, non si può ignorare l’arrivo del nuovo modello cinese Qwen3. Questa nuova famiglia di modelli open source è stata presentata ieri dal team di Alibaba Cloud. L’obiettivo è quello di svincolarsi dai modelli proprietari delle grandi aziende americane.

Qwen3 si distingue per la sua struttura flessibile, che combina dense model e architetture Mixture of Experts (MoE); i primi utilizzano tutti i parametri in ogni inferenza, mentre i secondi selezionano dinamicamente solo una parte degli esperti disponibili, ottimizzando così il consumo di risorse. Sono quindi modelli AI capaci di adattarsi a diversi carichi di lavoro e necessità di ragionamento.

Rispetto ai predecessori come Qwen2.5, il salto qualitativo è notevole; non solo per i risultati nei benchmark su matematica, coding e competenze generali, ma anche per la filosofia di rilascio estremamente aperta. Tutti i modelli vengono distribuiti sotto licenza Apache 2.0, senza restrizioni sulle applicazioni commerciali. Se vuoi provare subito Qwen3, la sua chat conversazionale (multimodale) è disponibile gratuitamente a questo link https://chat.qwen.ai/.

Qwen3: dalla potenza titanica all’agilità da tasca

La gamma di Qwen3 copre un ampio spettro di esigenze; si adatta a contesti e dispositivi molto diversi tra loro. Ci sono 6 varianti. Si parte da modelli ultraleggeri da 0.6B di parametri; ideali per dispositivi mobili, applicazioni edge o piccoli server locali. Si arriva fino al modello gigante da 235B di parametri; perfetto per progetti di ricerca complessi.

Gli sviluppatori hanno la possibilità di scegliere sulla base di criteri precisi: latenza, memoria disponibile, complessità computazionale prevista. Questa flessibilità consente di ottimizzare le risorse senza sacrificare l’efficienza operativa. Ogni modello è progettato per massimizzare l’usabilità pratica; garantisce compatibilità con framework come llama.cpp, Ollama, LMStudio e altri strumenti di distribuzione rapida.

I modelli più robusti supportano context window estese fino a 128K token per applicazioni che richiedono memoria contestuale ampia, come analisi documentali o agenti multi-turno. In particolare, il processo di “Strong-to-Weak Distillation” ha permesso di mantenere un’elevata qualità di output anche nelle versioni più leggere.

Architettura ibrida

Un tratto che definisce Qwen3 è la capacità di passare con agilità tra modalità “thinking” e “non-thinking”. Questo sistema ibrido consente di adattarsi con naturalezza alle diverse complessità dei problemi; permette di selezionare dinamicamente il tipo di ragionamento da applicare. Quando la questione è articolata, la modalità “thinking” attiva una catena di pensiero passo-passo; se invece è necessario solo un output immediato, la modalità “non-thinking” fornisce risposte rapide e dirette.

Il modello più grande, Qwen3-235B-A22B, arriva a gestire 235 miliardi di parametri totali; tuttavia, grazie alla architettura Mixture of Experts (MoE) ne attiva solo 22 miliardi alla volta a seconda della domanda richiesta. In questo modo mantiene l’efficienza computazionale sotto controllo.

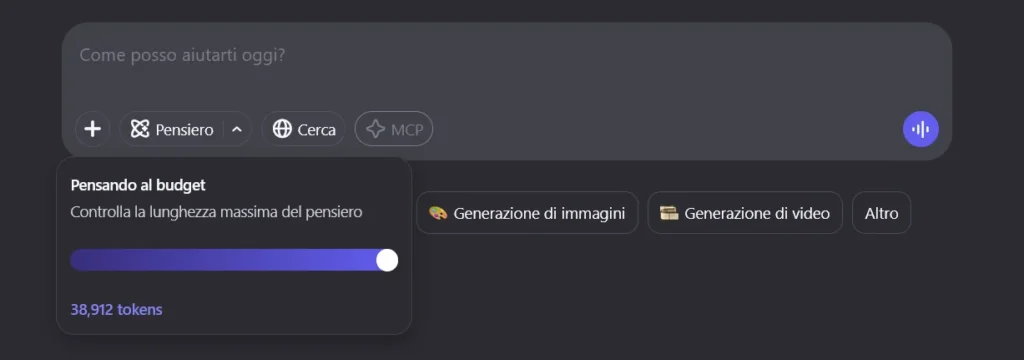

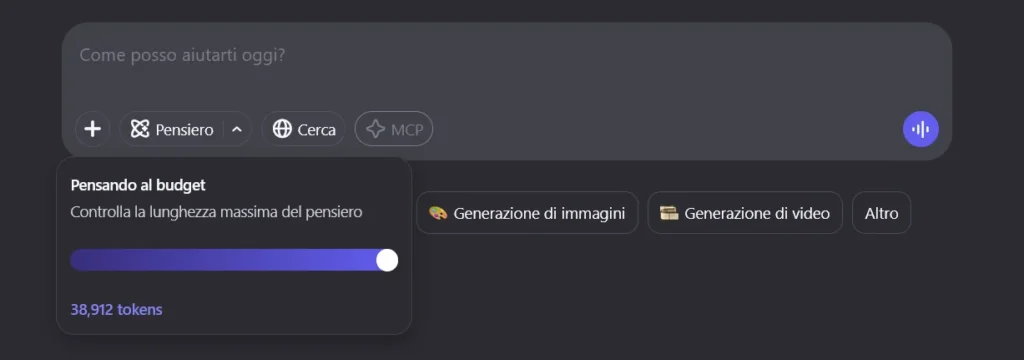

Il modello Qwen3 Dense (Quen3-32B) da 32 miliardi di parametri, al contrario, utilizza tutti i parametri a ogni calcolo; risultano più lenti e onerosi sotto il profilo computazionale. Qwen3 introduce anche la possibilità di selezionare il “thinking budget” (“Pensando al budget“), ovvero quanti token allocare alla richiesta.

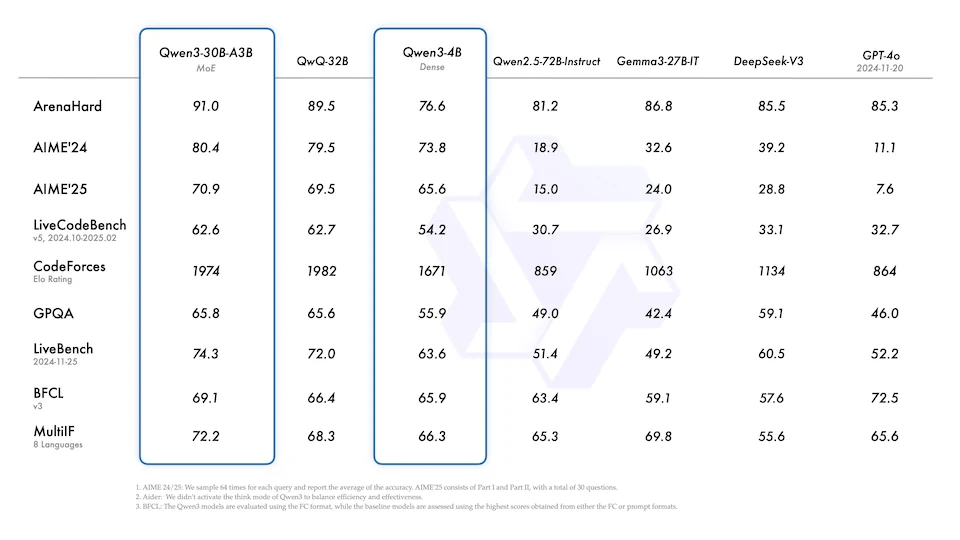

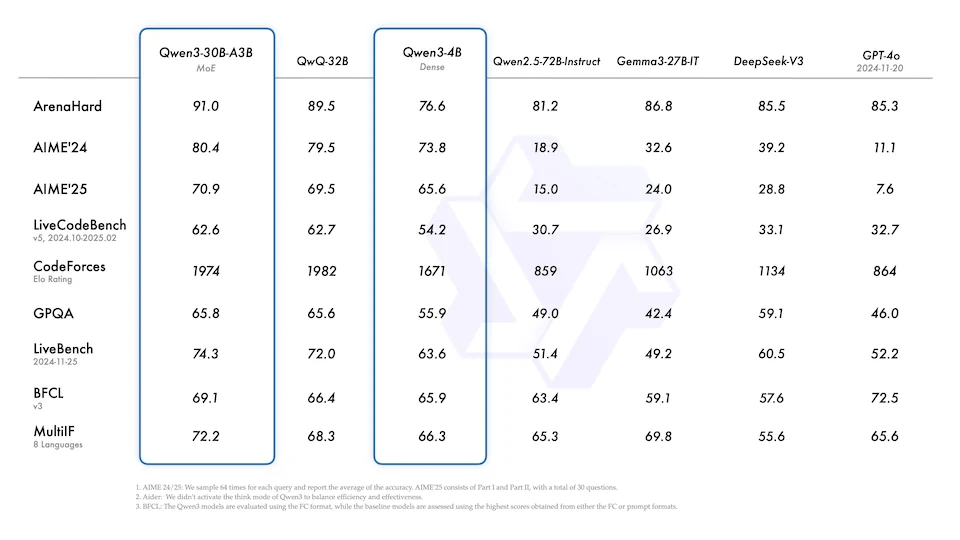

Benchmark: Qwen3 nel confronto globale

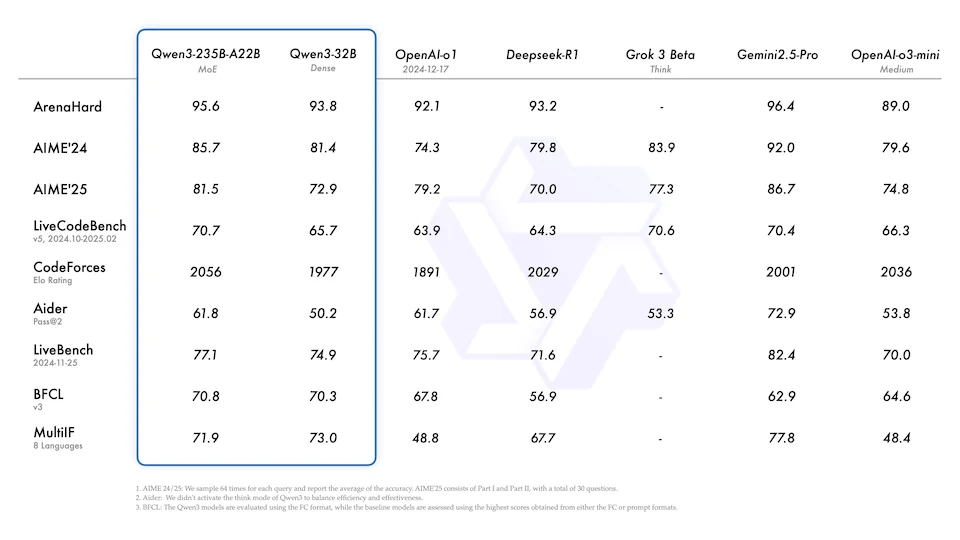

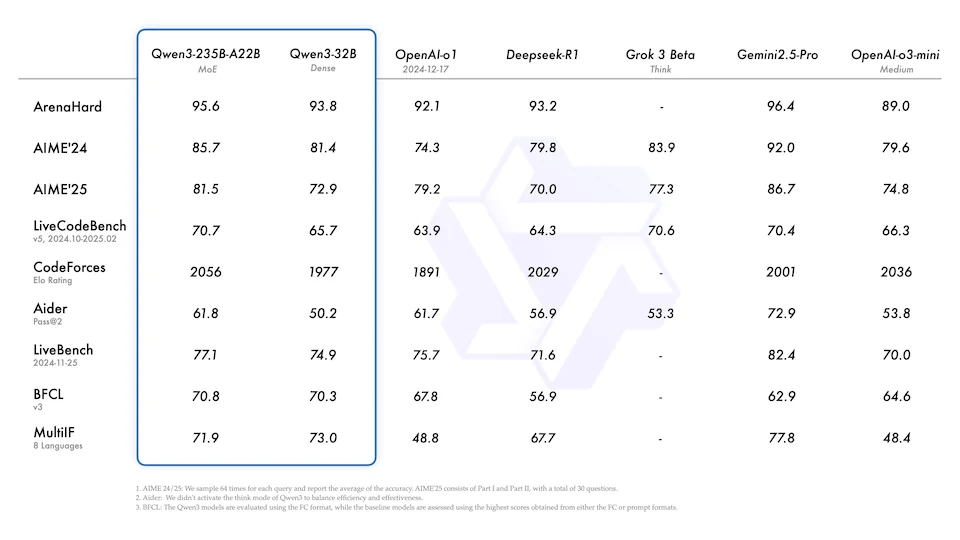

Le prestazioni di Qwen3 nei benchmark mostrano che il modello Qwen3-235B-A22B supera OpenAI o1 e DeepSeek R1 su alcuni test IA come ArenaHard che include domande avanzate di ingegneria del software e matematica.

Inoltre, si avvicina sensibilmente ai livelli prestazionali di Gemini 2.5-Pro di Google; dimostra una tenuta comparabile senza risultare inferiore. Questa vicinanza nei risultati consolida la reputazione di Qwen3 tra i modelli di punta. Anche le versioni più compatte. Il modello Qwen3-4B (4 miliardi di parametri), riescono a competere nello stesso range tabellare di GPT-4 e DeepSeek V3. Addirittura il punteggio CodeForces raggiunge 1671 Elo e supera di quasi il doppio il punteggio di GPT-4o (864 Elo) ! Un risultato eccezionale per modelli di queste dimensioni ridotte. Avresti immaginato qualche anno fa che un modello di intelligenza artificiale le cui dimensioni possono essere salvate su un DVD, sarebbe stato in grado di creare codice su richiesta?

Un altro modello Qwen3 che in queste ore è in hype su Reddit è il modello Qwen3-30B-A3B. E’ un modello 30B (30 miliardi di parametri), ma grazie alla Mixture of Experts (MoE) attiva solo 3 milardi di parametri alla volta (Active 3B). Questo significa un’inferenza molto veloce, ovvero tempi di risposta (espressi in token/sec) molto ridotti. Un utente reddit ha riportato 130 token/sec su desktop con Nvidia 4090.

Quantizzazione estrema: modelli più leggeri per tutti

Una delle novità più interessanti attorno a Qwen3 è proprio la disponibilità di versioni estremamente leggere grazie alla quantizzazione FP8. Alcuni modelli riescono a occupare solo 2GB di spazio; un valore sorprendente considerando le capacità offerte. La quantizzazione FP8 (floating point 8-bit) permette di rappresentare i pesi del modello usando solo 8 bit; riducendo drasticamente la memoria necessaria.

Questa tecnica consente di eseguire modelli complessi su hardware modesto; come laptop di fascia media o GPU consumer. Il compromesso tra dimensione e qualità resta molto ben bilanciato; mantenendo risposte fluide e accurate nella maggior parte dei casi pratici. La riduzione a FP8 diventa una leva fondamentale per rendere l’intelligenza artificiale avanzata realmente accessibile a chiunque voglia sperimentare o integrare modelli evoluti senza infrastrutture costose. I processori con NPU integrata cominciano ad avere senso.

La capacità di mantenere alte prestazioni con un footprint ridotto amplia enormemente gli scenari di utilizzo e i costi di esecuzione; dalla ricerca scientifica ai computer domestici fino ai sistemi embedded. Questo miglioramento dinamico colloca Qwen3 tra i candidati più seri nella corsa ai migliori LLM open disponibili sul mercato; una presenza credibile che ridefinisce il concetto di accessibilità nella fascia alta dell’intelligenza artificiale.

Conclusione: Qwen 3

L’adozione di licenze permissive di Qwen3, l’integrazione perfetta con gli ecosistemi open source e la qualità nei dettagli di implementazione mostrano che l’innovazione non è più prerogativa di pochi colossi chiusi su se stessi.

In un panorama che tende spesso a privilegiare modelli chiusi e a volte costosi, le soluzioni cinesi di Qwen3 (e anche Deepseek R1) portano con sé la promessa di un’intelligenza artificiale più aperta, più economica, più modulare e più rispettosa delle reali esigenze di chi crea.

Ma non finisce qui, Deepseek R2 sta per arrivare, continua a seguirci per rimanere informato.