Tra la valanga di annunci del Google I/O 2025, tra demo spettacolari e lanci, c’è stata una notizia che ha sorpreso molto chi presta attenzione alle tecnologie dei modelli linguistici AI. La notizia riguarda lo sviluppo di Gemini Diffusion; è una tipologia completamente nuova di LLM (large language model) sviluppata da DeepMind. Questo modello non usa come solito la generazione autoregressiva token dopo token; adotta invece un metodo derivato dai modelli di diffusione usati per creare immagini.

Come nella creazione delle immagini, invece di procedere da sinistra a destra, il modello Gemini Diffusion parte da rumore casuale e lo affina progressivamente fino a produrre testo coerente. Questo approccio consente di correggere in itinere, riduce la latenza iniziale e genera blocchi interi di testo in una sola passata.

Il risultato è un modello più veloce e più preciso in compiti iterativi. E’ un modello potenzialmente capace di ridisegnare il panorama degli LLM nei prossimi anni. Il fatto che Google abbia scelto di non enfatizzarlo troppo durante l’I/O 2025 lascia intendere che si tratti di una fase sperimentale. Chi ha osservato i dati e testato la demo ne ha colto il potenziale. Non si tratta di una semplice variazione tecnica; è un cambio di paradigma che, se consolidato, potrebbe spingere l’intero settore verso modelli ibridi o alternativi alla più comune generazione sequenziale.

Gemini Diffusion: un nuovo modo di generare testo

I modelli autoregressivi, come GPT-4o o lo stesso Gemini 2.5, scrivono una parola alla volta; predicono il token successivo in base a quelli precedenti; questo processo, per quanto efficace, è lineare e poco flessibile. Gemini Diffusion cambia completamente questo schema: inizia da un caos e, attraverso più passaggi, lo trasforma in un testo logico. Anziché costruire una torre mattoncino per mattoncino, si parte da un blocco e si rimuove l’eccesso come se fosse una scultura.

Questo approccio consente al modello di avere visione d’insieme, migliora la coerenza e permette modifiche nel mezzo del testo; evita le contraddizioni tipiche dei modelli transformer. I vantaggi diventano evidenti in ambiti dove l’accuratezza e la coesione contano: scrittura di testo, calcolo, generazione di codice.

DeepMind ha dimostrato che, pur essendo una demo, Gemini Diffusion ha fornito risposte perfette in test di programmazione avanzati e lo fa in pochi secondi; mantiene una struttura del codice pulita e funzionante.

Benchmark e prestazioni: dove vince Gemini Diffusion e dove c’è da lavorare

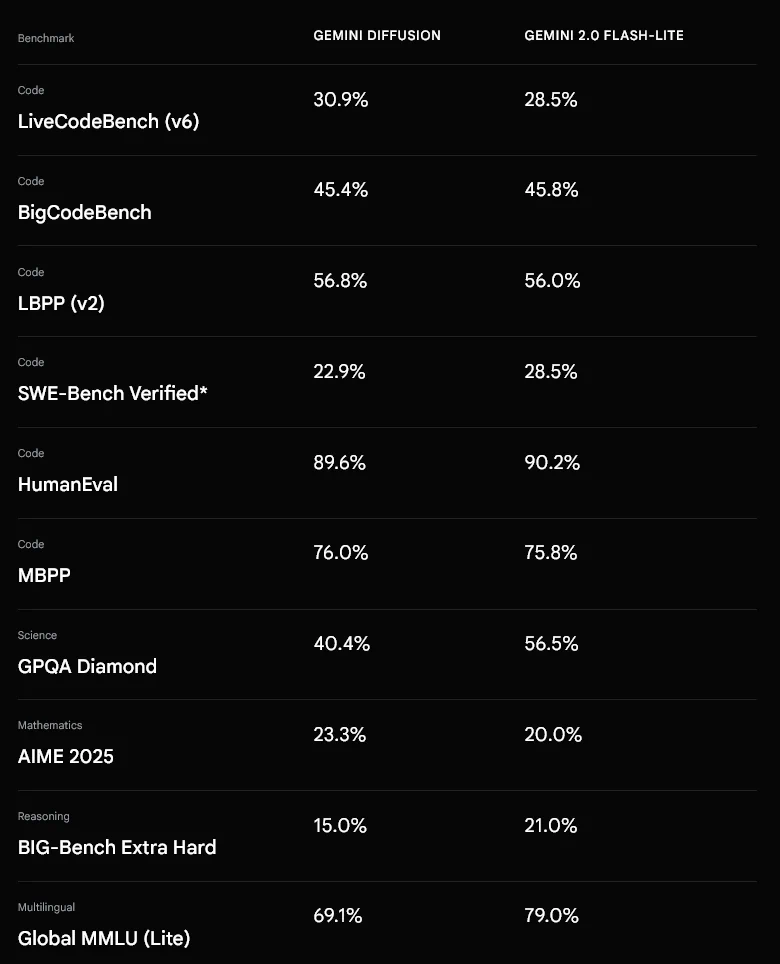

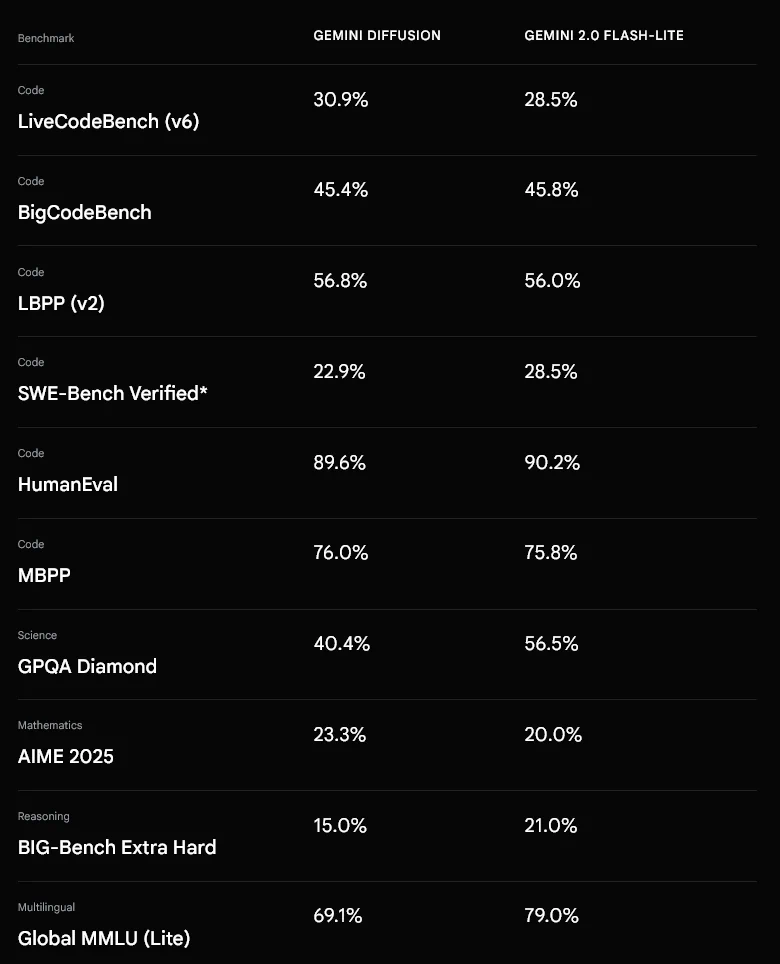

Nonostante la natura ancora sperimentale, i primi benchmark già la dicono lunga. Gemini Diffusion tiene testa a Gemini 2.0 Flash Lite, un modello leggero ma competitivo. Su test di programmazione come HumanEval e MBPP le differenze sono minime; su LiveCodeBench e LBPP, persino lo supera.

Tuttavia, sulle competenze scientifiche e multilingue emerge qualche limite. Nello specifico, in GPQA Diamond e Global MMLU Lite, Gemini Diffusion resta sotto rispetto ai modelli più rodati. La sua forza resta nella velocità: fino a 2000 token/secondo con latenza iniziale inferiore a un secondo, numeri che impressionano chi lavora su applicazioni in tempo reale.

Per chi sviluppa strumenti di coding, è una promessa concreta; per chi lavora su testi lunghi e complessi, invece, resta un work-in-progress. La combinazione tra rapidità, coerenza interna e capacità di generare codice strutturato lo rende già adatto per integrazioni in ambienti professionali.

Implicazioni per l’inferenza locale e il futuro degli LLM

La struttura non autoregressiva apre scenari interessanti anche per la comunità dell’inferenza locale. Il ridotto footprint computazionale fa sperare che in futuro modelli come Gemini Diffusion potranno girare anche su dispositivi meno potenti.

La qualità dipenderà dal numero di passaggi: più iterazioni, maggiore finezza. Questo rende l’approccio adattabile, si può regolare la precisione in base al contesto e modulare il costo computazionale, personalizzando l’output secondo esigenze specifiche.

Inoltre, i modelli diffusion-based permettono nativamente l’editing contestuale: possono modificare parti del testo senza riscrivere tutto, questo è utile per task dinamici, plugin di scrittura o agenti autonomi. Alcuni sviluppatori vedono in questo meccanismo un nuovo paradigma per la generazione interattiva.

Conclusione: un modello ponte

Gemini Diffusion non è un modello AI pensato per sostituire i transformer classici. È una prova che si muove tra le intuizioni dell’immagine generativa e il rigore del linguaggio scritto. La strada della generazione linguistica potrebbe presto dividersi.

Forse non sostituirà i modelli autoregressivi ma ne potrebbe integrare le carenze. Se Google riuscirà a ottimizzarlo, Gemini Diffusion diventerà molto più di una demo: potrebbe essere il nuovo standard su cui costruire gli LLM di domani. L’idea di un modello capace di apprendere e generare con questo approccio potrebbe aprire a una fase completamente nuova della ricerca; una fase in cui efficienza, modularità e reattività saranno presupposti strutturali di ogni nuovo modello.

Se sei interessato alla demo di Gemini Diffusion puoi aggiungerti alla lista di attesa.