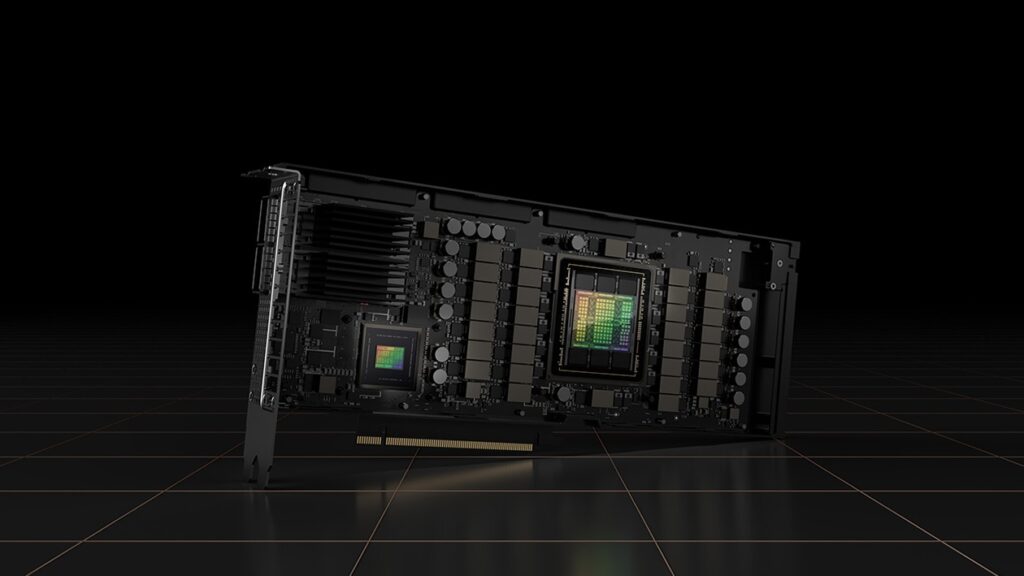

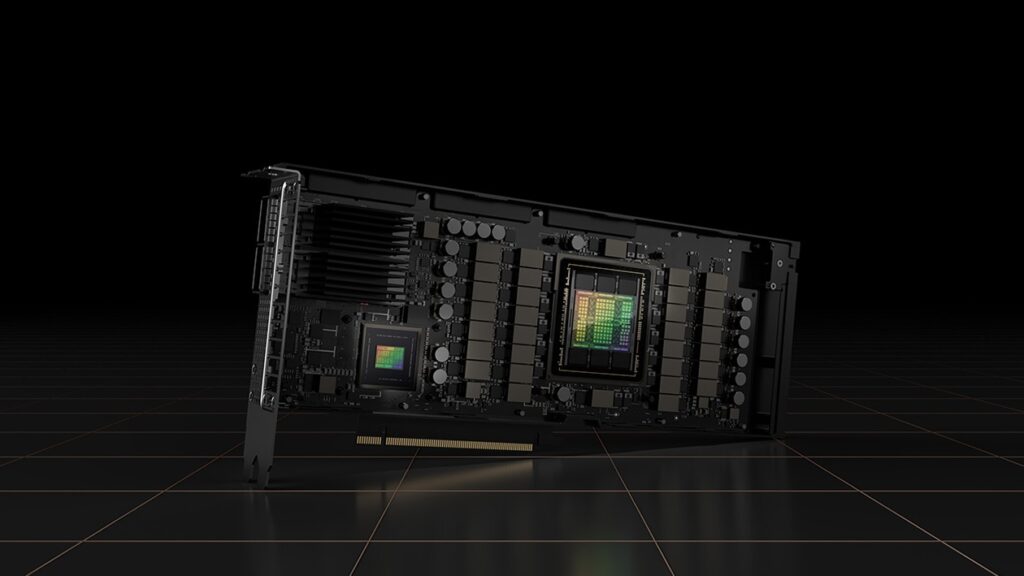

Meta Platforms, la multinazionale che possiede e gestisce una serie di servizi e prodotti popolari, tra cui Facebook, Instagram, WhatsApp e Messenger è considerata una delle “Big Five” aziende tecnologiche americane, insieme a Google, Amazon, Apple e Microsoft. Secondo quanto riportato da Mark Zuckerberg in post su Instagram, Meta Platforms ha pianificato di spendere miliardi di dollari entro la fine del 2024 per la tecnologia IA all’avanguardia di Nvidia, ovvero le GPU Nvidia H100.

350.000 GPU Nvidia H100

Secondo quanto dichiarato, l’azienda ha intenzione di acquistare e mettere in funzione nei suoi datacenter 350.000 GPU Nvidia H100 entro la fine dell’anno; schede che in aggiunta a quelle esistenti e a schede acquistate da altri fornitori come le Instinct MI300 di AMD, raggiungeranno un totale di 600.000 H100, nell’ambito dei suoi sforzi per avanzare nell’IA. Meta con questo acquisto diventa quindi uno dei maggiori acquirenti mondiale delle GPU H100 di Nvidia, oltre ad aver acquistato anche molti processori IA, tra cui l’Instinct MI300 di AMD.

Meta Platforms

Mark Zuckerberg è il CEO di Meta Platforms. Zuckerberg ha fondato l’azienda Meta nel 2004, poi rinominata in Meta Platforms nel 2021. Da allora ha ricoperto il ruolo di CEO, responsabile della definizione della direzione generale e della strategia del prodotto dell’azienda. Guida la progettazione dei servizi di Meta e lo sviluppo della sua tecnologia e infrastruttura di base.

Questo acquisto da parte di Meta Platforms dimostra ancora una volta l’enorme domanda che esiste per le costose schede IA di Nvidia. Il costo totale per Meta potrebbe essere di circa 18 miliardi di dollari, basandosi su stime dell’industria che valutano ogni GPU Nvidia H100 tra i 30.000 e i 40.000 dollari. Secondo Mark Zuckerberg questo ulteriore investimento nell’IA permetterà di costruire un’enorme infrastruttura IA per supportare le sue ricerche nell’intelligenza artificiale generativa.

Con questo approvvigionamento di GPU, Meta Platforms potrebbe diventare l’azienda con la potenza elaborativa IA più elevata al mondo, sorpassando giganti come Microsoft/OpenAI, Google ed Amazon. Ma probabilmente gli altri non resteranno a guardare.

Nel frattempo bisognerà vedere se Nvidia in primo luogo ma anche AMD, sapranno soddisfare questa enorme richiesta di GPU IA.

Progetti futuri con le GPU Nvidia H100

L’azienda sta costruendo tutto questo per supportare strumenti di intelligenza artificiale che siano “disponibili e utili a tutti nella nostra vita quotidiana“, ha aggiunto Mark Zuckerberg. Ha anche affermato che tutta questa potenza elaborativa sarà impiegata per migliorare il modello LLM (large language model) di Meta conosciuto come Llama, che al momento non è sicuramente tra i migliori.

Per fare dei paragoni e per capire quanto sia imponente questa fornitura, Elon Musk per addestrare il modello Grok sembra che abbia utlizzato 10.000 GPU. Mentre per il training del modello di CharGPT sembra che OpenAI abbia utilizzato per qualche giorno “solo” 30.000 Nvidia A100 GPU, un modello inferiore delle H100.

Nel suo messaggio Zuckerberg fa notare che anche i suoi progetti del metaverso su cui nel 2022 investì circa 13 miliardi di dollari con la divisione Reality Labs, sono ancora in corso ed ha annunciato la progettazione di occhiali AR (realtà aumentata) con IA integrata, ed ha affermato che le persone in futuro “parleranno frequentemente con le IA durante il giorno“.

Probabilmente dietro l’investimento di 18 miliardi di dollari più tutti i costi che saranno necessari per le infrastrutture e la gestione di 600.000 GPU IA, c’è molto di più dello sviluppo di un modello LLM open source e di un paio di occhiali AR. Con il tempo lo sapremo.

Conclusione

Questi investimenti massicci in hardware IA riflettono l’importanza crescente dell’intelligenza artificiale per le aziende tecnologiche. Con l’acquisto di un numero così elevato di GPU, Meta sta costruendo una capacità di calcolo che potrebbe essere più grande di qualsiasi altra azienda.

Questo potrebbe posizionare Meta come leader nel campo dell’intelligenza artificiale, con la capacità di sviluppare e implementare modelli AI su larga scala.