Z.AI, la startup cinese conosciuta anche come Zhipu, ha rilasciato GLM-5, il suo nuovo modello flagship della serie GLM, una delle famiglie open source più seguite nel panorama dell’intelligenza artificiale insieme a DeepSeek, Kimi e Qwen3-Max. Rispetto ai predecessori della linea GLM-4.x (tutti basati su architettura da 355B/32B parametri attivi), GLM-5 porta la scala a 744 miliardi di parametri totali, con 40 miliardi attivi per token in un’architettura Mixture-of-Experts. Il modello viene distribuito con licenza MIT, il che lo rende immediatamente utilizzabile anche in contesti enterprise senza vincoli proprietari.

GLM-5 non è pensato per essere un semplice assistente conversazionale, ma un motore per l’Agentic Engineering, la capacità di completare autonomamente task complessi di sviluppo software, analisi dati, pianificazione a lungo raggio e produzione documentale. Si allinea quindi alla filosofia già iniziata da OpenAI e Anthropic con i modelli GPT-5.3 Codex e Claude Opus 4.6.

Si rivolge in primis a sviluppatori, team tecnici e aziende che cercano un’alternativa open weight ai modelli proprietari di fascia alta, con prestazioni competitive e un costo operativo sensibilmente inferiore.

Rilasciato sotto licenza MIT, il modello si posiziona direttamente in competizione con i giganti proprietari occidentali: offre un’alternativa strategica per le imprese che cercano di evitare il vendor lock-in. GLM-5 ha raggiunto il punteggio record più basso di allucinazioni AI mai registrato, ponendosi come lo strumento ideale per sviluppatori e professionisti che necessitano di un’intelligenza artificiale capace di operare con autonomia e precisione.

Un’architettura nuova costruita per agire, non solo rispondere

Il cambiamento più sostanziale sotto il cofano di GLM-5 non riguarda solo la scala dei parametri, ma il modo in cui il modello è stato addestrato e ottimizzato per risolvere compiti realmente autonomi.

L’architettura alla base di GLM-5 introduce innovazioni pensate per ottimizzare sia l’addestramento che l’inferenza su larga scala. Il modello adotta una struttura Mixture of Experts (MoE) scalata, ma la vera novità risiede nell’integrazione di due tecnologie chiave: il framework Slime e la DeepSeek Sparse Attention (DSA).

Slime è una nuova infrastruttura di apprendimento per rinforzo (RL) asincrono progettata per superare i colli di bottiglia tipici dei lunghi processi di training, permettendo al modello di apprendere da interazioni complesse senza rallentamenti. Questo sistema utilizza gli Active Partial Rollouts (APRIL) per affrontare i blocchi nella generazione, accelerando notevolmente il ciclo di iterazione per compiti agentivi complessi.

Parallelamente, l’integrazione della DSA consente di gestire una finestra di contesto di 200K token mantenendo i costi di distribuzione gestibili, sebbene l’impronta hardware rimanga considerevole.

Benchmark GLM-5: un salto netto verso la frontiera open source

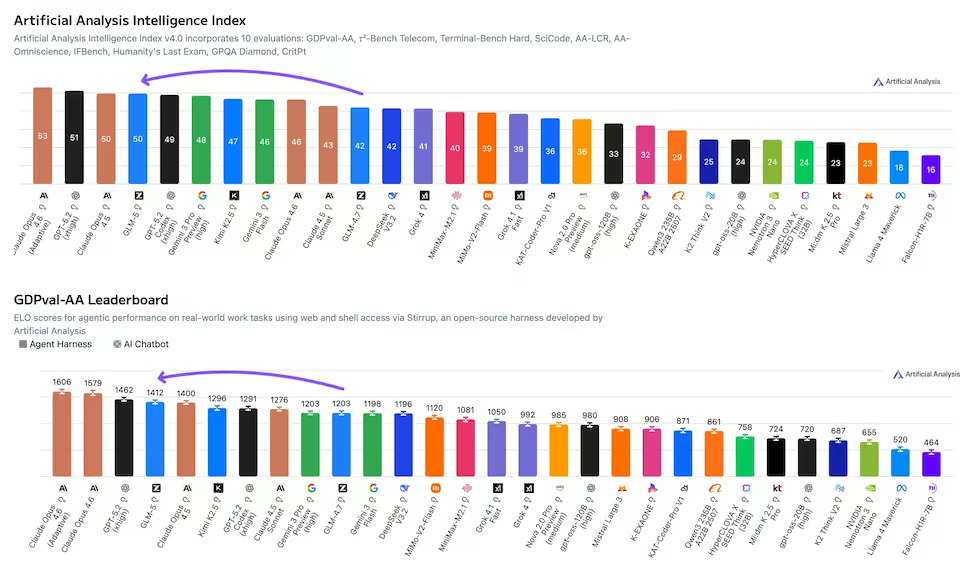

Sul fronte delle prestazioni misurabili, GLM-5 si posiziona come il modello open weight più performante secondo l’Artificial Analysis Intelligence Index v4.0, raggiungendo un punteggio di 50, primo modello open source a superare questa soglia, contro il 42 di GLM-4.7.

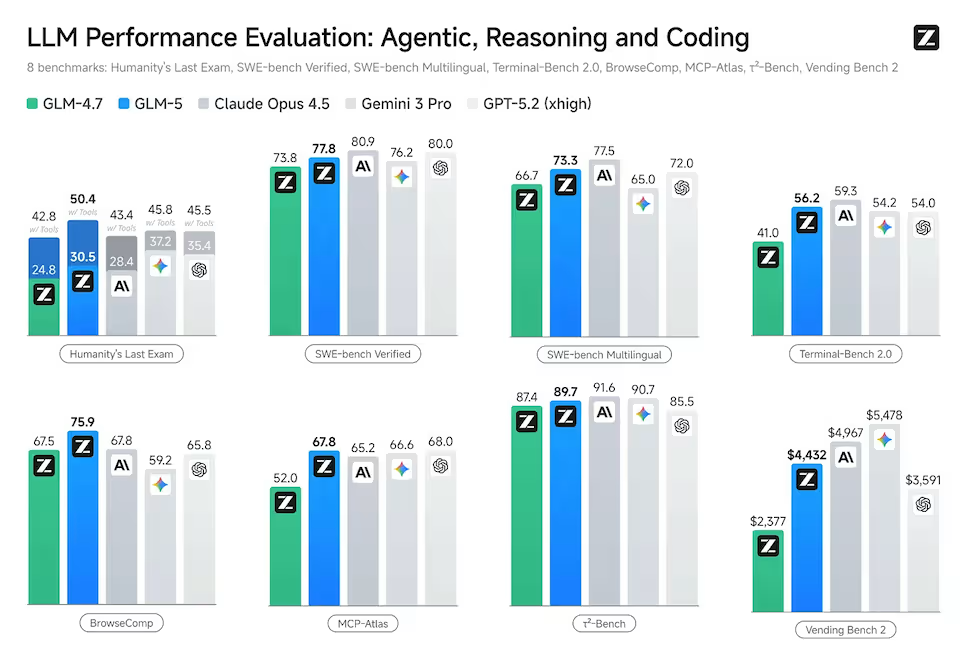

Il miglioramento più vistoso riguarda la riduzione delle allucinazioni. GLM-5 ottiene un progresso di 35 punti rispetto al predecessore sull’AA-Omniscience Index, ottenuto aumentando la frequenza con cui il modello sceglie di astenersi invece di rispondere in modo errato. Questo lo colloca al primo posto nell’intera industria su questo parametro, davanti a Google, OpenAI e Anthropic.

Nello specifico del coding e dei compiti agentivi, i benchmark sono notevoli. Su SWE-bench Verified ha segnato 77,8, superando Gemini 3 Pro e avvicinandosi a Claude Opus 4.6. Particolarmente degno di nota è il GDPval-AA ELO di 1412, terzo in classifica assoluta, che dimostra la sua superiorità nei compiti lavorativi economicamente validi, dalla preparazione di presentazioni all’editing video.

La sua capacità di scomporre obiettivi complessi in sotto-compiti eseguibili, come la generazione di documenti formattati o l’analisi di dataset, colloca GLM-5 in una fascia di prestazioni elite, colmando il divario tra i modelli proprietari americani e l’open source.

Disponibilità del modello GLM-5

Il modello GLM-5 è disponibile tramite l’API di Z.AI con il nome modello glm-5, oltre che su diversi provider terzi come DeepInfra e OpenRouter. Il modello viene distribuito in precisione FP8 tramite provider esterni come Huggingface, mentre i pesi ufficiali sono in BF16, richiedendo circa 1.490 GB di VRAM per un deployment self-hosted. Un requisito hardware importante, che di fatto limita l’opzione on-premise alle organizzazioni con infrastrutture GPU significative.

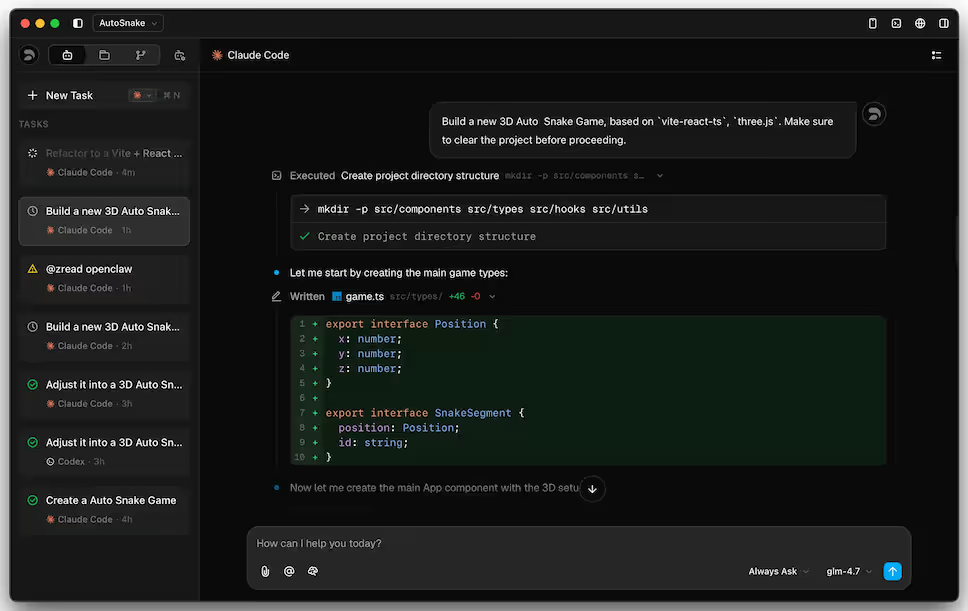

GLM-5 è disponibile anche sulla piattaforma di sviluppo api.z.ai , con compatibilità con Claude Code e OpenClaw. Anche la chat conversazionale aperta e gratuita per tutti è già disponibile su chat.z.ai.

Se invece vuoi provare le sue capacità di coding senza spendere nulla, Kilo Code lo offre gratuitamente per un periodo limitato, sia nella sua CLI versione 1.0 che nell’estensione VS Code (con oltre 700.000 download sul Marketplace). Puoi selezionarlo semplicemente scegliendo la voce Z.AI: GLM 5 (free) dal selettore dei modelli.

Z.ai ha creato anche una GUI per lo sviluppo coding, Z Code, disponibile per Windows e Mac. Z Code è un ambiente di sviluppo agentico (ADE) all-in-one progettato per codificare con gli agenti di intelligenza artificiale: oltre alle API GML supporta anche i piani di abbonamento nativi Claude Code, OpenAI Codex, Gemini e tutta la piattaforma OpenRouter.

Prezzi competitivi e accesso immediato

La strategia di prezzo di Z.ai è aggressiva e punta a democratizzare l’accesso a modelli di altissimo livello, offrendo un rapporto qualità-prezzo quasi imbattibile con un costo di 0,80 dollari per milione di token in input e 2,56 dollari per milione di token in output.

| Modello | Input (per 1M token) | Output (per 1M token) |

|---|---|---|

| DeepSeek-V3.2 | $0.07 | $0.42 |

| Grok 4.1 Fast (xAI) | $0.20 | $0.50 |

| Kimi K2.5 | $0.60 | $3.00 |

| GLM-5 | $0.80 | $2.56 |

| Qwen3-Max | $1.20 | $6.00 |

| GPT-5.1 | $1.25 | $10.00 |

| GPT-5.2 | $1.75 | $14.00 |

| Gemini 3 Pro (Google) | $2.00 | $12.00 |

| Claude Sonnet 4.5 (Anthropic) | $3.00 | $15.00 |

| Grok 4 (xAI) | $3.00 | $15.00 |

| Claude Opus 4.6 (Anthropic) | $5.00 | $25.00 |

| GPT-5 Pro | $15.00 | $120.00 |

| GPT-5.2 Pro | $21.00 | $168.00 |

Il rapporto prestazioni/costo è ciò che distingue GLM-5, offre prestazioni paragonabili a modelli che costano da 4 a 7 volte di più.

GLM-5: ne vale la pena? A chi conviene adottarlo

Il modello cinese GLM-5 merita attenzione e dimostra ancora una volta che è possibile competere ad armi pari con i colossi proprietari americani.

La licenza MIT lo rende adatto anche a deployment enterprise senza limitazioni d’uso, e la disponibilità su più provider garantisce flessibilità operativa reale. Chi lavora in contesti dove l’accuratezza delle informazioni è critica troverà particolarmente utile il miglioramento sull’AA-Omniscience Index: un modello che sa quando non rispondere è spesso più affidabile di un modello che risponde sempre a volte sbagliando.

Sebbene i requisiti hardware per l’hosting locale siano impegnativi a causa della mole di parametri, l’accessibilità via API e le licenze permissive come la MIT lo rendono una risorsa fondamentale per chi vuole evitare il lock-in dei fornitori. Per chi cerca un assistente che non si limiti a suggerire ma che esegua materialmente i compiti assegnati, GLM-5 si configura oggi come una delle opzioni più convincenti e accessibili sul mercato globale.

Per startup, sviluppatori indipendenti e medie imprese tech che vogliono capacità frontier senza il budget dei grandi operatori, GLM-5 è oggi una delle scelte più razionali sul mercato.