MiniMax, startup di intelligenza artificiale con sede a Shanghai, ha lanciato il 12 febbraio il suo nuovo modello di punta, MiniMax M2.5, posizionandolo come alternativa competitiva ai modelli flagship di Anthropic e OpenAI.

Non si tratta di un salto generazionale qualunque. M2.5 arriva appena 108 giorni dopo MiniMax M2, con il punteggio SWE-Bench Verified passato da 69,4% a 80,2%, un incremento che le serie Claude e GPT hanno raggiunto dopo molti mesi.

Il modello è stato progettato come un agente nativo, cioè non solo per rispondere a domande ma per eseguire compiti complessi in autonomia, tra cui sviluppo full-stack, ricerca professionale, gestione di file Office e analisi finanziaria. Già nella sua prima giornata di disponibilità pubblica, sono stati costruiti oltre 10.000 agenti specializzati sulla piattaforma MiniMax Agent. Se sei uno sviluppatore, un team tecnico o un’azienda che sta valutando soluzioni AI per workflow produttivi, dovresti considerare MiniMax M2.5 non solo per le prestazioni, ma soprattutto per un rapporto qualità/prezzo che cambia concretamente i conti in tasca.

Architettura Mixture of Experts e il framework Forge

La caratteristica tecnica più rilevante di MiniMax M2.5 è la sua architettura Mixture of Experts (MoE). Il modello ha 230 miliardi di parametri totali, ma durante l’inferenza ne attiva soltanto 10 miliardi. Questo meccanismo permette di mantenere la profondità ragionativa di un modello molto grande, riducendo al minimo il costo computazionale per ogni token generato. È una pratica ormai molto diffusa, ma in questo caso il risultato è una velocità nativa di 100 token al secondo, circa il doppio rispetto ai principali modelli frontier concorrenti.

Per addestrare questo sistema in modo stabile su larga scala, MiniMax ha sviluppato internamente un framework di Reinforcement Learning chiamato Forge. Esso introduce uno strato intermedio tra il motore di training e l’agente, consentendo di ottimizzare il comportamento del modello su qualsiasi scaffolding senza dover modificare l’infrastruttura sottostante. Lo scaffolding indica il sistema di supporto esterno che circonda un modello AI durante l’esecuzione di un compito. In pratica è l’insieme di strumenti, script e istruzioni che:

- dicono al modello come usare gli strumenti disponibili (terminale, browser, API, file system).

- gestiscono il loop agentivo, cioè il ciclo “ragiona → agisci → osserva il risultato → ragiona di nuovo”.

- forniscono il contesto dell’ambiente in cui il modello opera.

Per esempio, quando Claude Code risolve un bug su GitHub, lo scaffolding è tutto il codice che permette a Claude di leggere il repository, eseguire test, scrivere file e interpretare gli output. Claude da solo non farebbe nulla senza quell’infrastruttura intorno.

Nel contesto specifico di MiniMax M2.5, il concetto è importante perché permette al modello di funzionare bene sia su OpenHands, sia su Claude Code di Anthropic, sia sull’app Codex di OpenAI sia su sistemi custom, senza degradare le prestazioni al cambio di ambiente, un problema comune ai modelli addestrati su un solo tipo di harness.

Durante l’addestramento, il modello ha sviluppato la capacità di pianificare l’architettura di un progetto prima di scrivere codice, un comportamento che MiniMax chiama “Architect Mindset”.

Benchmark e prestazioni: dove eccelle MiniMax M2.5

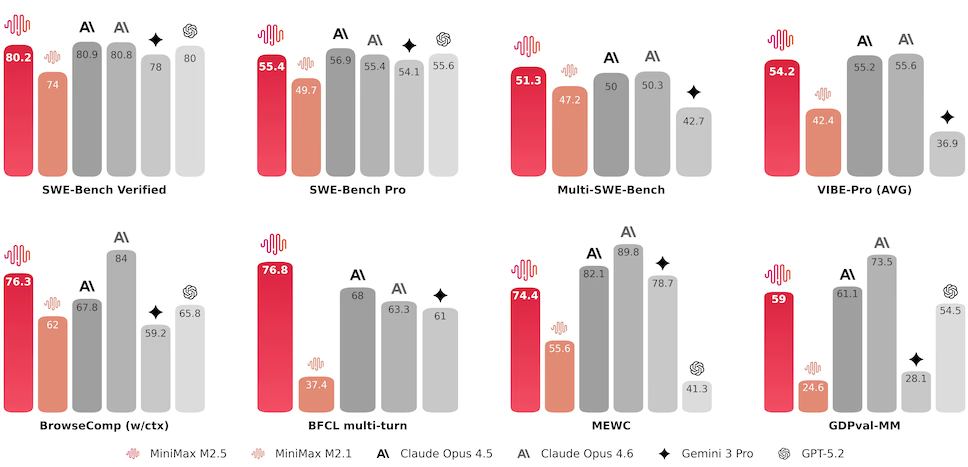

Sul benchmark SWE-Bench Verified, MiniMax M2.5 ottiene 80,2%, un risultato allineato a Claude Opus 4.6 (80,8%). Su Multi-SWE-Bench, che valuta la scrittura di codice in più linguaggi in contemporanea, M2.5 raggiunge 51,3%, collocandosi in prima posizione tra i modelli testati.

Nella classifica dell’OpenHands Index, un benchmark composito che copre issue resolution, greenfield development, frontend, testing e information gathering, M2.5 si posiziona quarto assoluto, dietro solo a Claude Opus 4.6, GPT-5.2 Codex e Claude Opus 4.5.

Il dato più interessante non è però il punteggio, ma il costo per raggiungerlo. Il costo medio per task di MiniMax M2.5 è di soli $0,11, contro $1,44 di Claude Opus 4.6 e $1,75 di GPT-5.2-Codex. È anche il primo modello open ad aver superato Claude Sonnet sulla piattaforma OpenHands.

Sul fronte velocità operativa, il modello completa la valutazione SWE-Bench Verified in 22,8 minuti in media (era 31,3 minuti con M2.1), un tempo paragonabile ai 22,9 minuti di Claude Opus 4.6, consumando però solo il 10% del costo per attività.

Internamente MiniMax ha affermato che M2.5 gestisce autonomamente il 30% di tutte le attività aziendali e genera l’80% del codice commissionato nei nuovi commit.

Disponibilità del modello M2.5

Il modello M2.5 è disponibile tramite l’API di MiniMax, oltre che su diversi provider come OpenRouter. M2.5 è disponibile anche sulla piattaforma di sviluppo platform.minimax.io mentre la chat conversazionale aperta e gratuita per tutti è disponibile su agent.minimax.io.

Se invece vuoi provare le sue capacità di coding senza spendere nulla, Kilo Code offre gratuitamente il modello M2.5 per un periodo limitato, sia nella sua CLI versione 1.0 che nell’estensione VS Code (con oltre 700.000 download sul Marketplace).

Anche Cline offre gratuitamente il modello M2.5 per un periodo limitato. È disponibile in Cline per VS Code, JetBrains, Zed, Neovim, Emacs e la CLI di Cline. L’ultima versione di Cline Subagents consente di eseguire più agenti in parallelo su diverse parti di un’attività. M2.5 è stato addestrato esattamente per questo tipo di configurazione. Perché non approfittarne?

Prezzi di MiniMax M2.5

MiniMax offre il modello in due versioni API, pensate per scenari d’uso diversi. M2.5-Lightning è ottimizzata per la velocità, con una throughput di 100 token al secondo. Il costo è di $0,30 per milione di token in input e $2,40 per milione di token in output. M2.5 Standard gira invece a 50 token al secondo e costa esattamente la metà, ovvero $0,15 input e $1,20 output per milione di token. Entrambe le versioni supportano il caching.

Il confronto con i concorrenti è netto. A parità di compito, il costo medio di M2.5 è stimato intorno a $0,15 per task, contro i $3,00 di Claude Opus 4.6, un rapporto di circa 1:20.

| Modello | Input (per 1M token) | Output (per 1M token) |

|---|---|---|

| DeepSeek-V3.2 | $0.07 | $0.42 |

| Grok 4.1 Fast (xAI) | $0.20 | $0.50 |

| MiniMax M2.5 | $0.15 | $1.20 |

| MiniMax M2.5-Lightning | $0.30 | $2.40 |

| Kimi K2.5 | $0.60 | $3.00 |

| GLM-5 | $0.80 | $2.56 |

| Qwen3-Max | $1.20 | $6.00 |

| GPT-5.1 | $1.25 | $10.00 |

| GPT-5.2 | $1.75 | $14.00 |

| Gemini 3 Pro (Google) | $2.00 | $12.00 |

| Claude Sonnet 4.5 (Anthropic) | $3.00 | $15.00 |

| Grok 4 (xAI) | $3.00 | $15.00 |

| Claude Opus 4.6 (Anthropic) | $5.00 | $25.00 |

| GPT-5 Pro | $15.00 | $120.00 |

| GPT-5.2 Pro | $21.00 | $168.00 |

Quando conviene scegliere M2.5

MiniMax M2.5 non è il modello più potente in assoluto: Claude Opus 4.6 e GPT-5.2 Codex mantengono un vantaggio misurabile su alcuni benchmark di ragionamento avanzato, e chi ha bisogno del massimo assoluto su task critici lo sa già.

Detto questo, M2.5 è il primo modello open ad avvicinarsi davvero alla qualità dei flagship proprietari su task agentici complessi, farlo a un costo radicalmente inferiore e farlo con una velocità di inferenza che rende praticabili pipeline in tempo reale.

È la scelta giusta se stai costruendo agenti che devono girare in continuo, gestire codice multi-linguaggio o produrre documenti Office strutturati. In questi scenari, M2.5 è oggi l’opzione economicamente più solida al di fuori dei top di gamma. Il profilo ideale è quello di team tecnici e aziende che fino a ieri non potevano permettersi di far girare modelli frontier per task di volume.