Moonshot AI ha rilasciato Kimi K2.5 il 27 gennaio 2026, presentando quello che definisce il primo modello open source nativo multimodale con capacità agentiche avanzate. Si tratta di un sistema da 1 trilione di parametri totali, di cui 32 miliardi attivi per token, addestrato su circa 15 trilioni di token che combinano testo, immagini e video. L’architettura Mixture-of-Experts (MoE) permette di mantenere prestazioni elevate con un’efficienza computazionale paragonabile a modelli molto più piccoli, rendendo possibile l’utilizzo in locale su hardware consumer di fascia alta. Per elaborazioni in locale con prestazioni accettabili (oltre 5 token/secondo), serve una configurazione con circa 247 GB di memoria RAM.

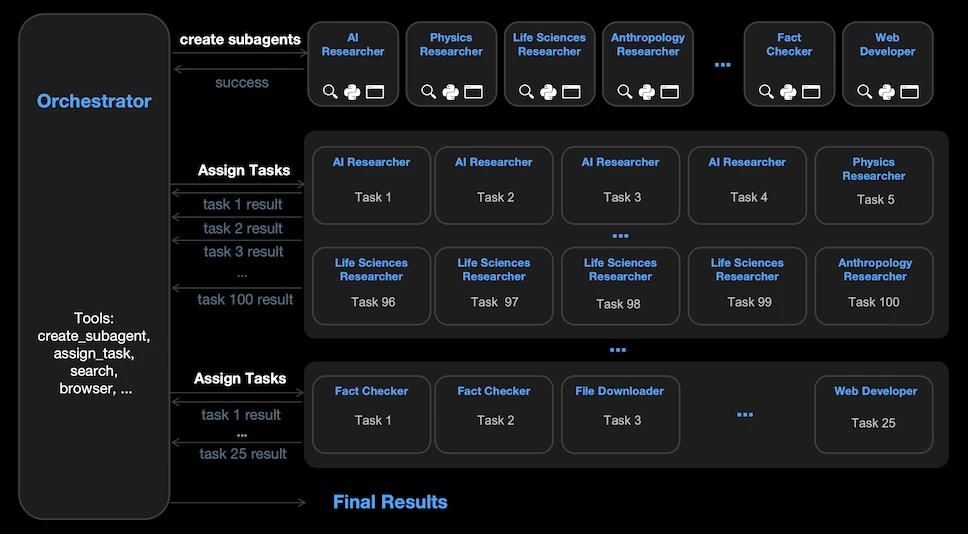

La caratteristica distintiva è il paradigma “agent swarm” auto-diretto, capace di coordinare fino a 100 sotto-agenti in parallelo attraverso 1.500 chiamate di strumenti simultanee. Questo approccio riduce i tempi di esecuzione fino a 4.5 volte rispetto ai sistemi tradizionali a singolo agente. Nei test interni, la rete di agenti ha tagliato l’80% del tempo end-to-end su compiti complessi.

L’azienda di Pechino, sostenuta da Alibaba e HongShan (ex Sequoia China), ha raccolto 1 miliardo di dollari in un round Series B con valutazione di 2.5 miliardi, raggiungendo poi 4.3 miliardi secondo Bloomberg, e punta ora a 5 miliardi.

Kimi K2.5: MoE multimodale con visione integrata

L’infrastruttura di Kimi K2.5 si basa su 61 layer che impiegano il meccanismo Multi-head Latent Attention (MLA) per ottimizzare l’efficienza della memoria. La finestra di contesto raggiunge 256.000 token, sufficiente per processare codebase complete in un’unica passata ma non ai livelli di Gemini Pro 3 che raggiunge 1 milione di token.

A differenza dei concorrenti che aggiungono le capacità visive con moduli esterni, questo sistema integra un encoder proprietario MoonViT da 400 milioni di parametri che elabora nativamente immagini e video.

Il modello completo non quantizzato richiede circa 630 GB di spazio disco, ma l’ottimizzazione attraverso quantizzazione a 1.8 bit riduce questo valore a 230 GB, un taglio dell’80% che rende fattibile il deployment locale su hardware consumer avanzato mantenendo performance robuste.

Visual coding e orchestrazione multi-agente

Il sistema eccelle nel “coding with vision”, trasformando screenshot, registrazioni video o schizzi disegnati a mano in codice front-end funzionante. Nelle dimostrazioni pubbliche, ha ricostruito l’aspetto e il flusso di siti esistenti da brevi video, estraendo effetti di scorrimento, animazioni e componenti cliccabili, generando HTML, CSS e JavaScript pronti all’uso. Chi carica un mockup di dashboard può ottenere codice React completo con dati placeholder e design responsive in pochi minuti, abbattendo le barriere tradizionali tra progettazione e implementazione.

L’innovazione più significativa è il Parallel-Agent Reinforcement Learning (PARL), framework che addestra il modello a decomporre task complessi in sottotask parallelizzabili. L’orchestratore trainabile genera sotto-agenti statici che gestiscono ciascun pezzo simultaneamente. Le performance vengono misurate usando “critical steps”, metrica orientata alla latenza ispirata al critical path del calcolo parallelo, che traccia il percorso di esecuzione più lento anziché contare i passi totali.

Sul benchmark WideSearch, la modalità con orchestrazione multi-agente ha migliorato l’accuratezza dal 72.7% al 79.0%. Su BrowseComp, la rete coordinata PARL ha raggiunto 78.4% contro il 60.6% della modalità standard.

Kimi K2.5: competizione diretta con GPT-5.2 e Claude Opus 4.5

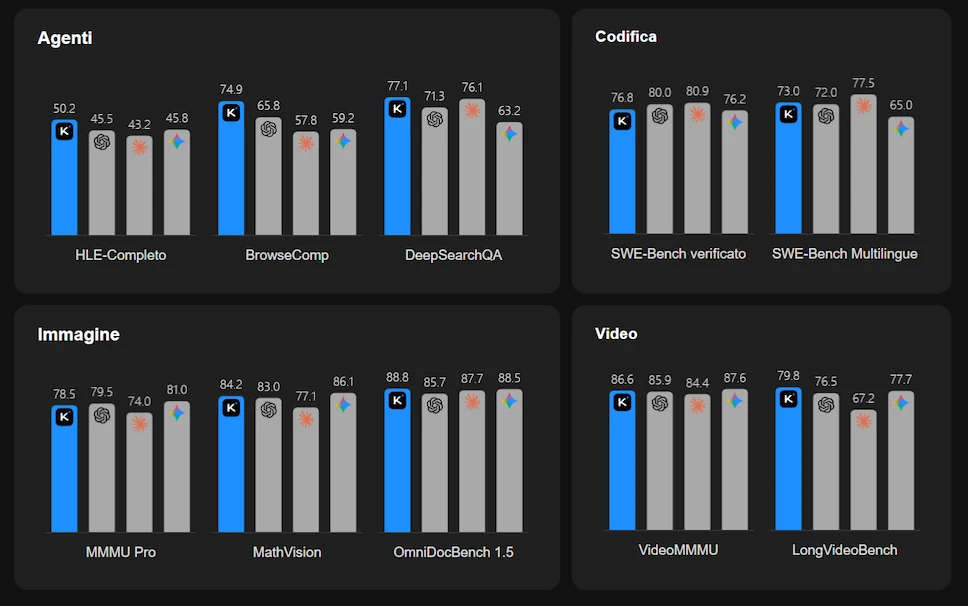

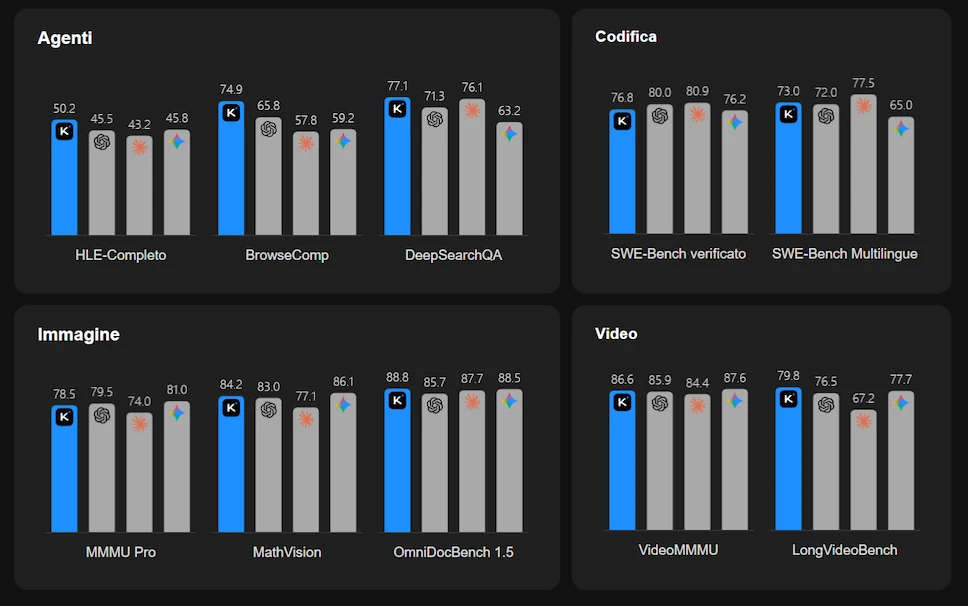

I risultati pubblicati posizionano Kimi K2.5 tra i sistemi più performanti disponibili. Su Humanity’s Last Exam (HLE-Full) con strumenti, ha ottenuto 50.2%, superando GPT-5.2 high al 45.5% e Claude Opus 4.5 Extended Thinking al 43.2%.

Nel coding, Kimi K2.5 dimostra prestazioni competitive su benchmark industriali riconosciuti.

Su SWE-Bench Verified, considerato il test più rigoroso per capacità di sviluppo software reale, ha raggiunto 76.8%, posizionandosi vicino a GPT-5.2 (80.0%) e Claude Opus 4.5 (80.9%) nonostante la natura open source. Su SWE-Bench standard ha ottenuto 73.0%, mentre su SWE-Bench Pro ha conseguito 50.7%, superando le performance di DeepSeek V3.2 (70.2% su SWE-Bench standard). Particolarmente interessante il risultato su LiveCodeBench v6 con 85.0%, benchmark che testa la capacità di generare codice funzionante su problemi reali recenti. Su Terminal Bench 2.0, che valuta l’abilità di utilizzare strumenti da riga di comando, ha raggiunto 50.8%, mentre su SciCode, focalizzato su programmazione scientifica complessa, ha totalizzato 48.7%.

Per il ragionamento visivo, su VideoMMMU ha segnato 86.6%, battendo GPT-5.2 (85.9%) e Claude Opus 4.5 (84.4%). Su MMMU-Pro ha ottenuto 78.5%, e su CharXiv (RQ) ha raggiunto 77.5%. Nei test matematici visivi come MathVision ha totalizzato 84.2%, mentre su MathVista mini ha dominato con 90.1% contro l’82.8% di GPT-5.2. Su OCRBench ha conseguito 92.3%, distanziando di oltre 10 punti i concorrenti principali, dimostrando capacità superiori nell’estrazione di testo da immagini complesse.

Nei benchmark di long context come Longbench v2, ha ottenuto 61.0%, posizionandosi dietro a Gemini 3 Pro (68.2%) ma davanti a GPT-5.2 (54.5%). Su DeepSearchQA, dedicato alla ricerca agentica approfondita, ha raggiunto 77.1%, superando tutti i competitor closed-source.

Prezzi, accessibilità e confronto con i concorrenti globali

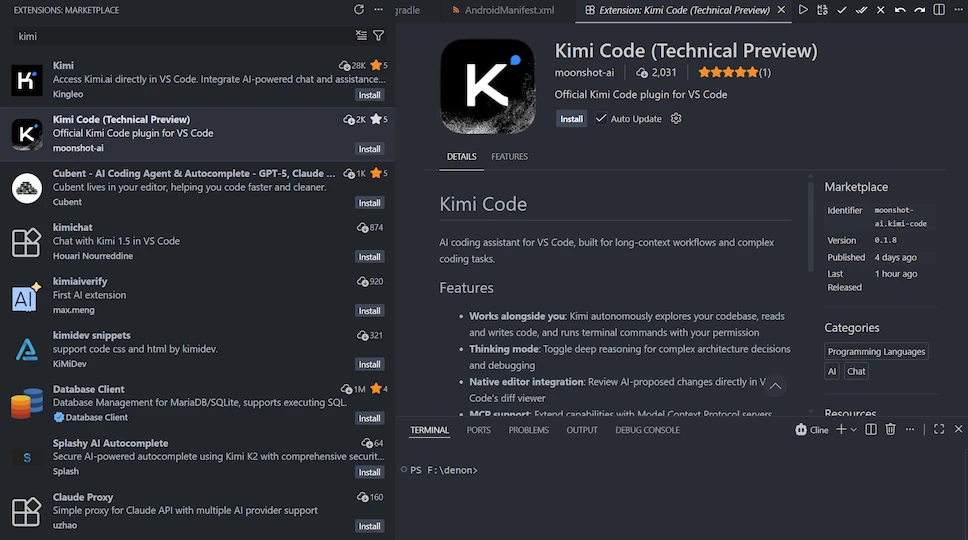

Un aspetto particolarmente interessante di Kimi K2.5 riguarda la strategia di prezzo aggressiva adottata da Moonshot AI, ma questa ormai non è una novità per i modelli cinesi. Il modello risulta accessibile attraverso diversi canali, rendendo possibile sia l’utilizzo consumer che enterprise con costi contenuti. La chat conversazionale è disponibile a questo link. Attraverso provider API come Fireworks AI o Openrouter, i prezzi partono da 0.60 dollari per milione di token input non cached, 3.00 dollari per milione di token output e 0.30 dollari per milione di token input cached; posizionamento che lo rende estremamente competitivo rispetto ai modelli concorrenti occidentali. Per gli sviluppatori è stato lanciato Kimi Code, assistente open source che si integra con VSCode, Cursor e Zed.

I pesi completi del modello sono disponibili su Hugging Face sotto licenza Modified MIT, permettendo deployment locale per chi dispone di hardware adeguato.

Confrontando i prezzi API nel panorama globale, Kimi K2.5 si posiziona in modo competitivo. Kimi K2.5 (0.60 / 3.00 dollari) batte nettamente GPT-5.2 (1.75 / 14.00 dollari), Gemini 3 Pro (2.00 / 12.00 dollari), Claude Sonnet 4.5 (3.00 / 15.00 dollari) e Grok 4 (3.00 / 15.00 dollari). I modelli premium come Claude Opus 4.5 (5.00 / 25.00 dollari), GPT-5 Pro (15.00 / 120.00 dollari) e GPT-5.2 Pro (21.00 / 168.00 dollari) risultano significativamente più costosi per capacità comparabili.

| Modello | Prezzo Input (per 1M token) | Prezzo Output (per 1M token) |

|---|---|---|

| Kimi K2.5 | $0.60 | $3.00 |

| DeepSeek-V3.2 | $0.07 | $0.42 |

| Grok 4.1 Fast (xAI) | $0.20 | $0.50 |

| GPT-5.1 | $1.25 | $10.00 |

| GPT-5.2 | $1.75 | $14.00 |

| Gemini 3 Pro (Google) | $2.00 | $12.00 |

| Claude Sonnet 4.5 (Anthropic) | $3.00 | $15.00 |

| Grok 4 (xAI) | $3.00 | $15.00 |

| Claude Opus 4.5 (Anthropic) | $5.00 | $25.00 |

| GPT-5 Pro | $15.00 | $120.00 |

| GPT-5.2 Pro | $21.00 | $168.00 |

Kimi K2.5: open source cinese alla frontiera dell’IA multimodale agentica

Kimi K2.5 prova ancora una volta che l’intelligenza artificiale open source cinese può competere frontalmente con i giganti proprietari. Combinando un’architettura MoE da trilione di parametri con multimodalità nativa e capacità di orchestrazione multi-agente, Moonshot AI ha consegnato uno strumento versatile che democratizza l’accesso a ragionamento avanzato e processamento visivo, riducendo barriere tradizionalmente associate ai modelli di frontiera. L’approccio con rete coordinata di agenti trasforma il modello da assistente singolo a coordinatore di team specializzati, con impatti misurabili sulla velocità di esecuzione.

Le organizzazioni che cercano di integrare ragionamento profondo nei propri workflow dovrebbero valutare immediatamente questo sistema, sia attraverso API a basso costo sia mediante deployment locale. I trade-off di latenza vengono bilanciati dalla profondità di ragionamento e dalla capacità di automatizzare autonomamente task complessi multi-step. Il visual coding abbatte il gap tra design e implementazione, mentre le capacità documentali lo rendono competitivo per automazione office e analisi di grandi volumi testuali.

Il contesto competitivo vede laboratori cinesi come Moonshot, DeepSeek e Zhipu AI spingere aggressivamente sulla frontiera, con rilasci rapidi di modelli potenti e accessibili. La velocità di iterazione e l’apertura del codice stanno spostando il baricentro dell’innovazione AI, costringendo i player occidentali a riconsiderare strategie di pricing e deployment.

Il rapporto qualità-prezzo di Kimi K2.5 lo posiziona come alternativa valida per sviluppatori e aziende che vogliono sperimentare capacità multimodali avanzate senza vincoli di vendor lock-in. Per chi lavora su progetti che richiedono elaborazione visiva, generazione di codice e coordinamento di workflow complessi, questo modello offre un’opzione open source performante che rivaleggia con le soluzioni proprietarie più costose. La corsa verso l’AGI passa sempre più da Pechino, e Kimi K2.5 ne è l’ennesima dimostrazione tangibile.