Mentre le grandi aziende americane si contendono la scena con conferenze stampa e promesse roboanti, DeepSeek come suo solito, ha deciso di giocare in silenzio e di sorpresa. Il 19 agosto 2025, senza troppi clamori, il team cinese supportato da High-Flyer Capital Management ha caricato DeepSeek 3.1 su Hugging Face. In poche ore il download è esploso, e la community ha iniziato a condividere benchmark e specifiche. 685 miliardi di parametri, contesto fino a 128 mila token, modalità Think & Non-Think in un unico modello e costi di inferenza quasi 30 volte più bassi rispetto gli altri giganti delle API come OpenAI , Google e Anthropic.

Il modello combina capacità conversazionali, di ragionamento e di coding in un’unica architettura ibrida. Ciò che distingue ancora una volta il nuovo modello di DeepSeek non è soltanto la sua potenza computazionale a basso costo, ma la filosofia open-source che ne garantisce l’accessibilità globale.

La disponibilità immediata dei pesi del modello su piattaforme aperte consente a ricercatori, sviluppatori e aziende di tutto il mondo di sperimentare, modificare e implementare liberamente questa tecnologia. Questa scelta strategica contrasta nettamente con l’approccio proprietario e rigidamente controllato adottato dalla maggior parte delle società occidentali, creando un precedente importante per lo sviluppo futuro dell’intelligenza artificiale.

Architettura ibrida e pensiero flessibile: due anime in un solo modello

DeepSeek 3.1 introduce quella che l’azienda definisce un’architettura ibrida; una soluzione ingegneristica che risolve finalmente il problema dell’integrazione di diverse capacità cognitive in un unico modello coerente. I precedenti tentativi di combinare funzioni di chat, ragionamento e coding spesso producevano sistemi che eccellevano in un’area a scapito delle altre; con prestazioni disomogenee e poco affidabili. Con DeepSeek 3.1, invece, queste capacità sono confluite in un unico modello in grado di mantenere alte prestazioni in tutti i domini.

DeepSeek ha di conseguenza rimosso il tag R1 (del modello di ragionamento R1-0528) dal suo chatbot. Ora ogni richiesta è impostata di default sulla versione 3.1.

Per chi sviluppa applicazioni, questo sistema di inferenza ibrida può diventare un alleato importante. E’ veloce e strategico, nel senso che sa adattarsi ai compiti senza spreco computazionale.

Il sistema processa fino a 128.000 token di contesto; equivalenti approssimativamente a un libro di 400 pagine, mantenendo velocità di risposta che surclassano i modelli concorrenti basati su ragionamento esteso. Il supporto per multiple precisioni di calcolo, dal BF16 standard allo sperimentale FP8, offre agli sviluppatori la flessibilità necessaria per ottimizzare le prestazioni in base ai vincoli hardware specifici. Questa adattabilità risulta particolarmente di valore per quelle organizzazioni che lavorano con infrastrutture eterogenee o con budget computazionali limitati.

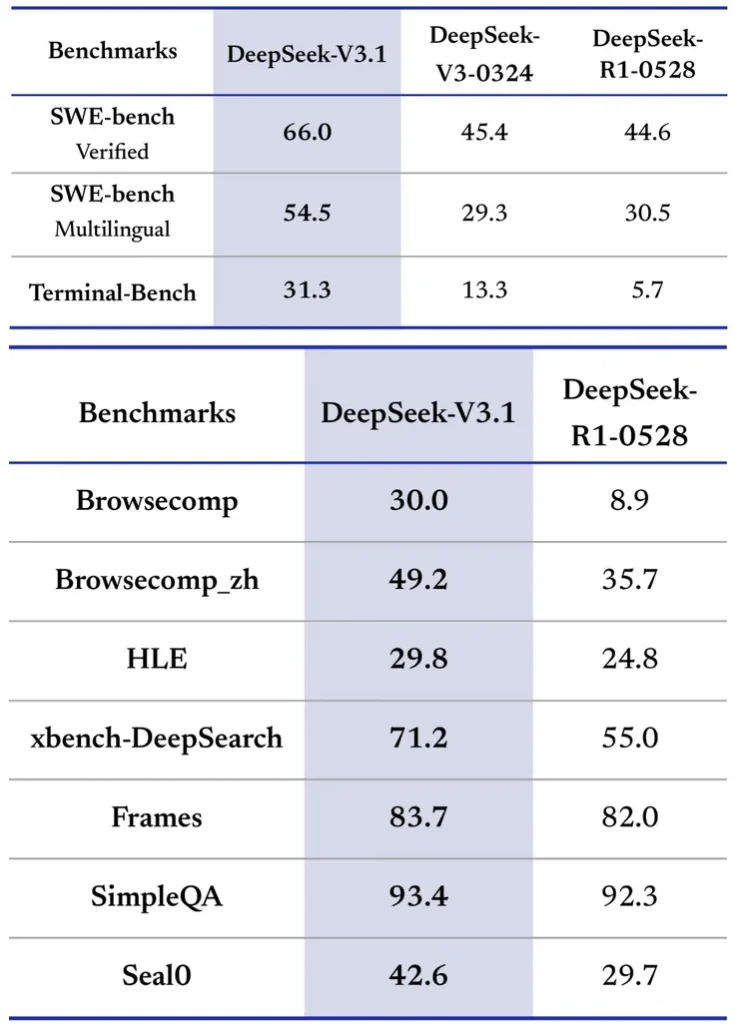

Benchmark DeepSeek 3.1

I test prestazionali condotti nelle prime ore successive al rilascio hanno rivelato punteggi che rivaleggiano con i sistemi proprietari di OpenAI e Anthropic; posizionano V3.1 tra i modelli più performanti attualmente disponibili. Sul prestigioso benchmark di coding Aider, il modello ha raggiunto il 71.6%; supera di un punto percentuale Claude Opus 4 mentre risulta 68 volte più economico da utilizzare.

Le valutazioni su SWE-bench Verified mostrano un tasso di successo del 66% per V3.1 rispetto al 45.4% di V3-0324 e al 44.6% di R1-0528 (il modello di ragionamento di DeepSeek). Un miglioramento importante.

Nella versione multilingue, V3.1 risolve il 54.5% dei problemi, quasi il doppio del ~30% ottenuto dagli altri modelli. Terminal-Bench, che valuta la capacità di un modello di completare task in una shell Linux live, mostra lo stesso pattern; V3.1 ha successo sul 31.3% dei task contro il 13.3% e il 5.7% dei predecessori.

Anche nei benchmark di information retrieval (ricerca sul web), DeepSeek 3.1 dimostra netti miglioramenti. Su BrowseComp, che richiede la navigazione e l’estrazione di risposte da pagine web, V3.1 risponde correttamente al 30% delle domande contro solo il 8.9% di R1-0528. Nella versione in lingua cinese, raggiunge il 49.2% di accuratezza rispetto al 35.7% di R1. Su HLE (un esame linguistico avanzato), V3.1 mantiene un leggero vantaggio con il 29.8% contro il 24.8%. In task di ricerca più approfonditi come xbench-DeepSearch, che richiedono la sintesi di informazioni da multiple fonti, V3.1 segna il 71.2% contro il 55.0% di R1.

DeepSeek 3.1 : oltre i parametri e i benchmark

Dietro le cifre di V3.1 risiedono innovazioni tecniche sofisticate che meritano approfondimento. Il modello si basa sul foundation di V2 con miglioramenti chiave che aumentano capability e inference speed.

La Multi-Head Latent Attention (MLA) è una nuova tecnica usata da DeepSeek per migliorare il modo in cui “capiscono” le informazioni. Nei sistemi tradizionali, diversi moduli del modello analizzano parti diverse dei dati per trovare collegamenti e relazioni. Con MLA, però, vengono introdotte delle “caratteristiche latenti”; cioè rappresentazioni intermedie che aiutano questi moduli a concentrarsi sui punti davvero importanti. In questo modo il modello riesce a cogliere schemi più complessi e collegamenti anche tra elementi molto distanti; senza aumentare in modo significativo il carico di calcolo.

L’architettura di DeepSeek 3.1 è del tipo Mixture-of-Experts (MoE); organizza i 671 miliardi di parametri in modo che solo 37 miliardi siano attivi per token. Questo mantiene il compute di inference vicino a quello di modelli molto più piccoli mentre si raggiunge accuratezza superiore.

Il pioneering Auxiliary-Loss-Free Load Balancing è una tecnica usata da DeepSeek nell’addestramento del modello 3.1 . In pratica, permette di distribuire meglio il lavoro tra le varie parti del modello senza dover aggiungere un termine di errore extra per guidare l’apprendimento. Questo rende il processo di training più semplice e aiuta il modello a essere più stabile mentre impara.

Infine il Multi-Token Prediction Objective è una tecnica che cambia il modo in cui il modello impara a prevedere le parole da generare nelle risposte. Nei sistemi tradizionali, l’AI indovina una parola alla volta, passo dopo passo. Con questo approccio invece, il modello viene addestrato per prevedere più parole future in un unico colpo. Questo gli permette di imparare schemi più complessi e di diventare più efficiente quando deve generare testo.

DeepSeek 3.1: tempi di training del modello

Le tecniche combinate (citate sopra) hanno permesso al team di DeepSeek di addestrare il modello utilizzando molte meno ore di GPU rispetto al normale; pur lavorando sulla stessa quantità di dati. Inoltre, durante alcune fasi dell’addestramento viene usata la precisione FP8; ovvero un formato di calcolo che occupa meno memoria e riduce la quantità di dati da scambiare. Questo rende il processo molto più leggero rispetto all’uso delle classiche precisioni a 16 o 32 bit. L’intero processo di training ha richiesto circa 2,8 milioni di ore di GPU H800.

Un risultato notevole considerando le dimensioni e la complessità del modello. Se supponiamo un utilizzo di solo 2000 GPU H800 (molto poche rispetto alle GPU utlizzate per il training di GPT, Grok ed altri modelli chiusi), sarebbero stati necessari solo 58 giorni per il training del modello. Meno tempo e meno consumi.

Democratizzazione dell’accesso all’IA avanzata

L’efficienza di DeepSeek V3.1 si traduce in vantaggi economici sostanziali che potrebbero alterare radicalmente il panorama competitivo del settore. A un costo di circa 1.01 dollari per task di coding completo, V3.1 offre risultati comparabili a sistemi che costano quasi 70 dollari per carico di lavoro equivalente. Per utenti enterprise che gestiscono migliaia di interazioni AI giornaliere, queste differenze di costo si traducono in potenziali risparmi.

Questo approccio sfida le assunzioni fondamentali su come i sistemi AI all’avanguardia dovrebbero essere sviluppati e distribuiti. I tradizionali approcci supportati da venture capital richiedono investimenti massicci in infrastrutture computazionali; talento di ricerca e compliance normativa. Costi che devono essere recuperati attraverso prezzi premium. La strategia open-source di DeepSeek capovolge questo modello; potenzialmente mina la capacità dei concorrenti di mantenere margini elevati su capacità simili.

Le compagnie americane come OpenAI, Anthropic, xAI con Grok e Google con Gemini considerano i loro modelli come proprietà intellettuale di valore che richiede protezione e monetizzazione. Le aziende cinesi al contrario trattano sempre più l’IA avanzata come bene pubblico che accelera l’innovazione attraverso l’accesso diffuso. Questa divergenza di strategia potrebbe avere implicazioni profonde per il futuro dello sviluppo tecnologico globale. Nel frattempo, anche la competizione interna è feroce. Alibaba con Qwen3, GLM-4.5, Kimi K2… la scena è affollata.

DeepSeek 3.1: integrazione e accessibilità

DeepSeek 3.1 offre multiple modalità di accesso che ne facilitano l’adozione attraverso diversi scenari d’uso. L’applicazione web ufficiale su deepseek.com fornisce un’interfaccia chat browser-based dove V3.1 è già impostato come default, senza necessità di configurazione. Al momento il chatbot è completamente gratuito; anche se dopo alcune richieste ripetitive potrebbe rifiutarsi di rispondere con l’errore “Server busy, please try again later“. E’ disponibile anche un chatbot Deepseek per Android e iOS.

Per gli sviluppatori, l’accesso API attraverso gli endpoint deepseek-chat (per uso generale) e deepseek-reasoner (per modalità ragionamento) offre integrazione semplice con applicazioni esistenti; con un’interfaccia compatibile con OpenAI che garantisce familiarità immediata per chi ha già utilizzato gli SDK di OpenAI.

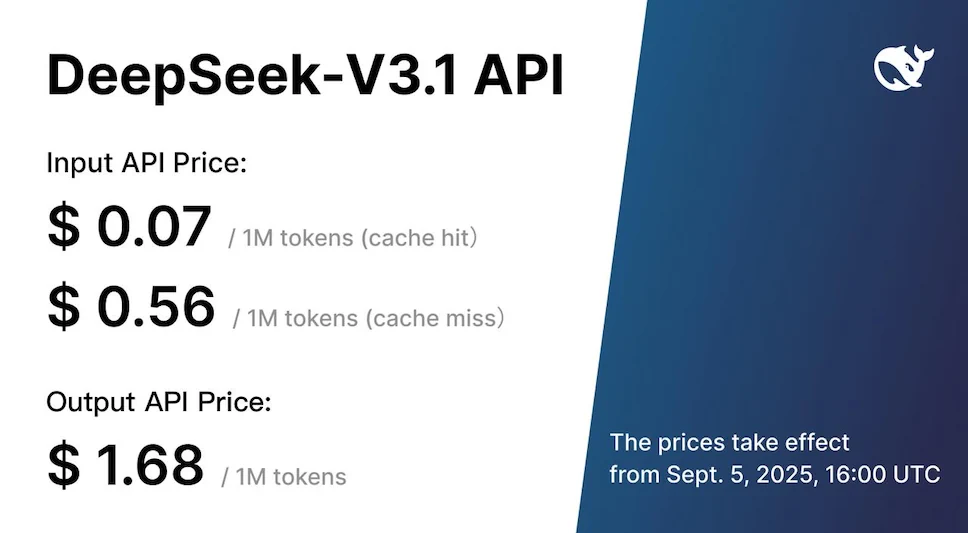

L’API supporta contesto fino a 128K token per entrambe le modalità; inoltre, formati API Anthropic compatibili e Strict Function Calling in versione beta. Le risorse API sono state potenziate per garantire un’esperienza più fluida e affidabile. Il pricing aggiornato, effettivo dal 5 settembre 2025, si posiziona a : 0.07 dollari per milioni di token in input (cache hit), 0.56 dollari (cache miss) e 1.68 dollari per milioni di token in output.

DeepSeek ha promesso sconti in fascia notturna per chi usa l’API in orari di minore traffico. Le soft-cap attuali sono 100 richieste al minuto e 10 mila token al secondo. Se gestisci un servizio ad alta concorrenza, puoi richiedere un aumento del limite compilando un modulo di whitelist. Infine, non esiste paywall; i pesi sono liberi, quindi puoi sempre migrare on-premise se il budget si stringe.

Esecuzione in locale

Per chi necessita di maggiore controllo o desidera eseguire il modello localmente, i pesi grezzi di V3.1 sono pubblicati su Hugging Face. La licenza è aperta ed è possibile il download e l’implementazione su hardware proprio.

Ma non farti illusioni; anche un PC con 256 GB di RAM e la più veloce delle GPU con 24 GB di RAM, potrebbe essere insufficiente ad eseguire localmente DeepSeek 3.1 a velocità accettabili (toker per secondo). Ti serve un cluster multi-GPU per eseguirlo in locale ad oltre 10 sec per token; oppure dovrai optare per versioni del modello distillate ed ottimizzate.

DeepSeek V3.1 ridefinisce le regole del gioco

La dimostrazione di DeepSeek che le prestazioni all’avanguardia possono coesistere con l’accesso aperto rivela come le barriere artificiali che una volta definivano la competizione AI si stiano sgretolando. Se la versione V3.1 è solo un passaggio intermedio verso la futura V4, allora i cambiamenti che stiamo vedendo oggi potrebbero sembrare piccoli rispetto a quello che arriverà.

Ciò che è iniziato come competizione su chi potesse costruire i sistemi più potenti si è evoluto in una contest su chi possa rendere quei sistemi più accessibili.

Le compagnie AI americane dovranno affrontare una sfida esistenziale; se alternative open-source possono eguagliare le prestazioni proprietarie mentre offrono maggiore flessibilità e costi inferiori, i tradizionali vantaggi dello sviluppo chiuso scompaiono.

Le aziende dovranno impegnarsi a dimostrare di offrire un valore davvero superiore; al fine di poter giustificare prezzi più alti rispetto alla concorrenza. E GPT-5 non è stato quel cambiamento che tutti si aspettavano, nessun effetto wow.

La competizione potrebbe favorire l’innovazione, spingendo tutte le aziende a sviluppare nuove capacità in modo ancora più rapido. Allo stesso tempo, però, apre interrogativi su come costruire modelli di business sostenibili; in un settore dove i costi di utilizzo tendono quasi a zero e i vantaggi competitivi possono svanire velocemente. Il successo di DeepSeek mostra che il futuro dell’intelligenza artificiale potrebbe essere più aperto, accessibile e vario di quanto molti immaginavano.