Ieri durante il docidesimo ed ultimo giorno del suo evento speciale “12 Days of OpenAI”, Sam Altman, ha introdotto due nuovi modelli di “ragionamento” IA o3 e o3 mini; ovvero le versioni successive di o1 e o1 mini. Invece di seguire una nomenclatura sequenziale prevedibile, OpenAI ha saltato o2 a causa di un potenziale conflitto di copyright con il marchio O2; un noto fornitore di servizi di telecomunicazioni britannico.

OpenAI svela o3 e o3 mini

Come in o1 e o1 mini, o3 è il modello principale con ampie capacità; invece o3 mini, è una versione più compatta e veloce ma altrettanto abile. È importante notare che questi nuovi modelli o3 non saranno immediatamente disponibili al pubblico. OpenAI ha delineato un piano per renderli accessibili inizialmente per test di sicurezza pubblici.

Questo approccio prudente sottolinea l’importanza che OpenAI attribuisce alla sicurezza man mano che i suoi modelli acquisiscono maggiore competenza. OpenAI ha aperto l’accesso a ricercatori esterni che desiderano contribuire al processo di test.

Sam Altam ha promesso il rilascio pubblico di o3 mini per fine gennaio e o3 subito dopo. Nel video di presentazione ha espresso entusiasmo nel mostrare le potenzialità di questi modelli e ha mostrato dimostrazioni e benchmark per evidenziarne le capacità.

Abilità tecniche di o3

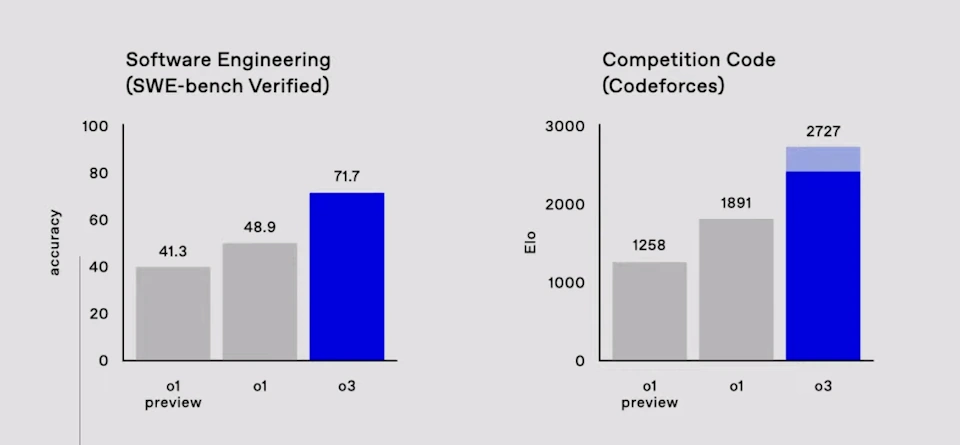

Il modello o3 dimostra una notevole competenza in una serie di benchmark tecnici complessi; in particolare in compiti che coinvolgono la programmazione e la matematica. Nei benchmark di programmazione, come il “sweet bench verified”, che valuta le prestazioni su attività di sviluppo software reali, o3 raggiunge un’accuratezza del 71,7%.

Questo risultato supera di oltre il 20% le prestazioni dei modelli o1; evidenzia un progresso sostanziale nella capacità del modello di affrontare sfide di codifica complesse. Nel contesto della programmazione competitiva, dove i modelli vengono valutati in base alla loro capacità di risolvere problemi algoritmici in competizioni come “code forces”, o3 ha ottenuto un punteggio ELO di circa 2727 nelle impostazioni di calcolo con tempi di test elevati e aggressivi.

Questo dato è particolarmente degno di nota se confrontato con i punteggi ottenuti da programmatori competitivi umani esperti. Anche in ambito matematico, o3 mostra abilità eccezionali. Nei benchmark di matematica competitiva, il modello raggiunge un’accuratezza del 96,7% nel test Amy, rispetto all’83,3% del modello o1. Questo livello di precisione indica che o3 spesso sbaglia solo una domanda nei test per l’Olimpiade matematica statunitense.

o3 nei test scientifici

Le prestazioni di o3 sono altrettanto notevoli in benchmark scientifici di livello di dottorato. Per esempio, nel gpq Diamond ottiene un punteggio dell’87,7%. Questo valore è superiore di circa il 10% rispetto alle prestazioni del modello o1 e supera il tipico punteggio del 70% ottenuto da esperti con dottorato di ricerca nel loro campo.

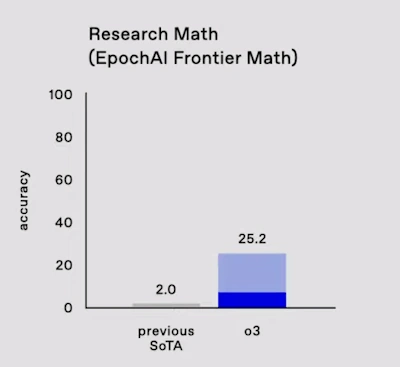

o3 è stato testato anche con il benchmark Epic AI Frontier Math; un benchmark creato appositamente per testare a fondo modelli IA. Presenta problemi inediti e particolarmente complessi che richiedono ore o addirittura giorni per essere risolti da matematici professionisti.

Attualmente, i migliori modelli IA raggiungono un’accuratezza pari al 2% su questo benchmark. o3, con impostazioni di test aggressive, è stato in grado di superare il 25%.

Il traguardo di o3 nel benchmark Arc AGI

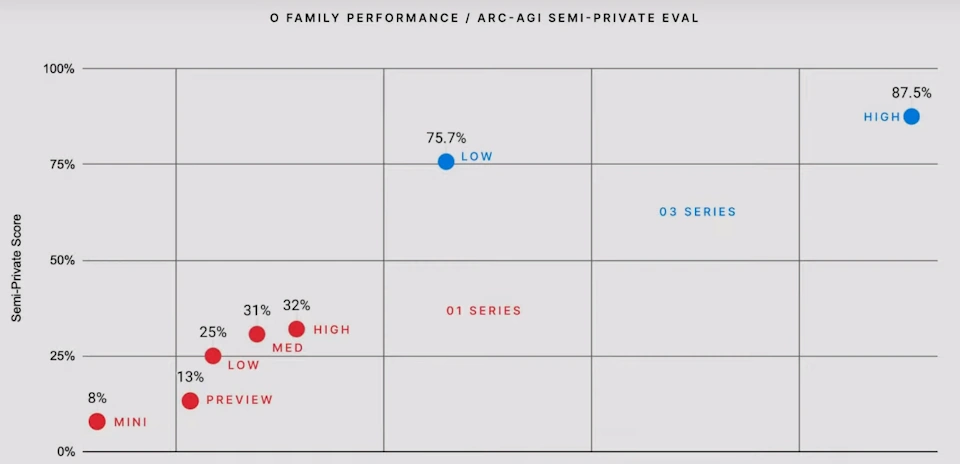

Un momento saliente del video è stata la discussione sul benchmark Arc Artificial General Intelligence (AGI); è considerato un test fondamentale per l’intelligenza artificiale generale. Creato nel 2019, Arc AGI ha resistito come una sfida irrisolta per cinque anni.

Il benchmark Arc AGI si concentra sulla capacità di un sistema di comprendere e applicare principi di trasformazione attraverso esempi. Ai partecipanti vengono presentati set di input-output e il compito è dedurre la regola sottostante e applicarla per completare un output incompleto.

Questi compiti, pur essendo intuitivi per gli esseri umani, si sono dimostrati sorprendentemente difficili per i sistemi di intelligenza artificiale. La difficoltà di Arc AGI risiede nel fatto che ogni compito richiede un insieme distinto di abilità. Inoltre, impedisce ai modelli di fare affidamento su schemi memorizzati in fase di apprendimento. La versione 1 di Arc AGI ha visto progressi lenti; passando dallo 0% al 5% di accuratezza in cinque anni con i principali modelli di IA.

Tuttavia, o3 ha ottenuto un nuovo punteggio all’avanguardia del 75,7% sul set di holdout semi-privato di Arc AI con risorse computazionali limitate. Ancora più notevole è che, aumentando le risorse computazionali per o3, il modello ha raggiunto un punteggio dell’85,7%.

Questo risultato è particolarmente significativo perché le prestazioni umane su questo benchmark sono comparabili a una soglia dell’85%. Superare questa soglia seppure di pochissimo indica che o3 ha dimostrato una sorta di capacità di ragionamento a livello umano; un risultato senza precedenti per qualsiasi sistema di intelligenza artificiale testato finora.

Impegno per la sicurezza e l’accessibilità di OpenAI

Mentre i punteggi ottenuti da o3 nei vari benchmark sono entusiasmanti, OpenAI riconosce che il lavoro nello sviluppo di un’intelligenza artificiale sicura e affidabile è tutt’altro che completo. L’azienda sottolinea la necessità di benchmark più completi e duraturi, come Arc AGI, per misurare e guidare il progresso. Inoltre, OpenAI ha espresso il suo entusiasmo per la collaborazione con entità esterne per sviluppare benchmark di prossima generazione.

Inoltre, OpenAI sta lavorando a una nuova tecnica chiamata allineamento deliberativo per migliorare ulteriormente la sicurezza dei suoi modelli. Questo metodo sfrutta le capacità di ragionamento dei modelli stessi per identificare e prevenire potenziali prompt non sicuri; un progresso nello sviluppo di sistemi di intelligenza artificiale più sicuri e affidabili.

o3 mini

Parallelamente allo sviluppo del modello o3, OpenAI ha presentato anche o3 mini; un modello di ragionamento efficiente in termini di costi che si unisce alla famiglia o1 mini. o3 mini si distingue per la sua capacità di fornire buone prestazioni a un costo inferiore. Come il modello o3, la versione mini non sarà immediatamente accessibile a tutti. OpenAI sta aprendo l’accesso a o3 mini a ricercatori sulla sicurezza per i test. I ricercatori interessati possono candidarsi tramite un modulo sul sito Web di OpenAI. Le domande si chiuderanno il 10 gennaio.

Una nuova funzionalità, denominata “tempo di pensiero adattivo” nell’API, consentirà di regolare il tempo dedicato dal modello al ragionamento; offre flessibilità per diversi casi d’uso. Le valutazioni iniziali di o3 mini mostrano risultati promettenti nei benchmark di codifica, con prestazioni che migliorano con tempi di pensiero più lunghi e che superano il modello o1 mini con tempi di pensiero medi. In termini di costi ed efficienza, o3 mini definisce una nuova frontiera. Offre prestazioni di codifica comparabili o migliori a un costo inferiore rispetto a o1 mini.

Una dimostrazione pratica ha evidenziato la capacità di o3 mini di generare ed eseguire codice Python, inclusa la creazione di un server e di un’interfaccia utente per attività di programmazione interattive. o3 mini dimostra anche competenza in matematica; ottiene prestazioni comparabili a o1 mini con tempi di elaborazione ridotti e prestazioni migliori con tempi di elaborazione medi.

OpenAI Day 12: conclusione

Sam Altam ha voluto concludere l’evento speciale “12 Days of OpenAI” con la dimostrazione di due modelli IA non ancora disponibili al pubblico, o3 e o3mini.

Ne ha evidenziato le prestazioni eccezionali su benchmark impegnativi come Epic AI Frontier Math e Arc AGI; un chiaro segnale dei crescenti livelli di sofisticazione raggiunti da questi sistemi. Il raggiungimento di prestazioni a livello umano sul benchmark Arc AGI in contesti di calcolo elevato è un risultato particolarmente degno di nota. Sottolinea il potenziale di questi modelli per affrontare compiti complessi che richiedono capacità di ragionamento avanzate.

L’annuncio di o3 e o3 mini segnala una fase promettente nello sviluppo dell’intelligenza artificiale, caratterizzata da progressi significativi nelle capacità di ragionamento e da un continuo impegno per la sicurezza e la collaborazione.