Gemini, nella sua versione con la modalità Deep Think, è riuscito a risolvere con successo cinque dei sei problemi proposti all’International Mathematical Olympiad (IMO) nella città di Sunshine Coast in Australia. La IMO è forse la più prestigiosa competizione mondiale di matematica per studenti della scuola secondaria di secondo grado. Alla gara hanno preso parte 630 concorrenti provenienti da 110 Paesi, tra cui 69 ragazze e 12 italiani. Con un punteggio di 35 su 42, GeminiAI si è posizionato sullo stesso livello dei migliori giovani matematici del mondo; quelli che, ogni anno dal 1959, affrontano i quesiti più complessi in algebra, geometria, calcolo combinatorio e teoria dei numeri.

Le medaglie vengono assegnate alla metà migliore dei concorrenti, con circa l’8% che riceve una prestigiosa medaglia d’oro. Ma non è solo una questione di numeri; dimostra come l’AI sia capace di ragionare in linguaggio naturale, in modo strutturato, senza bisogno di strumenti formali intermedi.

Lo scorso anno, Google DeepMind si era fermata a una medaglia d’argento grazie ai modelli AlphaGeometry e AlphaProof. In quel caso, servivano giorni di calcolo e una traduzione manuale dei problemi in linguaggi formali come Lean. Ora, invece, Gemini ha gestito tutto il processo end-to-end, restituendo soluzioni complete in appena 4,5 ore; lo stesso tempo a disposizione degli studenti in gara.

Deep Think

Il protagonista di quest’anno dell’IMO è Deep Think; ovvero, la modalità avanzata di ragionamento progettata per affrontare problemi altamente complessi in modo non lineare. I modelli precedenti seguivano un’unica catena di deduzioni. Invece, la nuova versione consente a GeminiAI di esplorare più ipotesi in parallelo; quindi, analizzarle, confrontarle e solo successivamente arrivare a una risposta consolidata. Il processo, noto come parallel thinking, è possibile grazie all’integrazione di nuove tecniche di reinforcement learning applicate al ragionamento matematico multi-step.

Per ottenere queste capacità, DeepMind ha addestrato il modello su corpora selezionati di soluzioni matematiche di qualità elevata, integrando nel sistema anche suggerimenti strategici su come affrontare i problemi dell’IMO. Inoltre, a differenza dell’edizione precedente, quest’anno Gemini ha operato esclusivamente in linguaggio naturale. Questo ha permesso di ottenere risultati molto più rapidi, mantenendo elevati standard di correttezza.

GeminiAI: prestazioni da medaglia d’oro

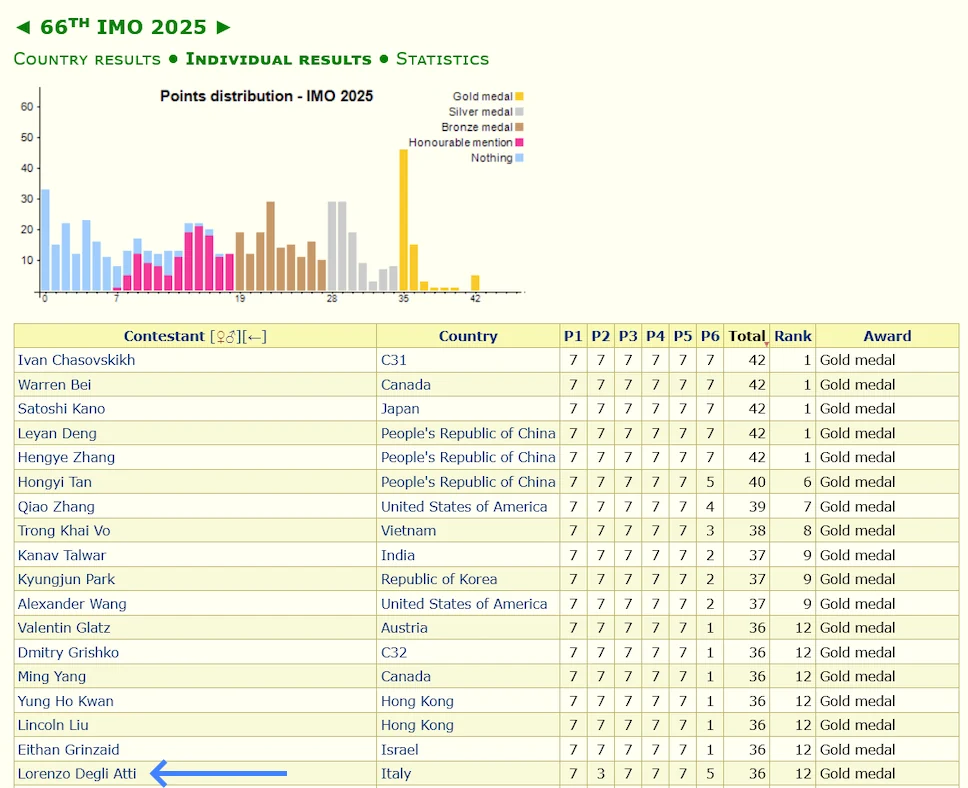

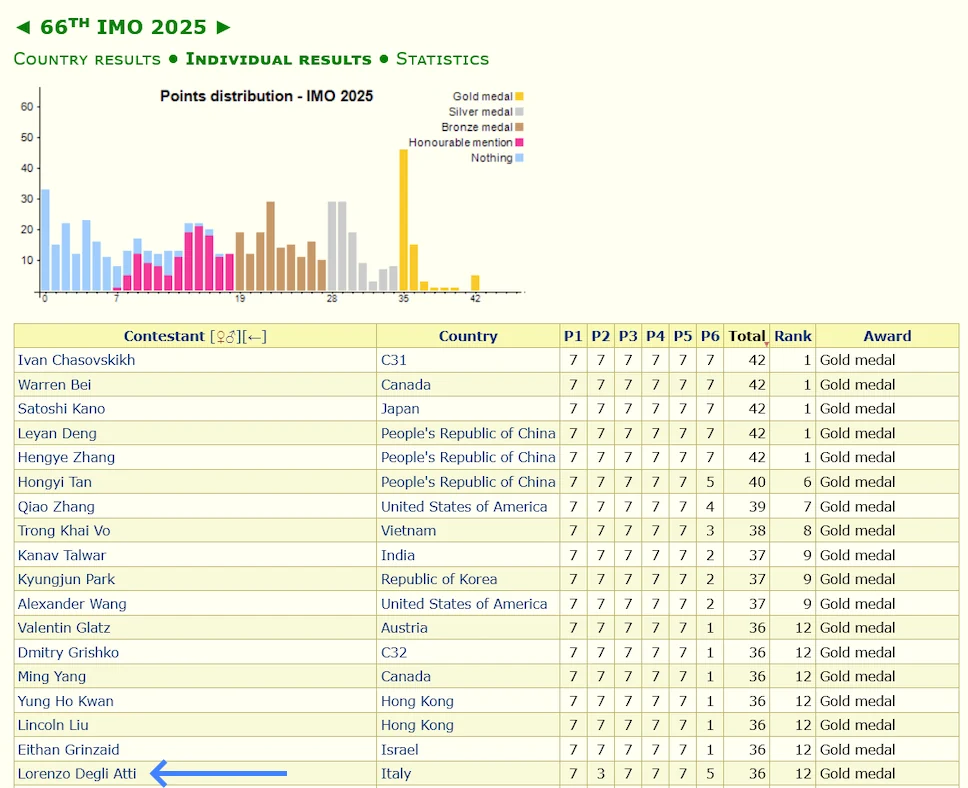

La performance di Gemini Deep Think è stata ufficialmente certificata dai coordinatori dell’IMO. Il modello ha risolto correttamente i problemi da 1 a 5, totalizzando 35 punti su un massimo di 42. Ogni problema valeva 7 punti; il sesto, il più difficile, è stato lasciato irrisolto da quasi tutti i partecipanti umani, con solo 6 concorrenti (su 630) in grado di ottenere il massimo punteggio.

Questo risultato pone Gemini allo stesso livello dei concorrenti umani più brillanti, ma con una differenza sostanziale: il modello ha lavorato in totale autonomia, senza accedere a Internet, senza usare strumenti esterni o assistenza umana. Una prestazione che evidenzia quanto sia avanzato il livello di generalizzazione e comprensione logica raggiunto da DeepMind.

Curiosità, nella classifica finale si è ben piazzato il concorrente italiano Lorenzo Degli Atti , giovanissimo talento appena diplomato alle superiori. Ha superato di un punto Deep Think (36 contro 35) e nel più difficile test (P6) ha raggiunto un opttimo punteggio di 5 su 7.

Anche OpenAI ha ottenuto un punteggio identico con il proprio modello; tuttavia, solo il team di Google ha partecipato all’iniziativa in modo ufficiale, con una valutazione formale da parte degli organizzatori.

GeminiAI delinea nuove frontiere tra AI e matematica

Il buon risultato di GeminiAI all’IMO 2025 con il modello Deep Think dimostra che l’AI potrebbe diventare uno strumento prezioso per la ricerca matematica avanzata. Google DeepMind sta infatti proseguendo lo sviluppo dei modelli formali AlphaGeometry e AlphaProof, integrando linguaggio naturale e rigore logico.

Nel lungo periodo, sistemi come Gemini potrebbero diventare compagni di lavoro per scienziati, ingegneri e teorici, aiutando nell’analisi, nella formulazione di ipotesi e nella verifica di risultati. Non si parla più solo di automatizzare la scrittura di codice o la generazione di contenuti: si tratta di pensare insieme a modelli in grado di ragionare con flessibilità, intuizione e rigore.

Google ha annunciato che una versione test di Deep Think sarà presto disponibile per alcuni ricercatori selezionati, prima di essere estesa agli abbonati del servizio AI Ultra. Una collaborazione diretta tra AI e comunità accademica.

Cosa significa davvero il risultato di GeminiAI

Il vero valore della medaglia d’oro di GeminiAI non sta nel punteggio, sebbene eccellente; ma nella modalità con cui è stata vinta. Gemini Deep Think ha operato su testi complessi, interpretato problemi di alto livello e restituito dimostrazioni strutturate. E tutto questo è avvenuto in condizioni paragonabili a quelle dei concorrenti umani. Gemini evidenzia la possibilità di costruire modelli AI capaci di ragionamento astratto, adattabili a discipline in cui la creatività e la logica si combinano.