Il team cinese Qwen di Alibaba Cloud famoso per i suoi modelli AI LLM open source, ieri a presentato un modello AI open source specifico per lo sviluppo del codice, una proposta molto ambiziosa. Ha una struttura MoE (Mixture-of-Experts) da 480 miliardi di parametri; di cui 35 miliardi attivi per ogni inferenza. Qwen3-Coder è pensato per essere un alleato efficace nella scrittura autonoma di codice, capace di gestire fino a un milione di token di contesto grazie all’extrapolazione. Chi lavora su grandi progetti, repository o ambienti CI/CD può trovarvi una risorsa preziosa.

Le sue capacità non si limitano alla semplice generazione di snippet; Qwen3-Coder si muove in modo agente, può integrarsi in flussi di lavoro, gestire tool esterni e affrontare compiti multi-turno come debugging, testing, e refactoring. Qwen mostra eccellenti risultati nei benchmark come SWE-bench-Verified, terminal-bench e Spider. Grazie all’integrazione con lo strumento da riga di comando Qwen Code, fornisce un’esperienza completa che va oltre la sola creazione di codice.

Architettura e contesto esteso di Qwen3-Coder

Alla base di Qwen3-Coder troviamo una struttura Mixture-of-Experts con 160 esperti, di cui otto attivati per ogni inferenza. Se per esempio viene richiesto un lavoro in Python che richiede conoscenze nel ramo della fisica il modello caricherà 8 esperti che sono maggiormente correlati con la richiesta. Questo approccio permette di ridurre il carico computazionale pur mantenendo le stesse capacità di risposta. Il modello è studiato per mantenere efficienza e scalabilità, qualità cruciali per l’uso in ambienti di sviluppo reali.

Uno degli elementi chiave è la gestione del contesto; Qwen3-Coder supporta nativamente 256.000 token, ma tramite tecniche di extrapolazione come YaRN può raggiungere 1 milione di token; adattandosi così a lavorare su file o progetti di codice di grandi dimensioni. A livello di codice, la compatibilità è ampia; si spazia da Python e JavaScript fino a C++, Go, Rust e linguaggi di markup.

In fase di addestramento il modello Qwen3-Coder ha beneficiato di un dataset da 7.5 trilioni di token con il 70% dedicato a codice; pulito e ottimizzato grazie all’intervento del predecessore Qwen2.5-Coder. Questa base solida si traduce in una maggiore affidabilità, sia nel completamento delle istruzioni che nella comprensione semantica del contesto.

Reinforcement Learning e codice agente: addestramento e applicazioni

Qwen3-Coder non è un modello che si limita a creare codice, ma interagisce. Il suo training è stato potenziato con Reinforcement Learning su larga scala e l’uso del paradigma Long-Horizon RL; specificamente pensato per task interattivi, come quelli affrontati nel benchmark SWE-Bench. Non produce solo codice, ma si confronta con strumenti, pianifica azioni, riceve feedback e prende decisioni autonome.

Durante la fase di addestramento, Alibaba ha messo in campo 20.000 ambienti paralleli su cloud per simulare interazioni reali, testare istruzioni complesse e raffinare la capacità decisionale. Questo approccio ha permesso di migliorare drasticamente i tassi di successo dell’esecuzione del codice generato; questo ha reso Qwen3-Coder una scelta valida per flussi di lavoro dinamici.

Non meno importante è la parte agentica; grazie all’integrazione con tool esterni, il modello può esplorare documentazione, modificare file esistenti, generare test automatici o suggerire miglioramenti. Si tratta di un livello d’interazione che supera il prompt singolo per entrare in un ciclo continuo di collaborazione tra IA e sviluppatore.

Qwen Code: un CLI potente per lo sviluppo interattivo

A fianco del modello Qwen3-Coder, Alibaba ha sviluppato e rilasciato Qwen Code (una versione forked di Gemini Code); uno strumento da riga di comando. L’obiettivo è offrire un’interfaccia per sfruttare appieno le capacità agentiche del modello. Questo CLI include prompt personalizzati, protocolli avanzati per le chiamate di funzione e integrazione fluida con gli ambienti di sviluppo più diffusi.

Qwen Code consente di lanciare interazioni multi-turno, generare codice in modo incrementale, eseguire modifiche context-aware e pilotare cicli di debugging o test. Tutto ciò avviene senza abbandonare il terminale, rendendo l’integrazione con CI/CD e ambienti devops diretta e snella.

Il codice prodotto può essere raffinato in base al feedback del compilatore o dei test. La funzione di iniezione del contesto permette inoltre di fornire al modello informazioni come changelog o issue tracker, per generare risposte aderenti alla realtà del progetto. La trasparenza è un altro punto di forza; essendo tutto open-source, è possibile ispezionare, modificare o adattare sia Qwen Code che il modello Qwen3-Coder.

Dove e come usare Qwen3-Coder

Qwen3-Coder è disponibile in forma gratuita tramite la chat conversazionale sul sito ufficiale chat.qwen.ai . Il modello Qwen3-Coder è invece già disponibile su GitHub, Hugging Face e ModelScope. Chi desidera testare il modello può accedere facilmente a tutte le versioni; sia in formato base che nella variante Instruct, progettata per rispondere a prompt in linguaggio naturale. L’intera architettura è distribuita con licenza Apache 2.0, quindi aperta a modifiche e integrazioni.

Per chi lavora in ambienti di produzione è fondamentale sapere che Qwen3-Coder può essere integrato tramite API compatibili con i framework Hugging Face Transformers.

Chi desidera integrare Qwen3-Coder localmente può utilizzare llama.cpp o ambienti ottimizzati per GPU, con supporto anche per Mac Studio con M3 Ultra.

Qwen3-Coder : prestazioni e benchmark

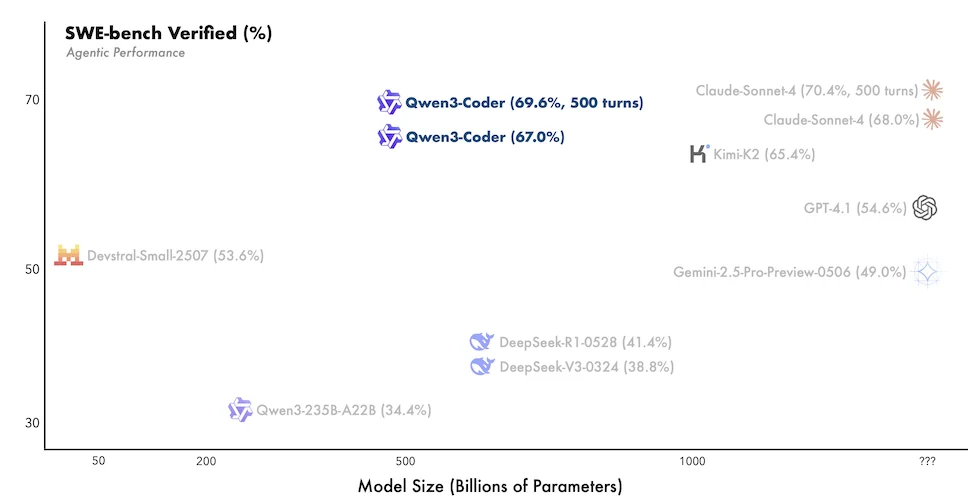

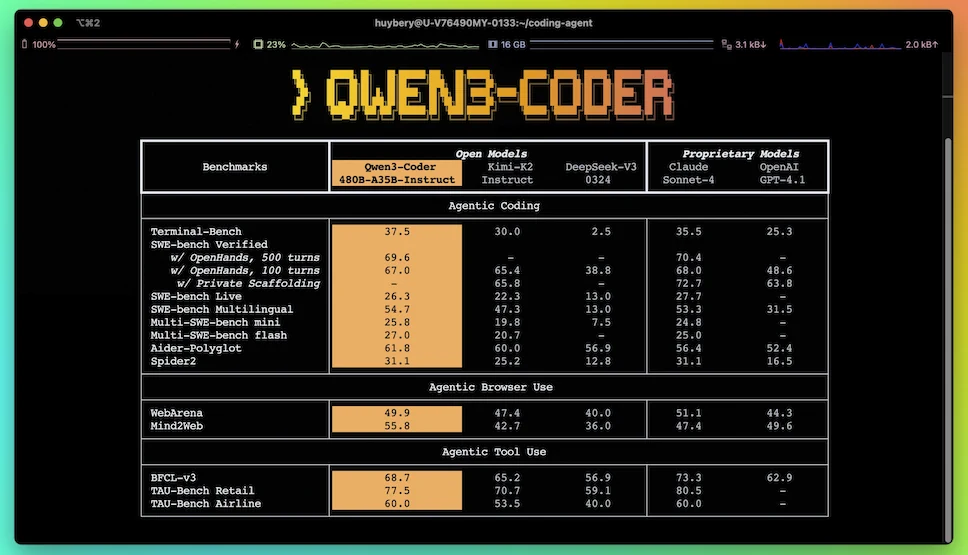

Nei benchmark pubblici, il modello Qwen3-Coder mostra risultati superiori alla media tra i modelli open-source; in alcuni casi, riesce a eguagliare anche soluzioni commerciali chiuse.

Su SWE-bench Verified, un test pensato per valutare l’efficacia del codice generato in contesti reali, Qwen3-Coder riesce a completare con successo task complessi. Su benchmark come Spider, terminal-bench e SWEBENCH, la sua accuratezza risulta tra le più alte.

Inoltre, grazie alla struttura agentica, Qwen3-Coder si comporta bene anche su test che richiedono ragionamento distribuito e interazione multi-turno. Supera modelli come DeepSeek V3 e Kimi K2 in contesti che includono planning, chiamate a strumenti esterni, refactoring guidato. Anche modelli chiusi come Claude Sonnet 4 vengono in alcuni casi raggiunti o battuti in performance; pur mantenendo requisiti hardware contenuti se eseguito in modalità quantizzata.

Questi benchmark confermano la solidità tecnica di Qwen3-Coder. Per chi cerca uno strumento affidabile, potente e pronto all’integrazione, Qwen3-Coder si candida come una delle scelte più sensate nel panorama attuale.

La presenza di Qwen Code come CLI dedicata permette di misurare con precisione i tempi di risposta e il tasso di successo nei diversi task; fornisce metriche utili anche in fase di valutazione professionale.

Un modello flessibile con un occhio al futuro

La disponibilità su GitHub, Hugging Face e ModelScope, unita alla licenza open Apache 2.0, permette a chiunque di testare, adattare e migliorare il modello Qwen3-Coder. Le versioni quantizzate (4bit, 8bit, 16bit) estendono ulteriormente la portabilità, rendendolo accessibile anche a chi non dispone di server di fascia alta.

Chi cerca prestazioni elevate può puntare sul modello 480B A35B; chi necessita di una soluzione più leggera può invece orientarsi verso versioni più compatte. Qwen3-Coder si dimostra solido nel codice e brillante nelle interazioni. La competizione IA è infuocata; e’ un momento storico molto interessante ed eccitante per gli sviluppatori.

Chat: https://chat.qwen.ai/

Blog: https://qwenlm.github.io/blog/qwen3-coder/

Modello: https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct

Qwen Code: https://github.com/QwenLM/qwen-code