La strategia di Alibaba nel campo dell’intelligenza artificiale ha subito un cambiamento netto con l’annuncio di Qwen3-Max-Preview, il suo modello più grande e performante mai realizzato. Fino a poco tempo fa, l’azienda si distingueva per la pubblicazione di versioni open source dei suoi modelli Qwen, come Qwen-3, Qwen 2 e Qwen-1.5, rilasciati sotto licenza Apache 2.0. Queste iniziative avevano permesso ad Alibaba di guadagnare credibilità e visibilità nella comunità globale degli sviluppatori, offrendo strumenti potenti e liberamente accessibili.

Con Qwen3-Max-Preview, però, la direzione è diversa. Il modello non è disponibile per il download; non esistono pesi pubblici, né codice sorgente aperto. L’accesso è limitato a tre canali: Qwen Chat, l’API di Alibaba Cloud e la piattaforma OpenRouter. Questo significa che chiunque voglia sfruttare le capacità del modello con le API deve passare attraverso servizi a pagamento.

Il contrasto è netto con altri modelli cinesi come DeepSeek R1 o Kimi K2; modelli che continuano a puntare sull’apertura per attrarre la community e competere con i modelli IA degli Stati Uniti.

Forse, l’apertura di Alibaba era solo una fase iniziale; utile per costruire una base di utenti e competenze, prima di chiudere le porte sui suoi asset più preziosi. Il modello, con oltre un trilione di parametri, promette prestazioni superiori ai precedenti.

Qwen3-Max-Preview: architettura del modello da un trilione di parametri

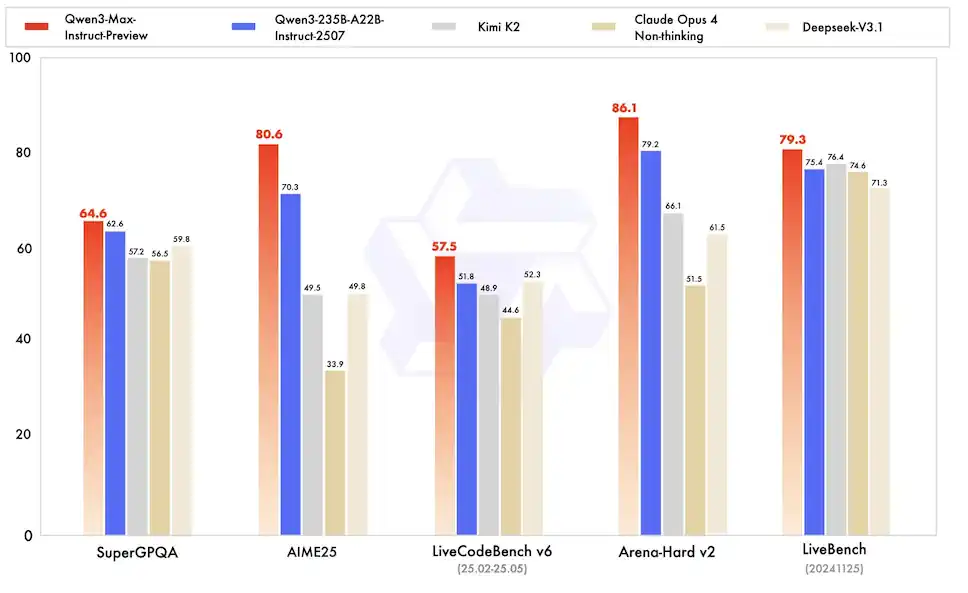

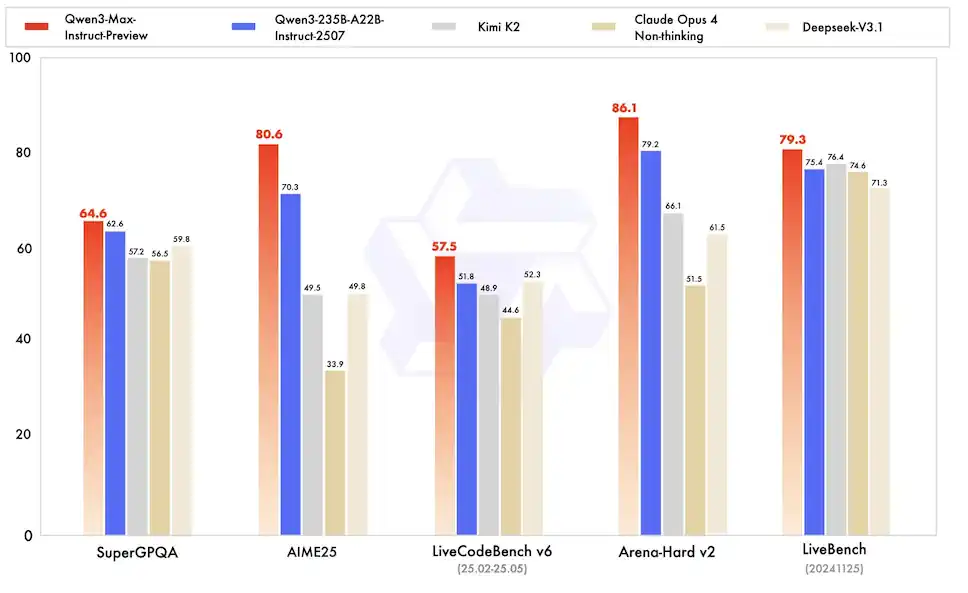

I benchmark interni di Alibaba indicano che Qwen3-Max-Preview supera nettamente il suo predecessore, Qwen3-235B-A22B-2507, in diverse aree critiche. Mostra miglioramenti tangibili nella gestione della conoscenza, nelle conversazioni naturali, nell’esecuzione di compiti complessi e nel seguire istruzioni con precisione. Un aspetto particolarmente apprezzato è la riduzione delle cosiddette allucinazioni, ovvero la tendenza dei modelli a generare informazioni plausibili ma incorrette.

L’architettura permette di elaborare fino a 258.048 token in input e di generare fino a 32.768 token in output. Questa capacità lo rende adatto per analizzare documenti lunghi, codice complesso o conversazioni estese senza perdere il filo del discorso. Supporta oltre 100 lingue, rendendolo uno strumento potenzialmente globale. Nonostante le sue dimensioni mastodontiche, il modello non include funzionalità per l’elaborazione di immagini; non è quindi multi modale, per ora è un modello di linguaggio puro.

I test lo vedono competere, e spesso prevalere, su modelli internazionali come Claude Opus 4 e DeepSeek-V3.1 in ambiti come il ragionamento logico, la programmazione e i task multilingue. Le tariffe per l’accesso via API partono da 2,15 dollari per milione di token in input e 8,6 dollari per milione di token in output. Questa strategia di prezzo è pensata per essere competitiva rispetto a soluzioni come GPT-5 o Claude; un rapporto qualità-prezzo attraente per le imprese. L’assenza di una modalità “thinking” indica un design focalizzato sull’efficienza e sulla chiamata di strumenti esterni, ottimizzato per integrazioni in sistemi RAG (Retrieval-Augmented Generation).

La controversia del modello chiuso

L’annuncio di Qwen3-Max-Preview ha suscitato reazioni contrastanti. Da un lato, i professionisti e le aziende ne lodano le capacità tecniche. In particolare, nel campo della programmazione, il modello ha dimostrato di poter competere con i migliori attori del mercato. Dall’altro lato, la decisione di mantenerlo closed-source ha deluso una parte consistente della comunità degli sviluppatori.

L’ironia è che il modello è già integrato in strumenti open source come quelli di Hugging Face. Questo permette di interagire con esso, ma solo a livello superficiale. Non è possibile esaminare l’architettura interna, verificare i dati di addestramento o adattarlo a esigenze specifiche. Questa situazione evidenzia una tensione crescente nel mondo dell’IA: molti attori pubblicano i pesi dei loro modelli, ma pochissimi condividono l’intero stack, compresi codice, dati e licenza aperta.

Sacrificare la trasparenza significa poter generare ricavi diretti e costruire un ecosistema controllato. Alcuni osservatori si chiedono se questo sia un segnale che l’era dell’open source nell’IA di punta stia volgendo al termine.

Reazione degli investitori al nuovo modello di Alibaba

L’impatto di Qwen3-Max-Preview ha avuto conseguenze immediate anche sul piano finanziario. In seguito all’annuncio, le azioni di Alibaba hanno registrato un rialzo sui mercati. Gli investitori hanno interpretato il lancio come un segnale di forza e innovazione da parte dell’azienda cinese.

Dimostrare di poter produrre un modello con oltre un trilione di parametri, capace di competere con i migliori al mondo, rafforza la posizione di Alibaba nel settore dell’IA. Questo rafforzamento è particolarmente importante in un contesto di crescente competizione globale, dove gli Stati Uniti e la Cina si sfidano per la supremazia tecnologica.

Il modello è un asset strategico che Alibaba può utilizzare per attrarre nuovi clienti sulla sua piattaforma cloud. Un’alternativa performante e, potenzialmente, più economica rispetto ai servizi di OpenAI o Anthropic, pronta a conquistare quote di mercato nel settore enterprise. L’approccio “as a service” permette all’azienda di generare flussi di ricavo ricorrenti. La strategia di prezzo aggressiva è un chiaro invito alle aziende a migrare verso l’ecosistema Alibaba.

Qwen3-Max-Preview : il futuro dell’IA secondo Alibaba

Sebbene la preview di Qwen3-Max stia già creando grandi aspettative, Alibaba ha accennato che la prossima release ufficiale avrà prestazioni ancora più elevate. Il prodotto finale potrebbe consolidare ulteriormente la posizione di Qwen nel panorama competitivo dei modelli linguistici di grandi dimensioni.

Alibaba punta a diventare un fornitore indispensabile di servizi di intelligenza artificiale su larga scala, sfruttando la sua infrastruttura cloud per distribuire il suo modello Qwen3 a imprese di tutto il mondo. Questo modello di business privilegia la stabilità e la prevedibilità dei ricavi rispetto alla dinamica, ma imprevedibile, crescita guidata dalla comunità dell’open source.

Per le aziende, questo significa avere a disposizione uno strumento potente e affidabile, con un supporto tecnico garantito. Per gli sviluppatori indipendenti e i ricercatori, significa una riduzione delle libertà. Non potranno più sperimentare liberamente, modificare il codice o costruire derivati senza restrizioni.