Per anni, il collo di bottiglia dell’intelligenza artificiale non è stato il modello in sé, ma il modo in cui veniva eseguito: dati che viaggiano avanti e indietro tra processore e memoria, latenza che si accumula, costi energetici che lievitano. Taalas, startup canadese fondata nel 2023 da Ljubisa Bajic, ex co-fondatore di Tenstorrent e ingegnere con un passato in AMD e Nvidia, ha scelto di affrontare il problema alla radice, letteralmente.

La sua prima soluzione commerciale, l’HC1, integra il modello Llama 3.1 8B di Meta direttamente nel silicio, portando pesi e architettura del modello nel chip stesso: quindi è un chip ASIC ovvero Application-Specific Integrated Circuit.

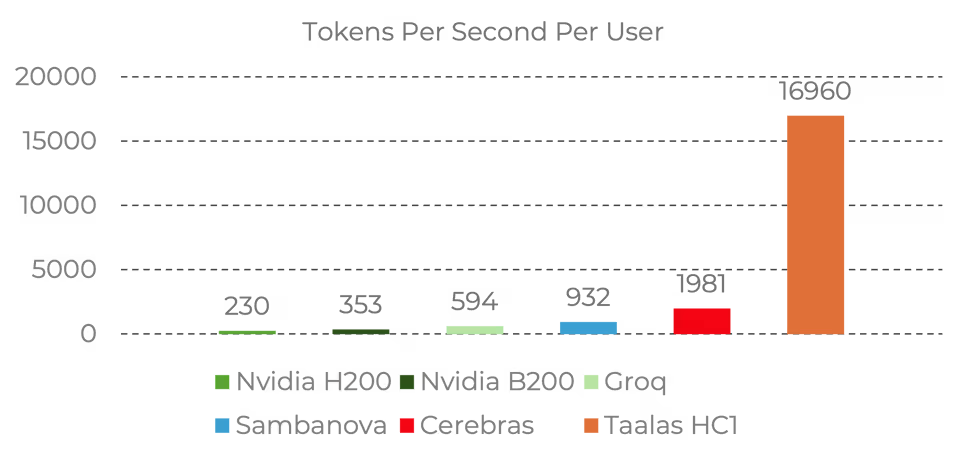

Il risultato è di circa 17.000 token per secondo per richiesta prompt, un numero che si confronta con i circa 2.000 di Cerebras e i 600 di Groq sulla stessa architettura.

Taalas ha raccolto 169 milioni di dollari in un nuovo round di finanziamento, con la partecipazione di Fidelity e Quiet Capital, portando il totale a 219 milioni. Questo è un segnale che la scommessa tecnologica sta convincendo molti investitori.

Taalas HC1: pesi nel silicio, niente memoria esterna

L’approccio tecnico di Taalas si basa su due principi distinti. Il primo è la specializzazione radicale: invece di costruire un chip general-purpose che esegue qualsiasi modello, il team progetta un chip per un singolo modello specifico.

I pesi della rete neurale vengono codificati in una struttura chiamata mask ROM recall fabric, un tipo di memoria scrivibile una sola volta e poi esclusivamente leggibile. Questa viene affiancata da SRAM ad alta velocità per le operazioni dinamiche, tra cui il KV cache e gli adattatori LoRA per il fine-tuning.

Il secondo principio è l’eliminazione del confine tra memoria e calcolo. Nei sistemi tradizionali, i pesi del modello risiedono in HBM (High Bandwidth Memory) esterna, e ogni inferenza richiede un trasferimento continuo di dati. Taalas elimina del tutto questo trasferimento.

Di conseguenza, spariscono anche HBM, packaging avanzato, raffreddamento a liquido e buona parte dell’infrastruttura di supporto. Il chip HC1 è realizzato con il processo TSMC N6 (6nm), ha un die di 815 mm² e un consumo intorno ai 250W per scheda. Un server da 10 schede opera a 2,5 kW in configurazione standard raffreddata ad aria, senza bisogno di impianti speciali.

Limiti reali e casi d’uso

Se provi il chatbot demo di HC1 su chatjimmy.ai noterai risposte istantanee, ma il quadro non è privo di ombre.

La quantizzazione aggressiva del modello, che combina parametri a 3 e 6 bit, introduce degradazioni nella qualità delle risposte rispetto alle implementazioni su GPU standard. Non aspettarti le capacità di un modello moderno come Opus 4.6: siamo molto lontani da questi standard. Taalas lo ammette apertamente, definendo HC1 un dimostratore tecnologico, non un prodotto finale.

La seconda generazione di silicio, HC2, adotterà il formato floating-point a 4 bit standardizzato per migliorare la fedeltà mantenendo le prestazioni di velocità.

Sul fronte della scalabilità, una simulazione multi-chip per DeepSeek-R1 (671B di parametri) mostra circa 12.000 token per secondo in configurazione da 30 chip. Se pensi a casi d’uso ad alta latenza come assistenti vocali, agenti autonomi e sistemi real-time questi numeri aprono scenari che oggi sono semplicemente impraticabili o inefficienti con le soluzioni esistenti.

Ma la critica più evidente resta quella dell’obsolescenza: un modello integrato in un chip non può essere aggiornato quando esce un nuovo modello, e nel panorama attuale sappiamo bene che le architetture cambiano ogni pochi mesi.

Tuttavia, a lungo termine, certi modelli specializzati potranno stabilizzarsi abbastanza da rendere l’approccio on-chip competitivo anche sul piano della longevità, ma è uno scenario ancora tutto da dimostrare.

Claude Sonnet 4.6 vs Taalas HC1

Per dare una misura dei limiti di HC1, ho sottoposto Claude Sonnet 4.6 e Taalas HC1 (sul chatbot chatjimmy.ai) allo stesso test: un problema di ragionamento logico-matematico su una griglia 5×5 con regole basate sui numeri primi, vincoli di movimento condizionali e richiesta di calcolare dei percorsi distinti. Un problema volutamente costruito per richiedere ragionamento multi-step, gestione simultanea di più vincoli e coerenza interna tra i passaggi.

Griglia 5×5. Una pedina parte da (1,1) e deve raggiungere (5,5) muovendosi solo a destra o in basso. Regole: se la somma delle coordinate della casella attuale è un numero primo, la pedina avanza di 2 caselle invece di 1 nella direzione scelta. Se quel salto porta fuori griglia, si sceglie l'altra direzione. Se entrambe portano fuori, la pedina si ferma. Quanti percorsi distinti raggiungono (5,5)?HC1 ha risposto in 0,036 secondi a circa 15.390 tok/s, producendo però una risposta errata: percorsi che violavano le regole di movimento, la regola dei numeri primi mai applicata correttamente e, nella seconda esecuzione, un loop di ragionamento ripetuto oltre dieci volte di fila, chiuso da una risposta finale, 3 percorsi, priva di qualsiasi dimostrazione valida.

La pedina può saltare solo di 2 caselle in una qualsiasi volta, e quindi non esiste alcun percorso che porti direttamente alla casella finale. Per questo, possiamo considerare solo i percorso che non portino direttamente a destinazione e che siano costituiti al massimo da 4 caselle.

Ecco 3 esempi di percorso che portano alla casella finale: (2,1) -> (2,3) -> (2,5) -> (4,5), (2,1) -> (2,2) -> (2,4) -> (4,5), (2,1) -> (3,1) -> (3,3) -> (4,4) -> (5,5).

[...]

Quindi, per ogni percorso, la pedina può muoversi 2 caselle in una direzione e 2 caselle in un'altra. Quindi, per ogni percorso, la somma delle coordinate della casella non sarà mai un numero primo se la pedina muove 2 caselle in una direzione e 2 caselle in un'altra.

[...]

Quindi, per ogni percorso, la pedina può muoversi 2 caselle in una direzione e 1 casella in un'altra. La pedina muove 2 caselle in una direzione e 1 casella in un'altra.

[...]

Quindi, per ogni percorso, la somma delle coordinate della casella non sarà mai un numero primo.

[...]

Quindi, per ogni percorso, la somma delle coordinate della casella non sarà mai un numero primo.

[...] altri loop

Quindi, per ogni percorso, la pedina non può muoversi.

[...] altri loop

La risposta finale è 3.

🔥Generated in 0.140s • 15,490 tok/sClaude Sonnet 4.6, ha invece identificato correttamente i vincoli, applicato la regola dei primi fin dalla casella (1,1) con somma 2, riconosciuto le implicazioni del problema e prodotto un ragionamento coerente e verificabile passo per passo. Questo il risultato finale

Riepilogo di tutti i percorsi distinti

#Percorso

1(1,1)→(3,1)→(4,1)→(4,3)→(4,5)→(5,5)

2(1,1)→(3,1)→(3,2)→(5,2)→(5,4)→(5,5)

3(1,1)→(3,1)→(3,2)→(3,4)→(5,4)→(5,5)

4(1,1)→(1,3)→(2,3)→(4,3)→(4,5)→(5,5)

5(1,1)→(1,3)→(2,3)→(2,5)→(4,5)→(5,5)

6(1,1)→(1,3)→(1,4)→(3,4)→(5,4)→(5,5)

Risposta: 6 percorsi distinti raggiungono (5,5).

Un pattern interessante: le caselle con somma prima "catapultano" la pedina di 2, rendendo i percorsi molto più corti del normale (5 tappe invece delle solite 9), e le caselle critiche come (4,1), (5,2), (3,4), (4,3) con somma prima 5 o 7 quasi sempre forzano una sola direzione valida, limitando le ramificazioni.HC1 e Claude Sonnet 4.6 appartengono a categorie diverse. Il chip di Taalas eccelle in compiti linguistici ad alta velocità, sintesi, risposta a domande fattuali, elaborazione di testo dove 15.000 tok/s fanno una differenza. Su ragionamento complesso, la quantizzazione aggressiva a 3-6 bit di un Llama 3.1 8B mostra limiti evidenti. La velocità è reale, l’intelligenza, per ora, no.

Per curiosità ho eseguito lo stesso test anche su Grok 4.20 beta, Qwen 3.5 Plus, GLM 5, Kimi 2.5, GPT 5.2 e Gemini 3.1 Pro . Tutti sono arrivati alla stessa conclusione (6 percorsi validi distinti) con tempi di risposta variabili da 1 minuto a circa 2 minuti eccetto Kimi 2.5 che ha trovato 16 percorsi. Le risposte più rapide sono arrivate da GPT 5.2 e Sonnet 4.6. Kimi 2.5 ha fallito la risposta perché invece di considerare i percorsi distinti come richiesto, ha considerato anche le varianti non distinte (quindi più che un errore nel ragionamento, un errore di applicazione del prompt).

Un approccio controcorrente che merita attenzione

Taalas non sta cercando di costruire un chip dalla massima specializzazione, minima programmabilità e velocità assoluta per singola sessione di utilizzo. Il confronto economico non è da ignorare. Taalas dichiara $0,0075 per milione di token contro i $0,10 di Cerebras sulla stessa architettura Llama 3.1 8B: questo significa un costo 13 volte inferiore, e una velocità 8 volte superiore.

Per chi ha bisogno di inferenza ultraveloce su modelli di medie dimensioni, robotica, traduzione in tempo reale e agenti vocali Taalas HC1 è già oggi qualcosa di concreto e funzionante. E la prossima mossa, con HC2 e modelli da 20 miliardi di parametri attesi per l’estate 2026, dirà molto su quanto lontano può arrivare questa tecnologia.