Qualcomm ha fatto un’entrata decisa nel competitivo mercato dei chip per data center AI, annunciando due nuovi processori che potrebbero rimescolare le carte in un settore dominato da Nvidia e in minima parte da AMD. L’azienda californiana, storicamente focalizzata su processori per dispositivi mobili, ha svelato i chip AI200 e AI250; sono progettati specificamente per l’inferenza di modelli di intelligenza artificiale su larga scala.

Questa mossa segna una significativa espansione strategica del portfolio Qualcomm, che mira a capitalizzare sulla crescente domanda di infrastrutture AI. I nuovi chip, basati sulla tecnologia di elaborazione neurale mobile Hexagon già utilizzata nei processori per smartphone e laptop, promettono di offrire un’alternativa competitiva alle soluzioni esistenti. La capacità di memoria dichiarata è di 768 GB per scheda; un valore che supera di gran lunga le offerte tradizionali di Nvidia e AMD.

Il primo cliente annunciato è Humain; una startup AI sotto il Fondo Pubblico di Investimento dell’Arabia Saudita, che utilizzerà questi chip per alimentare sistemi di computing. Questa partnership strategica in Medio Oriente potrebbe aprire nuove opportunità in un mercato in rapida espansione; un mercato dove la necessità di infrastrutture AI efficienti sta crescendo esponenzialmente.

L’annuncio dei nuovi chip ha provocato una reazione immediata e positiva sui mercati finanziari. Le azioni Qualcomm sono salite quasi del 20%, toccando un massimo di 52 settimane a $182.23; il più grande guadagno da aprile 2019. Questo rally evidenzia quanto gli investitori vedano potenziale nella strategia di diversificazione dell’azienda oltre il mercato degli smartphone.

Architettura dei nuovi Chip AI di Qualcomm

L’AI200, previsto per il lancio nel 2026, si distingue per i suoi 768GB di RAM per scheda acceleratrice; una capacità superiore rispetto alle offerte attuali di Nvidia e AMD. Questa notevole quantità di memoria permette di gestire modelli linguistici di grandi dimensioni e modelli multimodali con maggiore efficienza.

L’AI250, previsto per il 2027, spinge questo concetto ancora oltre. Introdurrà un’architettura innovativa basata sul near-memory computing; promette di moltiplicare per oltre 10 volte l’effettiva ampiezza di banda della memoria, riducendo al contempo il consumo energetico. Questa architettura permetterà l’inferenza “disaggregata”, offrendo ai datacenter una flessibilità senza precedenti nell’allocare le risorse di calcolo.

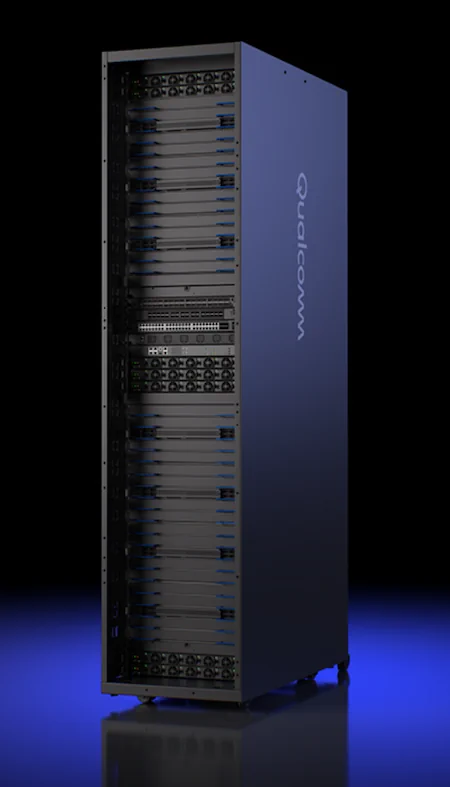

Entrambi i chip sono supportati da uno stack software hyperscaler-grade che offre facile distribuzione, compatibilità con i principali framework AI e strumenti per generative AI sicure e scalabili. L’architettura rack-scale permette fino a 72 chip di funzionare come un singolo computer; un approccio simile alle soluzioni di Nvidia e AMD, ma con promesse di costi di proprietà totali inferiori.

Sistemi pensati per l’inferenza

I chip Qualcomm AI200 e AI250 non monteranno costose memorie HBM4e bensì semplici memorie LPDDR. Anche per questo motivo i chip Qualcomm sono ottimizzati specificamente per l’inferenza su larga scala; non per l’addestramento, differenziandosi così dalle soluzioni concorrenti di Nvidia e AMD.

L’inferenza è il processo di utilizzo di un modello AI già addestrato per fare previsioni o generare contenuti; è ciò che alimenta ogni chatbot, sistemi di API e ogni applicazione di AI generativa che usiamo quotidianamente. Questo processo richiede un’architettura ottimizzata per la latenza minima e il massimo throughput con il minor consumo energetico possibile.

Le soluzioni rack di Qualcomm sono inoltre pensate per la scalabilità, utilizzando PCIe per lo scale-up (all’interno del rack) ed Ethernet per lo scale-out (tra rack); con un consumo energetico a livello di rack di 160 kW e raffreddamento a liquido diretto. È un approccio ingegneristico che riflette una profonda comprensione dei colli di bottiglia attuali nell’inferenza AI.

La strategia di Qualcomm nel settore AI

Con il lancio di questi nuovi chip, Qualcomm sfida direttamente il dominio di Nvidia, che attualmente controlla oltre il 90% del mercato degli acceleratori AI. La strategia di Qualcomm si concentra su punti deboli specifici delle soluzioni esistenti; consumo energetico e costi di proprietà e gestione della memoria per l’inferenza.

Invece di competere direttamente nell’addestramento dei modelli, dove Nvidia ha consolidato la sua leadership, Qualcomm punta sull’inferenza; un segmento del mercato in rapida crescita che richiede caratteristiche diverse. L’azienda californiana sfrutta la sua esperienza decennale nei processori mobile; processori dove l’efficienza energetica è sempre stata un fattore critico, per offrire soluzioni più sostenibili per i data center.

Durga Malladi, Senior Vice President e General Manager di Qualcomm, ha dichiarato che questi nuovi chip “ridefiniscono ciò che è possibile per l’inferenza AI a livello di rack“, abilitando la generative AI con costi di proprietà senza precedenti mantenendo la flessibilità e la sicurezza richieste dai moderni data center. Questa posizione mirata potrebbe permettere a Qualcomm di conquistare quote di mercato significative senza affrontare Nvidia nel suo territorio di maggiore forza.

Prospettive future per Qualcomm

La strategia di Qualcomm è quella di attaccare il mercato AI dove è più vulnerabile e dove i costi operativi iniziano a pesare in modo insostenibile. Mentre Nvidia ha costruito un impero sulle GPU ottimizzate per il training, un’operazione computazionalmente brutale ma relativamente sporadica (creazione di un nuovo modello), Qualcomm punta tutto sull’inferenza.

Il CEO Cristiano Amon ha paragonato l’attuale boom dell’AI ai primi giorni di internet; ha affermato che è ancora presto per dichiarare vincitori chiari e che “l’opportunità è probabilmente più grande di quanto si pensi“. Con la spesa globale per i data center AI proiettata per raggiungere circa $6.7 trilioni entro il 2030, il mercato offre ampi spazi per nuovi concorrenti.

Qualcomm ha già annunciato che un terzo chip e server sono previsti per il 2028, indicando un impegno a lungo termine in questo settore. L’approccio dell’azienda, basato sull’efficienza energetica e sull’ottimizzazione per l’inferenza piuttosto che per l’addestramento, potrebbe rivelarsi particolarmente attraente per le aziende preoccupate dai costi operativi crescenti dei data center. Con la sua esperienza nel mobile e le nuove competenze acquisite con Alphawave, Qualcomm è ben posizionata per diventare un concorrente serio in questo mercato in rapida espansione.