La francese Mistral AI torna sotto i riflettori con un annuncio che punta dritto al cuore degli sviluppatori. A pochi giorni dalla presentazione della famiglia di modelli Mistral 3, pensata per l’edge computing e l’hardware locale, Mistral AI svela Devstral 2. Si tratta di una nuova coppia di modelli linguistici specializzati nelle attività di programmazione, affiancata da Mistral Vibe; un assistente a riga di comando che automata il flusso di lavoro nello sviluppo software.

L’annuncio arriva in un momento di grande fermento nel settore dei modelli di codice, dominato da OpenAI, Anthropic, xAI con Grok 4.1, Google con Gemini Pro 3 e il suo nuovo IDE Antigravity; senza dimenticare anche da progetti open-source di provenienza cinese come Deepseek 3.2, Qwen-3 Max e altri. Mistral sembra voler giocare una partita diversa; punta non solo sulle performance grezze ma su un’offerta differenziata che mette al centro l’esperienza dello sviluppatore e la flessibilità di utilizzo. Due varianti con licenze diverse e uno strumento CLI nativo e open-source; un percorso scalabile, dalla sperimentazione individuale fino alle implementazioni enterprise.

Per gli sviluppatori che hanno un budget ridotto c’è anche l’occasione di mettere alla prova il modello Devstral 2 in modo completamente gratuito (per un tempo limitato). Questa opportunità si aggiunge a quella offerta sempre in questo periodo anche da Google con Antigravity; la nuova IDE include tra gli altri, i modelli Gemini 3 Pro e Claude Opus 4.5 in uso gratuito (per un tempo limitato e con limiti d’uso orari).

Caratteristiche tecniche e benchmark: efficienza che sfida i giganti

La famiglia Devstral 2 si compone di due modelli distinti per dimensioni e destinazione d’uso. Il modello capofila, Devstral 2, è un transformer denso da 123 miliardi di parametri (solo su cloud/API) con un contesto di 256.000 token. I risultati sul benchmark SWE-bench Verified, che valuta la capacità di risolvere problemi reali estratti da repository GitHub, parlano di un 72.2% di successo.

La versione più compatta, Devstral Small 2, mantiene la stessa finestra contestuale ma con soli 24 miliardi di parametri; raggiunge comunque un rispettabile 68.0% sullo stesso test. Devstral Small 2 può essere tranquillamente eseguito in locale con computer; occorre una buona GPU e una larga dotazione di RAM (almeno 64 GB).

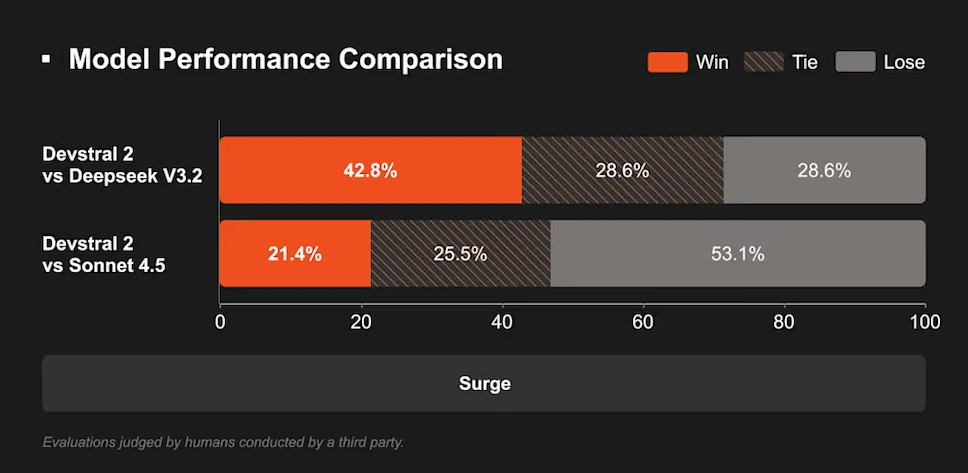

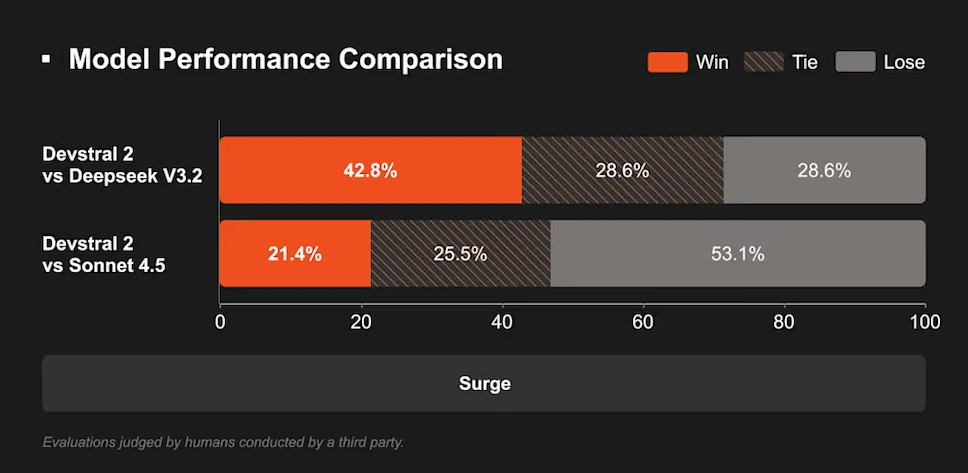

Paragonato con altri modelli AI open source, Devstral 2 è cinque volte più piccolo di DeepSeek V3.2 (671B) e otto volte più piccolo di Kimi K2 (1000B); ne eguaglia o ne supera le prestazioni in compiti specifici di coding. Devstral 2 vince nel 42.8% dei casi contro DeepSeek V3.2. Il confronto con il modello chiuso Claude Sonnet 4.5 vede invece una preferenza per il modello di Anthropic nel 53.1% dei casi. Questi risultati collocano i modelli di Mistral in cima alla classifica degli strumenti open-weight per il coding.

Licenze e distribuzione: due modelli, due filosofie d’uso

Devstral Small 2 viene rilasciato sotto la licenza Apache 2.0; uno standard permissivo e ampiamente accettato nell’open-source che consente l’uso commerciale, la modifica e la redistribuzione senza restrizioni. Questo rende il modello immediatamente utilizzabile da aziende di ogni dimensione, sviluppatori indipendenti e progetti open-source; anche in ambienti on-premise o completamente offline.

La situazione è diversa per il modello più grande. Devstral 2 utilizza una licenza MIT modificata che introduce una clausola cruciale; qualsiasi azienda con un fatturato mensile consolidato superiore ai 20 milioni di dollari non può utilizzare il modello senza una licenza commerciale separata. Questa limitazione si estende anche a derivati e versioni fine-tuned. In pratica, il modello è aperto per la comunità e le piccole imprese; le grandi organizzazioni devono necessariamente negoziare con Mistral o utilizzare l’API a consumo.

Dopo un periodo iniziale gratuito, l’API sarà a pagamento con prezzi competitivi; 0.15$ per milione di token in input e 0.60$ in output per Devstral 2. Un prezzo API simile a quello offerto da DeepSeek 3.2 ($0,26/M input tokens e $0,39/M output tokens).

Mistral Vibe CLI: l’intelligenza direttamente nel terminale

Mistral ha presentato anche Mistral Vibe CLI; è un agente a riga di comando open-source (licenza Apache 2.0) progettato per sfruttare appieno le capacità di Devstral. Non si tratta di un semplice plugin per IDE; è uno strumento nativo che opera direttamente nel terminale, integrato nel flusso di lavoro dello sviluppatore attraverso il protocollo Agent Communication Protocol (ACP).

Vibe CLI va oltre la semplice generazione di codice; analizza la struttura del progetto, monitora lo stato di Git, orchestra modifiche su più file e comprende le dipendenze architetturali. L’interfaccia interattiva supporta comandi naturali, il riferimento a file con la sintassi @, l’esecuzione di comandi shell con ! e comandi di configurazione con /.

Queste funzionalità mirano a ridurre drasticamente i tempi del ciclo di sviluppo; automatizzano attività complesse come il refactoring di codice legacy o la risoluzione di bug che coinvolgono più componenti. Per garantire un’immediata adozione, Mistral ha stretto partnership con piattaforme di coding agentico già affermate come Kilo Code e Cline; inoltre ha reso disponibile Vibe come estensione per l’editor Zed. Un’esperienza coerente e potente, indipendentemente dall’ambiente di sviluppo preferito, ponendo l’accento sulla produttività e sull’automazione end-to-end.

Vibe CLI non è una novità per il settore; anche Google, Anthropic e OpenAI hanno già presentato da tempo i loro Agenti CLI (Command Line Interface). Claude Code è un tool da terminale che ti permette di “chattare” con il tuo progetto. Codex CLI è lo strumento CLI di OpenAI che permette di usare i modelli (come GPT-5.1) direttamente nel terminale con capacità di agire sui file. Infine Google fornisce Gemini Code Assist CLI.

L’evoluzione di Mistral nel mercato dei modelli per sviluppatori

Con Devstral 2 e Vibe CLI, Mistral AI completa una strategia iniziata oltre un anno fa con il lancio di Codestral, il suo primo modello focalizzato sul codice. Questo percorso mostra una crescente sofisticazione; da strumenti per la generazione di codice fino a modelli agentici in grado di ragionare su interi codebase.

L’approccio local-first e l’enfasi sull’open-source, già evidenti in Mistral 3, trovano qui una loro piena espressione. La reazione della comunità degli sviluppatori, specialmente su piattaforme come Reddit, è per lo più positiva, con molti che vedono in Devstral Small 2 il nuovo re per il coding in locale. In un mercato sempre più polarizzato tra API proprietarie e modelli open-source di difficile gestione, Mistral propone una terza via; strumenti potenti, integrati e pragmatici, che lasciano agli sviluppatori il controllo sul dove e come implementarli.