Xiaomi ha momentaneamente allegerito il focus su smartphone e dispositivi smart per lanciarsi in un territorio completamente diverso: l’intelligenza artificiale generativa. Il MiMo-V2-Flash rappresenta il primo tentativo serio del colosso cinese di competere con i grandi nomi del settore, da OpenAI ad Anthropic. Il modello, rilasciato ieri 16 dicembre 2025, vanta 309 miliardi di parametri totali con solo 15 miliardi attivi, seguendo un’architettura Mixture-of-Experts (MoE) che promette efficienza computazionale.

L’azienda non si accontenta di presentare un modello competitivo, ma punta direttamente ai leader di mercato; i benchmark interni mostrano prestazioni paragonabili a GPT-5 High, Claude Sonnet 4.5 e Gemini 3 Pro in diverse categorie. Resta da verificare quanto questi risultati reggano ai test reali.

Ma ci sono altre notizie importanti. È completamente open-source con licenza MIT, quindi chiunque può scaricarlo, modificarlo e utilizzarlo liberamente. Xiaomi offre anche accessi API gratuiti per un periodo limitato, al termine delle quali saranno applicate tariffe drasticamente inferiori alla concorrenza. Addirittura inferiori ai prezzi di DeepSeek : 0,10$ per milione di token in ingresso contro gli 0,28$ di DeepSeek.

Senza mezzi termini, Fuli Luo un ex ingegnere di DeepSeek e ora al lavoro con il team di XiaomiMiMo, ha affermato che MiMo-V2-Flash è solo 2 step dietro nella loro AGI roadmap.

MiMo-V2-Flash : architettura ibrida con velocità e contesto esteso

Xiaomi non si è limitata a riprodurre l’architettura di un modello esistente. Il cuore di MiMo-V2-Flash è la sua attenzione ibrida; combina strati di sliding window attention (SWA) con una finestra di 128 token e strati di attenzione globale in un rapporto 5:1, organizzati in 8 blocchi ibridi. Praticamente, cinque layer utilizzano una finestra mobile di soli 128 token, seguiti da uno strato di attenzione globale. La SWA riduce drasticamente la memoria KV necessaria, quasi sei volte in meno rispetto alle architetture tradizionali. Rende il calcolo lineare rispetto alla lunghezza del contesto; accelera la fase di prefill e permette di gestire fino a 256k token.

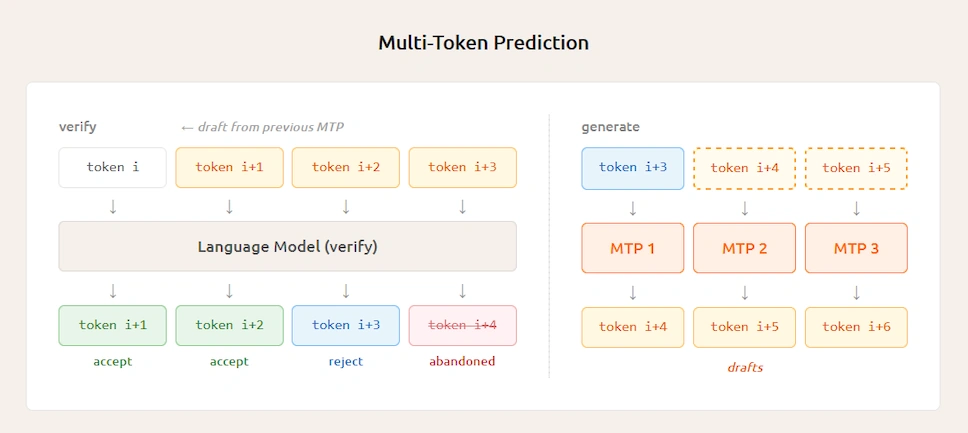

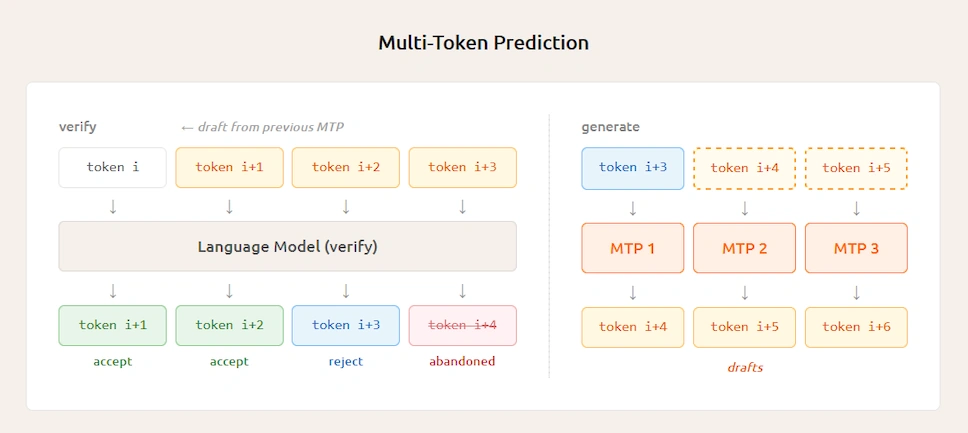

La seconda innovazione è la Multi-Token Prediction (MTP), implementata con un modulo denso leggero (0,33 miliardi di parametri per blocco) che opera con SWA invece che con attenzione globale. MTP predice più token in parallelo, triplicando di fatto la velocità di generazione durante l’inferenza e fungendo da self-speculative decoding.

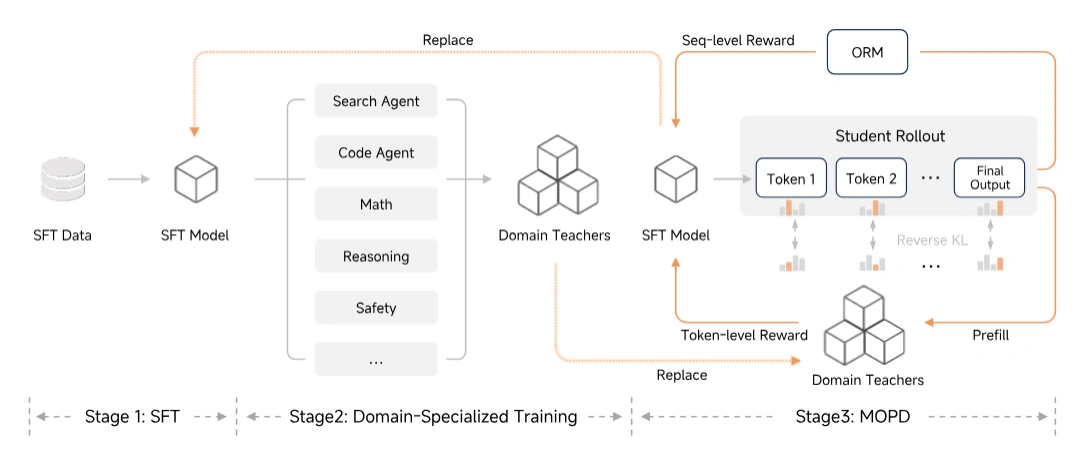

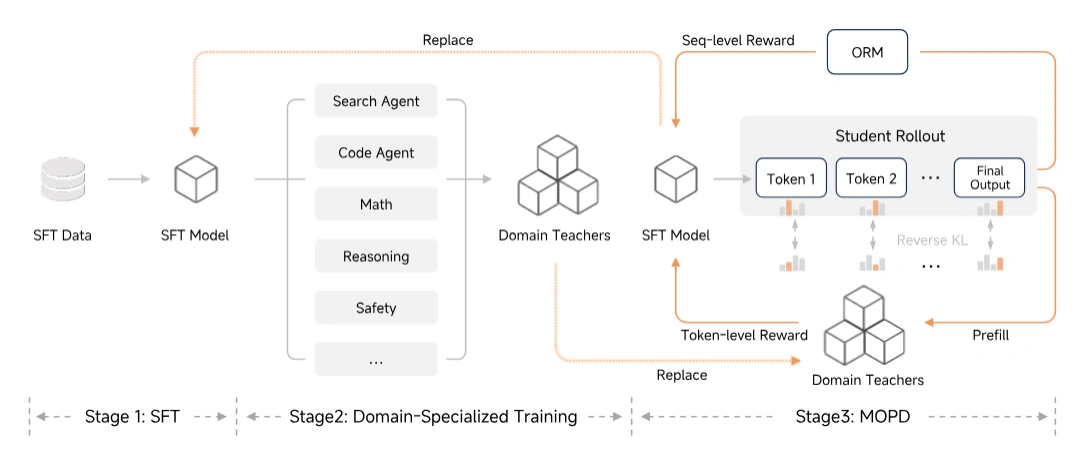

Il processo di post-training si avvale del Multi-Teacher On-Policy Distillation (MOPD). Questa tecnica addestra insegnanti specializzati in diversi domini (matematica, codice, sicurezza, ecc.) e li distilla in un unico studente tramite reinforcement learning on-policy; utilizza ricompense basate sulla divergenza KL a livello di token. MOPD elimina il tipico see-saw effect (migliorare una capacità a scapito di un’altra) e richiede solo 1/50 del calcolo necessario per addestrare specialisti separati. Il modello è stato addestrato su 27 trilioni di token utilizzando precisione mista FP8.

Benchmark impressionanti, ma con alcune riserve

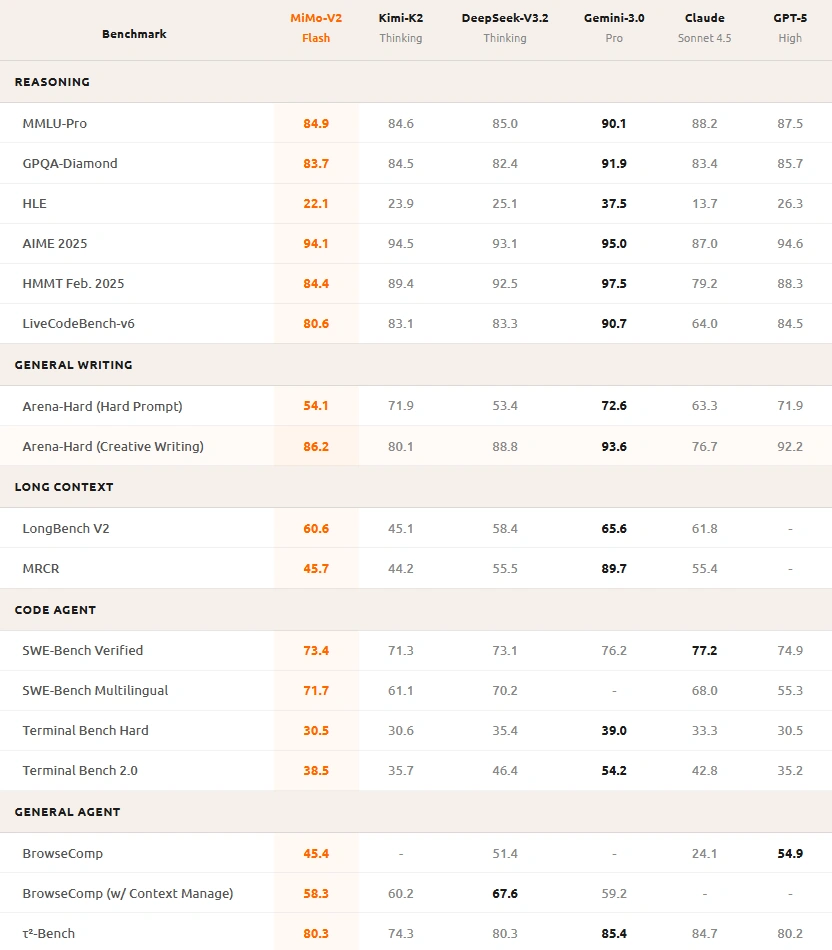

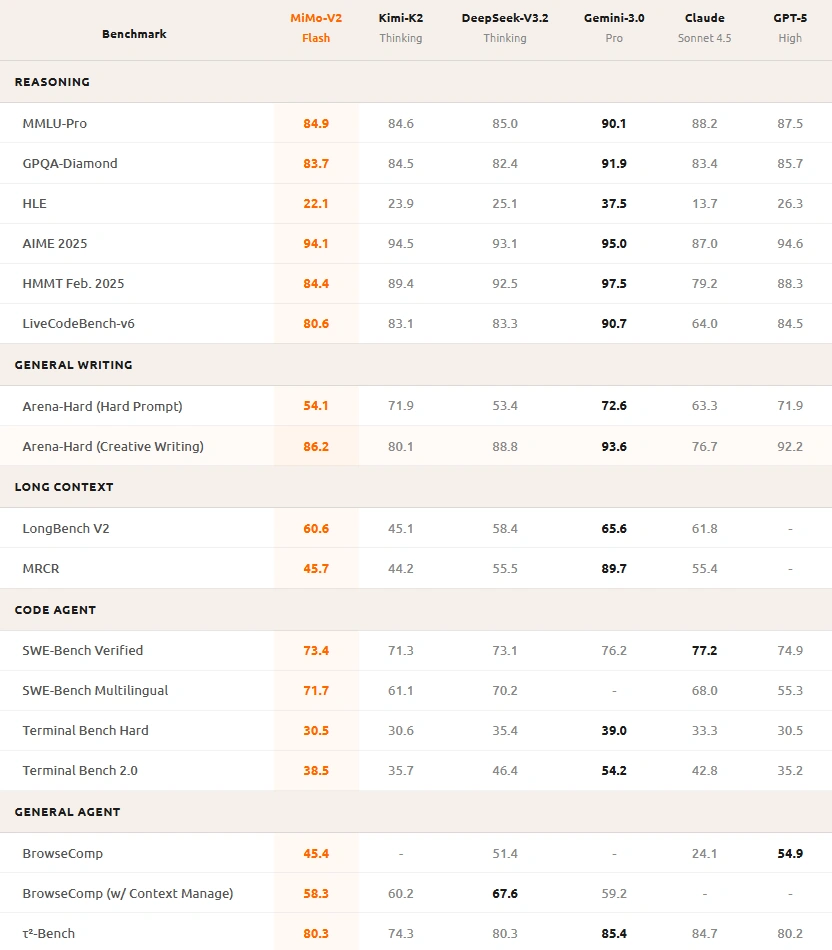

I numeri presentati da Xiaomi mostrano prestazioni che competono con i modelli più avanzati. Nei test AIME 2025 per matematica avanzata, MiMo-V2-Flash ottiene 94,1 punti, vicinissimo a GPT-5 High (94,6) e superiore a DeepSeek-V3.2 (93,1). Nel coding, su SWE-Bench Verified, raggiunge il 73,4%, posizionandosi al vertice tra i modelli open-source e avvicinandosi a Claude Sonnet 4.5 (77,2%).

Anche nei test di conoscenza generale come MMLU-Pro, con 84,9 punti, si colloca nell’élite. Gemini 3.0 Pro resta superiore come all-rounder, mentre nelle prove di scrittura creativa e contenuti immaginativi MiMo-V2-Flash mostra debolezze rispetto ai concorrenti. I benchmark dell’azienda indicano prestazioni inferiori in Arena-Hard Creative Writing (86,2 contro 93,6 di Gemini).

La community dovrà validare questi risultati attraverso test indipendenti; i benchmark aziendali tendono a favorire le proprie soluzioni.

MiMo-V2-Flash: un contendente serio con margini di miglioramento

Xiaomi, azienda rinomata nel settore consumer electronics, ha compiuto un deciso ingresso nel campo dell’intelligenza artificiale con il lancio di MiMo-V2-Flash, un modello linguistico di grandi dimensioni disponibile in open source.

MiMo-V2-Flash si presenta come alternativa concreta ai modelli proprietari dominanti, specialmente considerando disponibilità open-source e costi ridotti. L’architettura ibrida con SWA e MTP dimostra che esistono vie alternative per ottimizzare efficienza senza sacrificare eccessivamente le prestazioni. La compatibilità diretta con strumenti diffusi come Claude Code, Cursor e Cline facilita l’adozione immediata da parte degli sviluppatori; basta modificare l’endpoint API per iniziare. Xiaomi ha annunciato anche una chat conversionale (ma al momento non è ancora attiva) e una robusta piattaforma API.

L’API è compatibile con strumenti popolari come Claude Code, Cursor, Cline e Kilo Code, richiedendo solo la modifica dell’endpoint. In alternativa, è disponibile MiMo Studio. MiMo-V2-Flash è già disponibile anche su Openrouter e Huggingface.

Xiaomi ha scelto bene il momento; il mercato cerca alternative economiche ai modelli costosi, e l’approccio open-source guadagna consensi crescenti. Se la community confermerà i benchmark e contribuirà con miglioramenti, Xiaomi potrebbe davvero ritagliarsi uno spazio significativo. Per ora, merita attenzione e sperimentazione. Si preannunciano tempi difficili per i leader di mercato.