Google ha presentato una nuova capacità di Gemini 2.5 incentrata sulla comprensione visuale: la segmentazione conversazionale delle immagini. La sua nuova funzione consente di identificare parti di un’immagine basandosi su richieste formulate in linguaggio naturale.

Nessun menu a tendina, nessun bounding box predefinito: solo parole. Il cuore di questa novità è la capacità di interpretare relazioni spaziali, attributi comparativi, logiche condizionali e concetti astratti senza mai perdere il filo del discorso.

Non si tratta più solo di dire “mostrami la mela rossa”, ma di porre domande come “qual è l’auto più lontana nella foto?”. Il sistema risponde in modo visivo e preciso, grazie a un’integrazione sofisticata tra modelli visivi e comprensione linguistica. Gemini non interpreta solo forme o colori; decifra relazioni, condizioni, concetti astratti e persino elementi testuali presenti nell’immagine. In altre parole, inizia a “vedere” e “comprendere” come un essere umano quando cerca un dettaglio specifico in una scena.

Per chi lavora con fotografia, sicurezza, realtà aumentata, turismo, automotive e altro l’impatto è immediato: le barriere tra linguaggio e visione scompaiono.

Tipologie di richieste gestite da Gemini 2.5 nella segmentazione

Gemini 2.5 è stato progettato per interpretare cinque categorie principali di richieste visive.

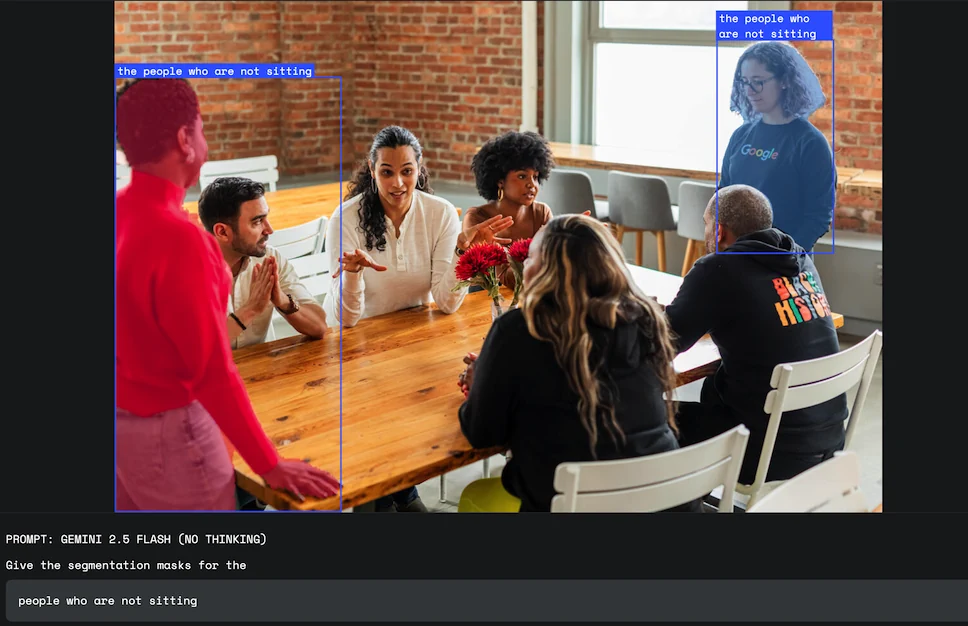

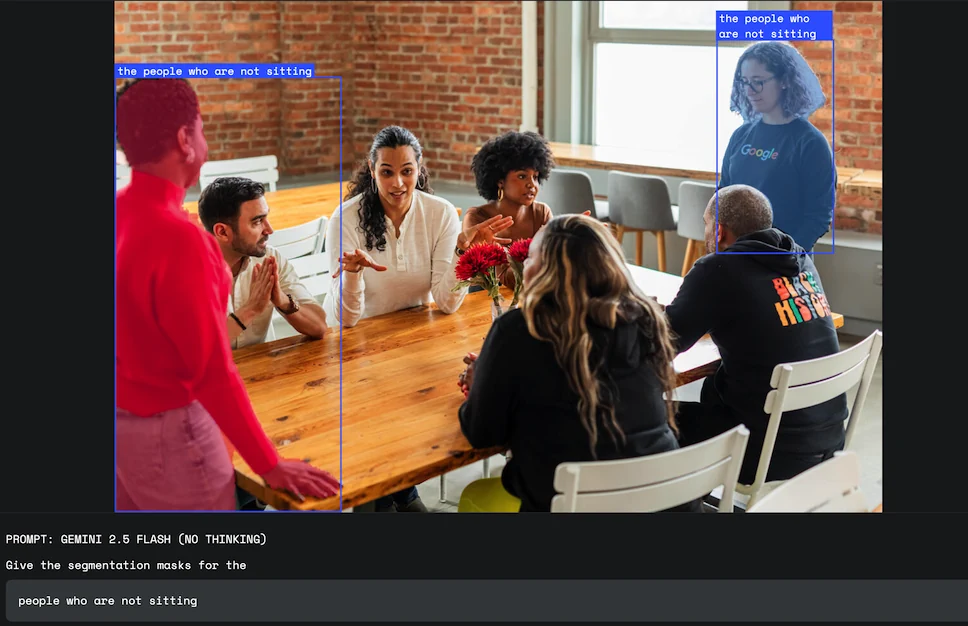

La prima riguarda le relazioni tra oggetti. Non è più necessario specificare una categoria: basta chiedere “la persona che tiene l’ombrello” o “il terzo libro da sinistra”. La seconda tipologia prevede logiche condizionali, come “il cibo vegetariano” oppure “le persone che non sono sedute”. In entrambi i casi, la comprensione logica e semantica riesce a restituire una maschera coerente.

La terza categoria riguarda i concetti astratti. Gemini riesce a identificare concetti astratti come “rotto”, “disordine” o “opportunità”. La quarta categoria riguarda la lettura di testi all’interno dell’immagine; l’IA riesce a distinguere oggetti identici tra loro grazie a etichette scritte, sfruttando funzioni OCR interne. Infine, il sistema è in grado di elaborare etichette multilingue, estendendo l’interazione a contesti non anglofoni.

Come funziona la segmentazione visiva di Google Gemini 2.5

Sotto il cofano, Gemini 2.5 mescola vision-language modeling e mask decoding in un’unica pipeline. Il processo parte da una query in linguaggio naturale; il modello la trasforma in vettori semantici, li confronta con le feature spaziali dell’immagine e produce una maschera binaria per ogni entità richiesta.

Google consiglia tre accorgimenti: scegliere il modello gemini-2.5-flash, disabilitare il thinkingBudget (impostandolo a zero) e richiedere l’output in formato JSON. Il JSON restituisce, per ogni oggetto, la bounding box 2D, la maschera vera e propria e un label descrittivo. Un esempio di prompt è: “Segmenta le persone sedute su una panchina rossa che non indossano il casco”. Il sistema interpreta la negazione, il colore della panchina e la postura seduta, restituendo solo le maschere pertinenti. La latenza media è di 280 ms a 1024×768 pixel su GPU TPU v5p; per immagini 4K si sale a 650 ms, ancora nel range reale per applicazioni interattive.

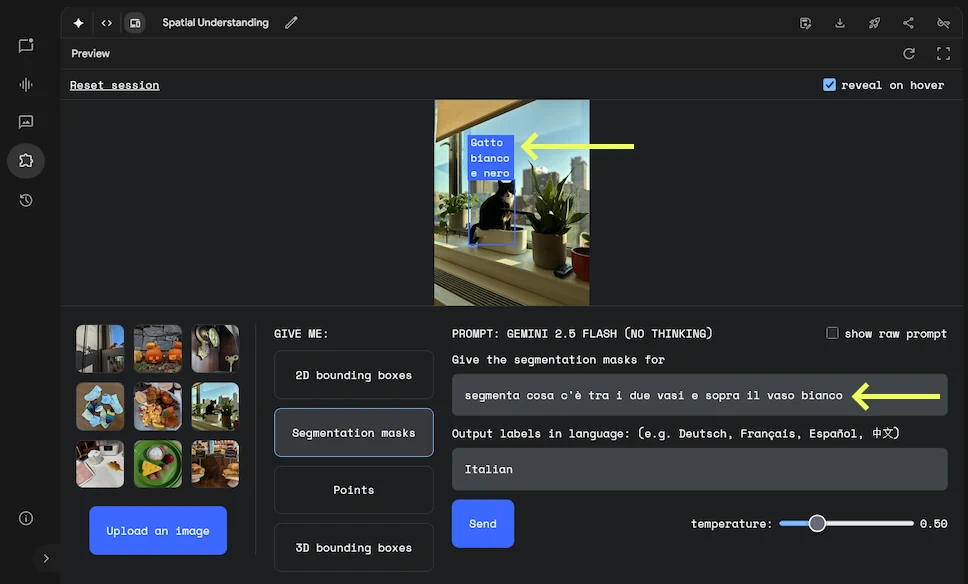

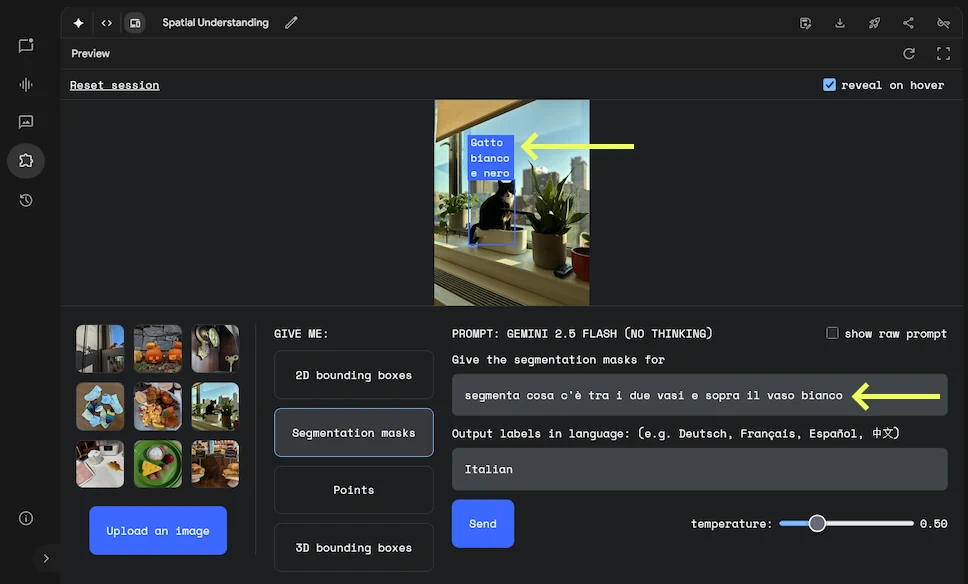

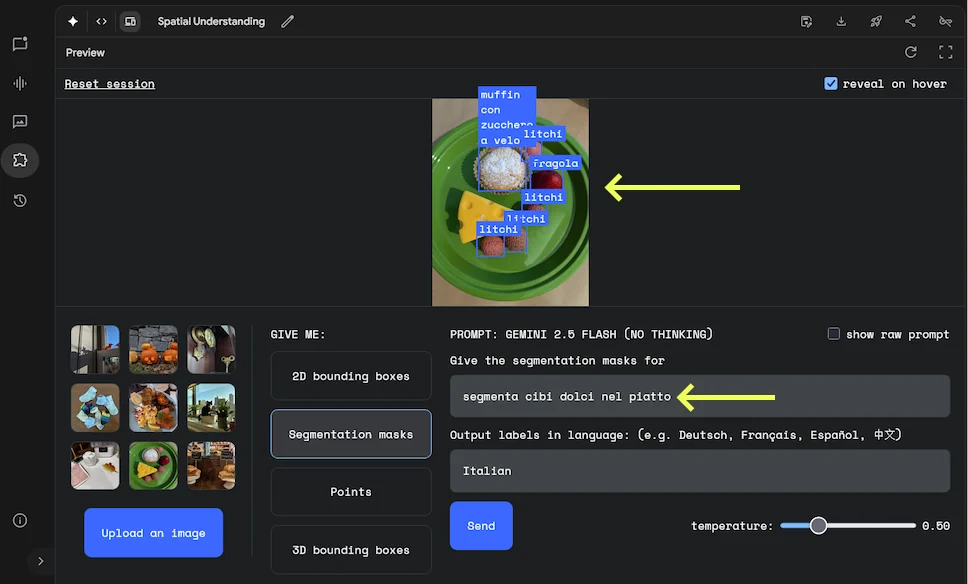

La segmentazione visiva di Google Gemini 2.5 è già disponibile in prova gratuita sulla piattaforma AI Studio. Abbiamo eseguito alcuni test (sotto), è non possiamo che confermare le capacità sorprendenti di segmentazione immagini di Gemini 2.5

Nell’esempio sopra, Gemini 2.5 ha identificato correttamente il gatto bianco e nero che si trova tra i due vasi e sopra il vaso bianco.

In questo caso (immagine sopra) Gemini 2.5 ha identificato i dolci contenuti nel piatto.

Applicazioni reali

Questa nuova forma di interazione visiva ha il potenziale per modificare profondamente le modalità operative in diversi settori. Nei flussi di lavoro creativi, un grafico può chiedere direttamente al sistema “seleziona l’ombra proiettata dall’edificio”, evitando strumenti macchinosi. La precisione del risultato e la velocità dell’interazione permettono di lavorare con precisione e in minor tempo.

Nel campo della sicurezza industriale, il sistema è capace di isolare situazioni a rischio con comandi come “evidenzia le persone che non indossano il casco nel cantiere”. Questo tipo di segmentazione automatica può essere integrato in sistemi di monitoraggio real-time, migliorando l’efficienza dei controlli.

Nel settore assicurativo, invece, Gemini può riconoscere “danni” su abitazioni o veicoli. Le ammaccature da grandine, le crepe o le deformazioni vengono identificate tramite descrizioni linguistiche. Il sistema sfrutta la conoscenza del mondo e una forma di ragionamento visivo distribuito per distinguere tra imperfezioni naturali e veri danni strutturali.

Nel settore automotive, le auto a guida autonoma possono beneficiare di una segmentazione in tempo reale basata su comandi inviati dalla AI. Gemini elabora l’immagine e restituisce maschere precise che possono migliorare la sicurezza, l’interpretazione delle priorità stradali e la gestione predittiva delle traiettorie.

Oltre il visibile: nuove prospettive per il linguaggio visivo

Gemini 2.5 estende il linguaggio visivo a nuove modalità d’uso. L’interazione tramite frasi permette di usare le immagini in contesti dove precisione e velocità diventano essenziali. Che si tratti di un assistente per la guida autonoma o di un editor per campagne pubblicitarie, la segmentazione delle immagini riduce il margine di errore e aumenta l’operatività.

Nei prossimi mesi Google intende rilasciare maschere a livello semantico (ogni pixel etichettato con classe e istanza) e supporto video a 30 fps. L’azienda sta anche testando l’edge deployment su smartphone Pixel grazie a una variante ottimizzata che mantiene l’88% della precisione. Le SDK per Unity e Unreal Engine sono già in closed beta, mentre il team di Firebase prepara un micro-servizio serverless che scala automaticamente in base al carico.

Ciò che fino a ieri richiedeva interfacce complesse, training specialistico o strumenti terzi, oggi viene ridotto a un’interazione con una frase in parole naturali.

Sul fronte enterprise, Workspace si arricchirà di un nuovo componente: potrai cliccare su un’immagine in Documenti e chiedere per esempio di “Evidenzia tutte le firme mancanti”. Infine, Google sta lavorando con partner OEM per portare la segmentazione conversazionale direttamente nelle telecamere di sorveglianza. Il linguaggio naturale diventerà l’interfaccia per permettere ai dispositivi di vedere e comprendere il mondo.