DeepSeek-OCR presentato oggi da DeepSeek non è l’ennesimo wrapper su un modello OCR esistente; è un tentativo di ridefinire il rapporto tra visione e linguaggio nei sistemi multimodali. Si perchè DeepSeek-OCR non è pensato per produrre un testo pulito da leggere con gli occhi di un umano, ma per comprimere un documento (testo e immagine) in pochi token visivi che un Large Language Model (LLM) possa capire e usare direttamente nel suo ragionamento.

Il cuore del progetto è in una domanda; quanto testo (o immagine) si può comprimere in pochi token visivi senza che il modello perda la fedeltà semantica ? La risposta arriva da un’architettura ibrida composta da DeepEncoder e DeepSeek3B-MoE-A570M. Il primo gestisce l’input visivo ad alta risoluzione con un’attenzione all’efficienza computazionale e lo riassume (comprime); mentre il secondo è un decoder che interpreta il risultato in un contesto linguistico (LLM).

Il modello quindi trasforma pagine intere di testo ed immagini in rappresentazioni compatte che poi solo un LLM può elaborare direttamente. Quindi per capirci, possiamo definirlo un OCR per LLM più che un OCR per lettura umana. Il vantaggio è che l’OCR creato appositamente per LLM usa meno token; molti meno token di un OCR per umani, quindi è molto più efficiente. Più efficiente significa meno costi per prompt o se usi un API minor costi per token. Meno costi anche in fase di training quando si devono passare milioni di pagine per il training di nuovi modelli linguistici.

DeepSeek-OCR: meno token, più senso

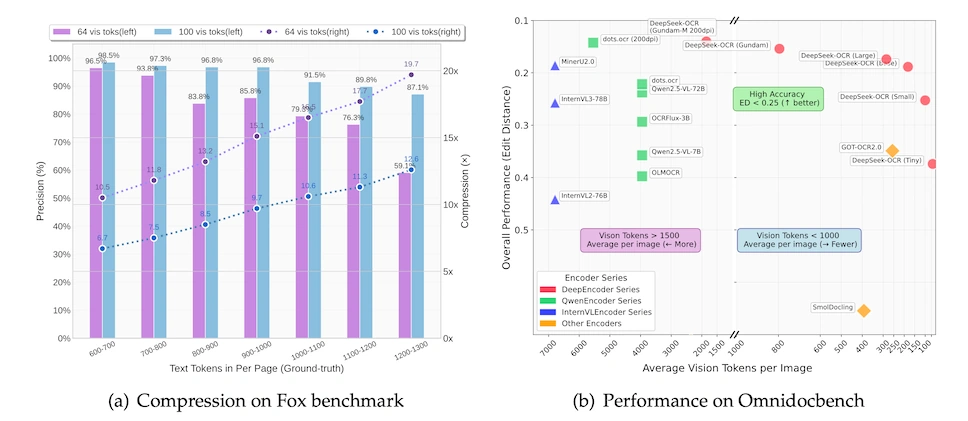

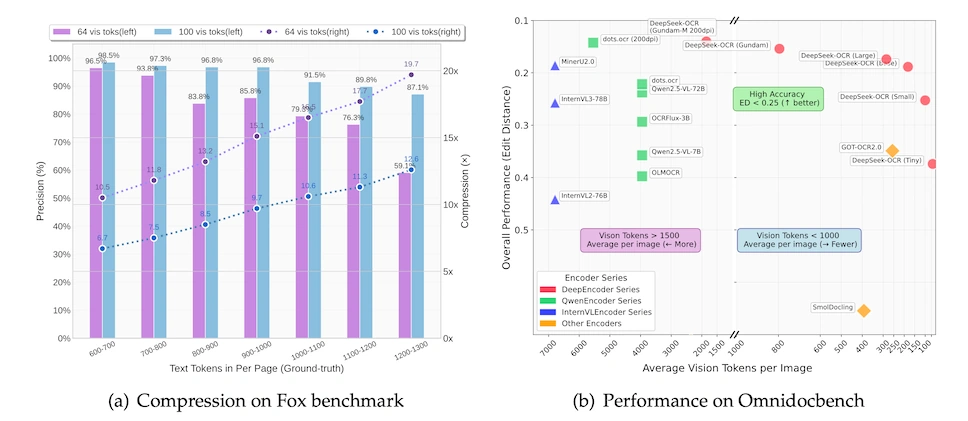

L’approccio di Deepsek rompe con la pratica consolidata di usare decine di migliaia di token per rappresentare e leggere un singolo documento (usando gli OCR tradizionali per “umani“). DeepSeek-OCR riesce a mantenere un’accuratezza OCR del 97% con un rapporto di compressione 10:1 (10 token di testo per ogni token visivo); anche a 20:1, la precisione non crolla, attestandosi intorno al 60%.

DeepEncoder è stato addestrato con un obiettivo di compressione contestuale; deve preservare solo ciò che serve a un LLM per ricostruire il testo e il layout in modo semanticamente corretto, non ogni dettaglio visivo. E deve fare il tutto con la massima efficienza.

In dettaglio, il DeepEncoder è progettato per operare su risoluzioni fino a 1280×1280 pixel; lo fa con un numero di token visivi strettamente controllato. 64 per la versione Tiny, 100 per la Small, 256 per la Base, e 400 per la Large. C’è anche una modalità dinamica chiamata Gundam (hai letto bene!), che combina più risoluzioni per ottimizzare il trade-off tra fedeltà e costo computazionale. Il decoder, basato su Mixture-of-Experts, attiva solo una frazione dei suoi parametri a ogni inferenza, riducendo drasticamente il carico su GPU.

Su un singolo A100-40G, il sistema genera oltre 200.000 pagine al giorno di dati OCR pronti per il training di modelli linguistici. In benchmark come OmniDocBench, DeepSeek-OCR supera GOT-OCR2.0 usando meno della metà dei token visivi (100 contro 256 per pagina); batte MinerU2.0 con meno di 800 token contro i suoi 6000+.

Si possono integrare OCR direttamente in un flusso di inferenza LLM senza dover gestire pipeline esterne; nè parsing separati o formati intermedi. Se prima erano necessarie ore o giorni per pulire output OCR per renderli digeribili a un LLM, puoi capire subito il valore di questa integrazione nativa.

Integrazione pratica: vLLM, Transformers e deployment reale

DeepSeek-OCR può essere usato già da oggi. Il repository GitHub fornisce due percorsi : uno basato su vLLM per inferenza ad alta velocità e throughput, l’altro su Transformers per chi preferisce flessibilità e debug diretto. L’ambiente richiesto è specifico, CUDA 11.8, PyTorch 2.6.0, Python 3.12.9 , e ben documentato. L’installazione richiede attenzione ai dettagli, ma una volta configurato il sistema gira senza sorprese.

Puoi elaborare immagini singole, PDF interi o batch di documenti con script dedicati. Il supporto per risoluzioni native e dinamiche permette di adattare il modello al tuo caso d’uso; se processi migliaia di fatture standardizzate, la modalità Small (640×640) è più che sufficiente; se devi analizzare mappe tecniche o documenti legali densi, passi alla Base o alla Large. Il modello restituisce anche visualizzazioni dei bounding box se richiesto. Il modello è rilasciato sotto licenza MIT, quindi puoi usarlo in produzione, modificarlo, integrarlo in SaaS commerciali senza vincoli legali.

DeepSeek-OCR nel panorama open source: valore reale per sviluppatori e aziende

Quello di Deepseek è un risultato che non si spiega solo con la potenza del decoder, ma con la qualità della compressione visiva; il sistema preserva informazioni strutturali, semantiche e posizionali essenziali per recuperare e lavorare il testo da parte del modello. Secondo la filosofia di DeepSeek il modello OCR è efficiente e trasparente e open source.

DeepSeek-OCR arriva in un momento in cui il mercato è saturo di soluzioni OCR proprietarie costose e poco trasparenti. Offrire un modello open source, efficiente e integrabile direttamente con stack LLM moderni è una scelta che premia chi lavora con volumi elevati e margini stretti — startup, legaltech, fintech, piattaforme di automazione documentale. La licenza MIT rimuove ogni dubbio; il supporto a vLLM garantisce scalabilità; la compatibilità con Transformers assicura flessibilità. È uno strumento pensato per girare già in produzione; con throughput elevati (2500 token/s su A100 per PDF) e requisiti hardware ben definiti.

Se stai valutando alternative a Google Document AI, AWS Textract o Azure Form Recognizer, DeepSeek-OCR merita una prova seria. Per il risparmio sui costi, e per il controllo che ti dà sul flusso di dati. Puoi ispezionare il codice, addestrare varianti specializzate, integrare logiche custom senza dover affidarti a un’API. In un’epoca in cui la data sovereignty e la trasparenza dei modelli sono sempre più richiesti e importanti, DeepSeek-OCR ti permette di tenere i tuoi documenti sotto il tuo controllo, senza compromessi sulla qualità o sulla velocità.