Nvidia ha annunciato da poche ore il lancio di Nemotron 3; una famiglia di tre modelli AI open source progettati specificamente per applicazioni basate su agenti intelligenti. La famiglia comprende tre varianti: Nano, Super e Ultra, ciascuna ottimizzata per diversi scenari d’uso. Nano, il modello più compatto con 30 miliardi di parametri totali e solo 3 miliardi attivi, è già disponibile. Lo puoi trovare anche su Openrouter, completamente gratuito; Super e Ultra arriveranno invece nella prima metà del 2026.

L’architettura ibrida Mamba-Transformer con Mixture-of-Experts (MoE) permette di ridurre drasticamente i requisiti di memoria e calcolo, mantenendo performance elevate. Secondo Jensen Huang, CEO di Nvidia, Nemotron 3 trasforma l’AI avanzata in una piattaforma aperta che offre trasparenza ed efficienza agli sviluppatori.

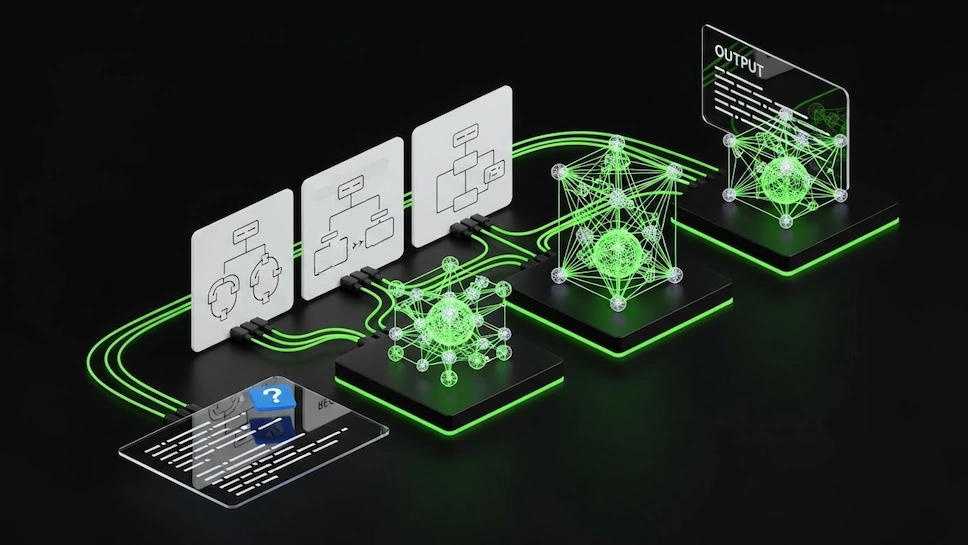

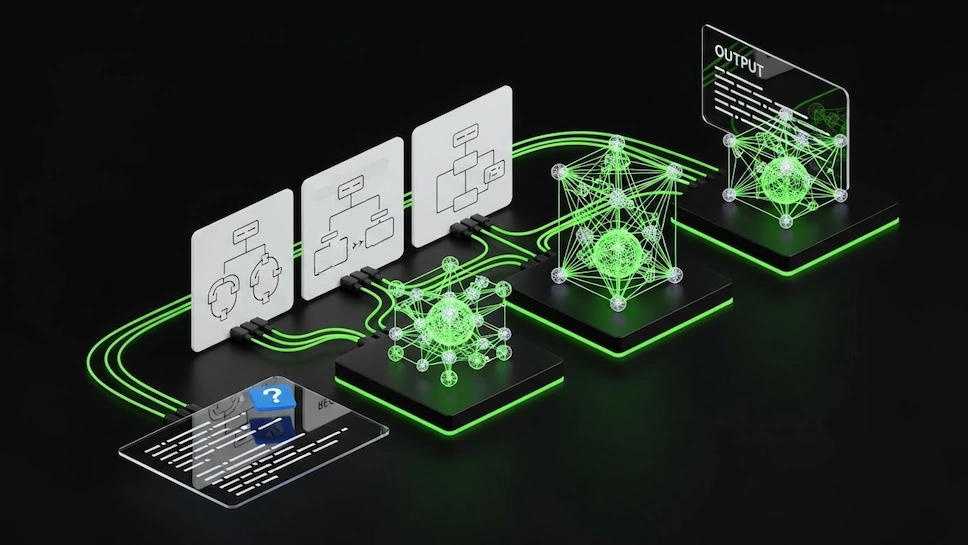

I modelli Nemotron 3 sono anche una vetrina tecnica per mostrare cosa possono fare architetture come Blackwell e GB200 di Nvidia. Nvidia vuole diventare sempre di più un fornitore di soluzioni complete e non solo un venditore di GPU. Secondo Nvidia, l’era dei chatbot basati su singoli modelli sta cedendo il passo agli agenti AI. Gli agenti AI sono in grado di eseguire processi di reasoning, usare tool e coordinare più modelli; inoltre possono richiedere stack RAG e architetture dati avanzate. Nvidia con il suo ecosistema può eseguire tutto questo, e da oggi può offrire modelli + il framework + l’hardware ottimizzato.

Nemotron 3 : architettura e tecnologie all’avanguardia

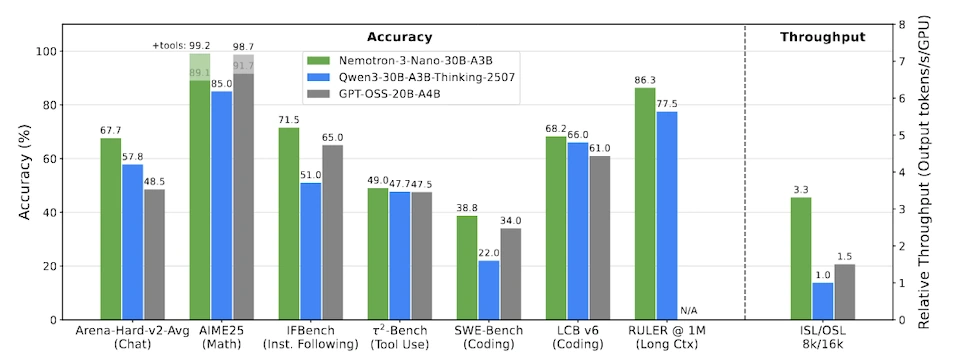

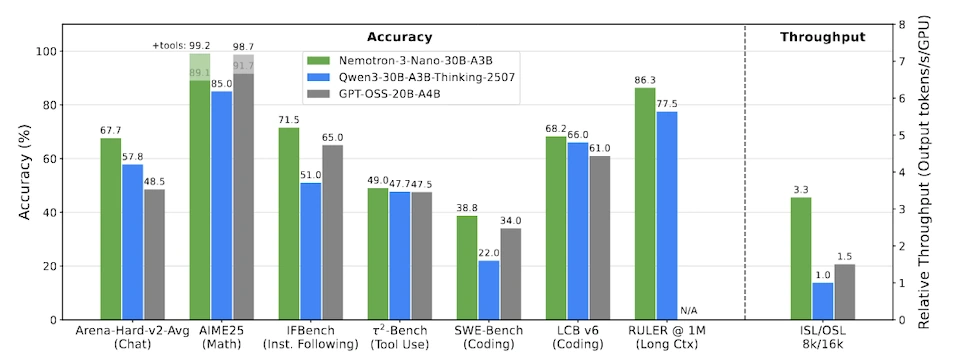

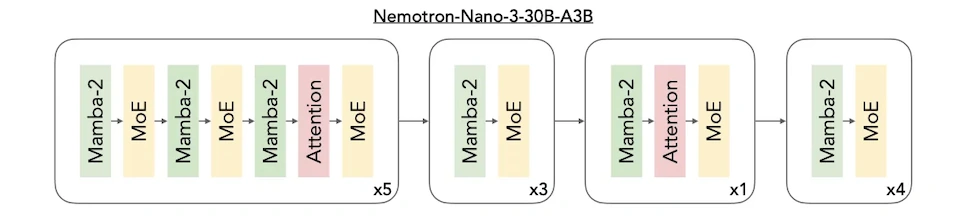

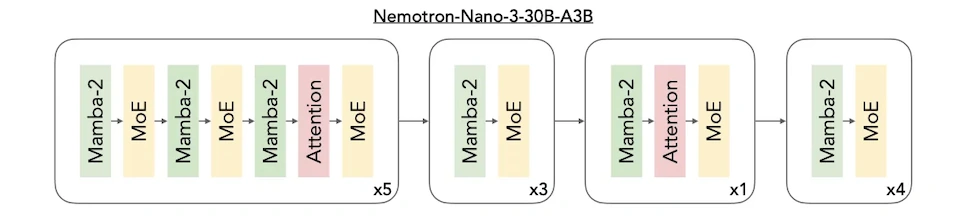

Il cuore tecnologico di Nemotron 3 risiede nell’architettura ibrida MoE (molto in uso nei modelli open source cinesi come Qwen3 Max); combina layer Mamba-2 con strati di attenzione selettivi. Questa configurazione permette un throughput superiore del 3,3x rispetto a modelli comparabili come Qwen3-30B-A3B e GPT-OSS; allo stesso tempo mantiene o supera l’accuratezza dei Transformer standard.

La tecnologia LatentMoE, che sarà introdotta nelle varianti Super e Ultra, riduce il carico di memoria proiettando i token in uno spazio latente più piccolo prima del routing verso gli esperti; questo consente di aumentare sia il numero totale di esperti che quelli attivi per token, migliorando la qualità senza compromettere le prestazioni.

Inoltre il formato NVFP4 per l’addestramento, utilizzato su architettura Blackwell, offre un throughput tre volte superiore rispetto a FP8. I modelli supportano contesti fino a 1 milione di token, fondamentali per analizzare intere codebase o documenti estesi. Infine la Multi-Token Prediction (MTP) nelle varianti più grandi accelera la generazione di testo e migliora la qualità complessiva del modello.

Nemotron 3 : dataset e strumenti di reinforcement learning

Nvidia rilascia insieme ai modelli un ecosistema completo di oltre 10 trilioni di token di dataset curati e librerie di reinforcement learning (RL) per personalizzare agenti AI specializzati. Il dataset Nemotron-CC-v2.1 include 2,5 trilioni di nuovi token inglesi da Common Crawl; includono riscritture sintetiche e traduzioni da altre lingue. Sono disponibili anche dataset specifici per codice, matematica e ragionamento scientifico.

Le librerie open-source NeMo Gym e NeMo RL forniscono ambienti di training; permettono ai team di replicare il processo interno di Nvidia nella creazione di modelli AI. Questo approccio rappresenta un salto qualitativo rispetto all’addestramento supervisionato tradizionale. Nvidia diventa così il primo fornitore a rilasciare ambienti RL all’avanguardia insieme a modelli, librerie e dati; l’obiettivo è aiutare le organizzazioni a addestrare modelli per task specifici e valutare rigorosamente l’affidabilità prima del deployment. Sebbene i modelli Nemotron 3 non richiedano hardware Nvidia per funzionare, sono altamente ottimizzati per piattaforme e GPU Nvidia.

Nvidia vuole consolidare il dominio AI oltre i chip

Il lancio di Nemotron 3 conferma che il vantaggio competitivo di Nvidia non si limita alle GPU, ma si estende all’intero stack software che include CUDA, cuDNN e NeMo. Questa strategia rinforza l’ecosistema Nvidia che incentiva l’adozione reciproca; più sviluppatori usano Nemotron, più rimangono ancorati alle piattaforme Nvidia. Sul fronte competitivo, AMD sta guadagnando terreno con le serie Instinct MI300 e MI350 e il software stack ROCm; tuttavia ora Nvidia mantiene il vantaggio grazie alla profondità dell’ecosistema integrato di modelli, strumenti RL e dataset curati.

La scelta di modelli open-source democratizza l’AI rendendo pesi del modello, architetture e metodologie di training liberamente disponibili a ricercatori, startup e organizzazioni in tutto il mondo. Se migliaia di sviluppatori addestreranno i propri agenti su Nemotron, useranno NeMo, CUDA, TensorRT e di conseguenza compreranno GPU Nvidia.

La domanda per chip H200 dalla Cina, dopo l’approvazione governativa USA di qualche giorno fa, potrebbe rappresentare un ulteriore catalizzatore di crescita. Nemotron posiziona Nvidia come fornitore di riferimento per gli agenti AI. Se l’ecosistema Nemotron riuscirà a imporsi come standard de facto per l‘AI agentica, NVIDIA potrebbe rafforzare ulteriormente la sua posizione di leader indiscusso nell’AI, non solo come fornitore di chip ma come creatore dell’intero stack tecnologico.