Black Forest Labs, laboratorio europeo con radici nel progetto originale di Stable Diffusion, ha lanciato FLUX.1 Kontext, una suite di modelli IA in grado di unificare generazione ed editing di immagini in un’unica architettura. Il fulcro della novità è la capacità del modello di comprendere contemporaneamente input testuali e visivi; mantiene la coerenza stilistica e semantica tra modifiche successive. Non si tratta soltanto di una piattaforma per creare immagini da testo, ma di un sistema che consente di intervenire con precisione su aree specifiche di una scena, trasformandole sulla base di semplici istruzioni.

E’ una novità, infatti a differenza con altri modelli generativi di immagini ha la capacità di modificare a richiesta un immagine e di mantenerne la coerenza con l’immagine di partenza.

L’editing di una immagine è localizzato, coerente e immediato. Il sistema, accessibile anche tramite API si rivolge a creativi, sviluppatori e aziende che necessitano velocità, controllo e qualità nella produzione visiva.

Puoi provare gratuitamente FLUX.1 Kontext anche tramite il sito ufficiale di Black Forest Labs all’indirizzo https://playground.bfl.ai. E’ sufficiente caricare un’immagine o scrivere un prompt testuale per iniziare subito a sperimentare. Le versioni disponibili includono Kontext [pro] per i flussi iterativi e Kontext [max] per prestazioni estreme su prompt complessi; è previsto anche il rilascio di Kontext [dev], pensato per la ricerca e la personalizzazione.

In-Context Editing: coerenza stilistica e precisione narrativa

Il cuore di FLUX.1 Kontext sta nella capacità di gestire modifiche visive in modo in-context; ovvero partendo da un’immagine di riferimento e da un testo, per guidare modifiche senza rigenerare l’intera scena. Questo approccio riduce drasticamente i tempi di produzione; basta un comando come “sostituisci la scritta sul cartello con ‘Chiuso per ferie’” per vedere l’edit applicato senza artefatti e senza alterare lo sfondo. Il modello è in grado di interpretare contesti complessi. Modifica solo ciò che serve e preserva tutto il resto: composizione, luci e stile tipografico.

L’architettura di FLUX.1 Kontext è basata su un flusso generativo potenziato, con un trasformatore da 12 miliardi di parametri ottimizzato per eseguire il rendering in appena 3-5 secondi. Questo consente un uso iterativo: ogni comando può aggiungersi al precedente, creando una catena coerente di modifiche. Gli scenari d’uso spaziano dalla creazione di storie visive alla produzione pubblicitaria; fino alla generazione di contenuti personalizzati su larga scala, mantenendo sempre intatti elementi chiave come volti, oggetti o brand.

Caratteristiche tecniche e vantaggi

FLUX.1 Kontext si differenzia non solo per la velocità di inferenza, ma anche per la fidelizzazione degli elementi visivi. Un personaggio, un’auto, un oggetto di scena mantengono le stesse caratteristiche anche se inseriti in contesti diversi. Un aspetto importante per brand che devono garantire coerenza iconografica su campagne diverse. Le funzionalità più avanzate includono:

- Editing testuale on-image: cambia scritte su insegne, etichette e manifesti senza alterare stile e contesto.

- Trasferimento di stile: applica il look di un’immagine a scene generate da zero.

- Modifiche localizzate: agisce su porzioni limitate della scena lasciando il resto intatto.

FLUX.1 Kontext offre un’infrastruttura stabile e scalabile tramite provider come FAL, Replicate, TogetherAI e DataCrunch. La versione [dev], disponibile su richiesta per ricerca e sviluppo, permette una maggiore personalizzazione e l’integrazione in pipeline proprietarie.

Confronto con i modelli concorrenti

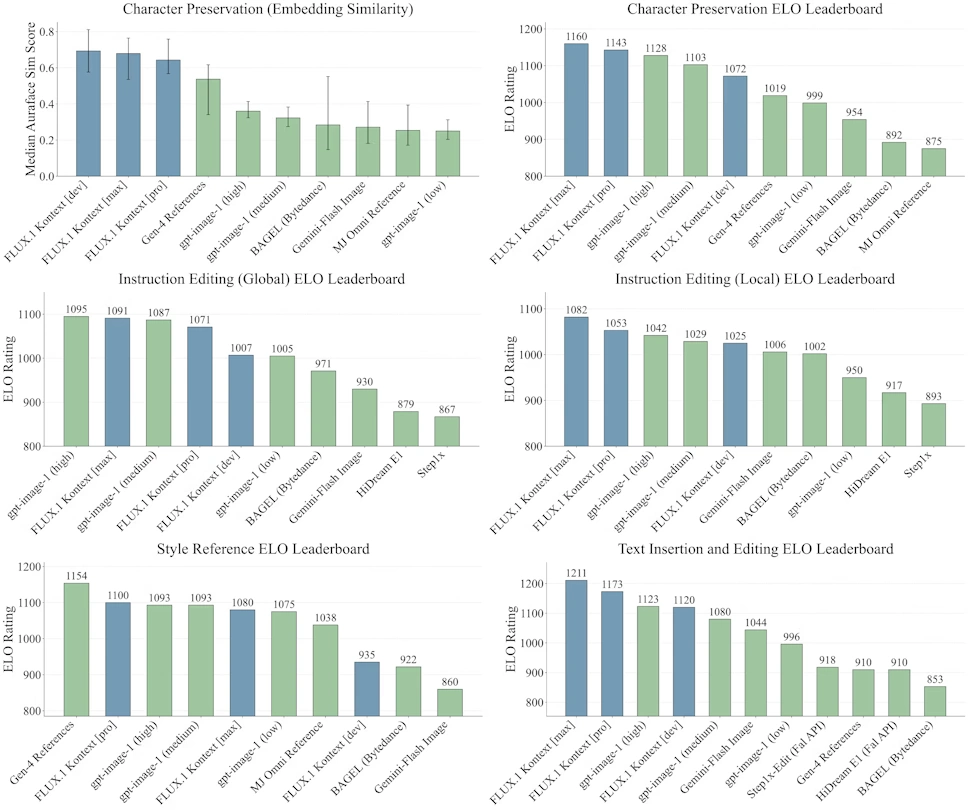

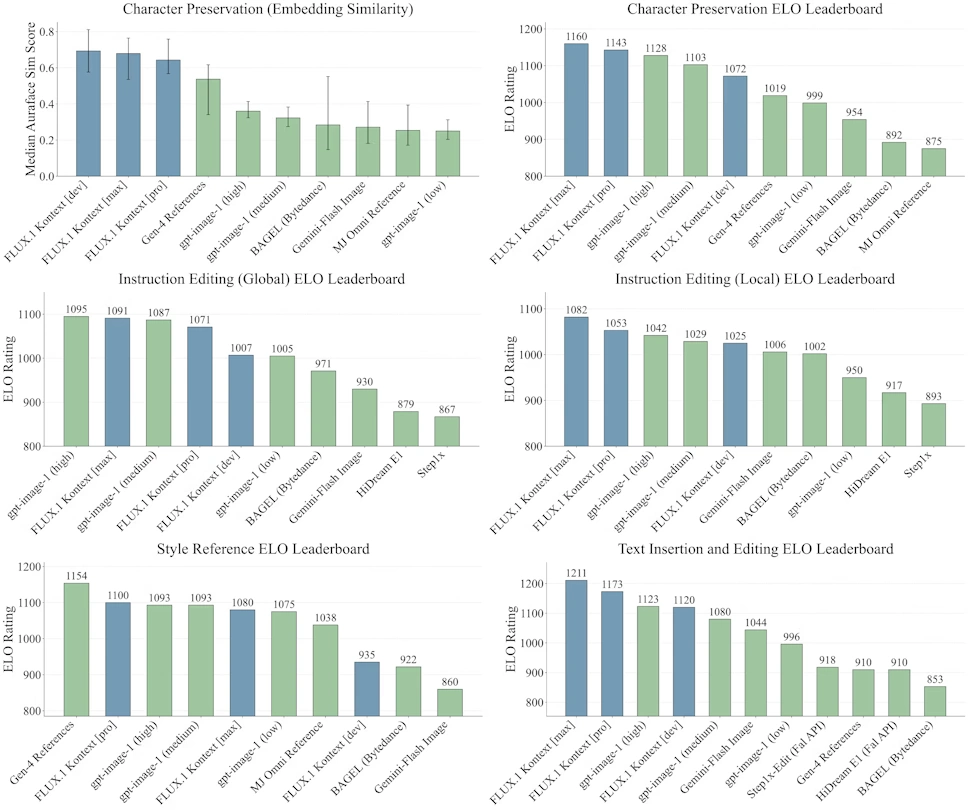

I test condotti da Black Forest Labs hanno evidenziato prestazioni di rilievo, misurate attraverso la suite KontextBench, pensata per valutare precisione nei prompt, velocità di esecuzione e coerenza visiva. Nei benchmark, Kontext [pro] supera modelli noti come Midjourney, GPT-Image-1 e Stable Diffusion XL, soprattutto nei casi d’uso che richiedono conservazione del personaggio e modifiche testuali sul campo visivo.

Le inferenze avvengono in 3–5 secondi per immagini da 1 megapixel, con tempi fino a otto volte inferiori rispetto a modelli equivalenti; FLUX.1 Kontext gestisce meglio modifiche sequenziali senza degradare l’immagine. Un limite comune con altri modelli di generazione immagine che tendono a reinventare l’intera scena.

Nel confronto con Imagen 4 di Google e le ultime versioni DALL·E, FLUX.1 Kontext si distingue per consistenza tipografica, precisione nell’editing localizzato e capacità di seguire il prompt in modo rigoroso. Anche le funzionalità di reference style transfer e l’integrazione fluida tra testo e immagine risultano più affidabili, rendendolo particolarmente adatto a flussi editoriali e creativi professionali.

Conclusione: un ponte tra creatività e automazione

Con FLUX.1 Kontext non è più necessario scegliere tra generazione da zero ed editing successivo; tutto avviene in un unico ciclo, con risultati coerenti, modificabili e veloci. Da ora i creativi possono prototipare, correggere e finalizzare contenuti in tempi ridotti; i brand possono mantenere il controllo visivo senza cambiare il risultato finale dell’immagine.

L’approccio instruction-based introduce un linguaggio nuovo, più vicino al pensiero umano che alla programmazione, e rende accessibile l’editing avanzato anche a chi non ha competenze tecniche. FLUX.1 Kontext non punta soltanto a fare meglio, ma anche velocemente; si va verso un cambio radicale sul modo di lavorare con le immagini.